温馨提示:这篇文章已超过566天没有更新,请注意相关的内容是否还可用!

摘要:阿里云服务器爬虫指南提供了高效数据抓取方法与技巧详解。使用阿里云服务器爬虫可以方便地抓取数据,但需要掌握一定的技巧。本文介绍了如何高效抓取数据的方法和技巧,包括选择合适的爬虫框架、设置合理的爬取策略、优化数据解析等。通过本文的指导,读者可以轻松地利用阿里云服务器爬虫进行数据抓取和处理。

本文将介绍如何利用阿里云服务器爬虫高效地进行数据抓取工作,我们将深入探讨数据抓取的方法和技巧,包括选择合适的爬虫框架、遵守网站协议与爬虫伦理、利用云服务器优势、关注搜索引擎工作原理、网页抓取方法、使用API接口获取数据、数据清洗与存储、应对反爬策略、代理IP的使用等,本文旨在为使用阿里云服务器爬虫的读者提供全面的指南,帮助他们高效抓取所需数据。

选择合适的爬虫框架

使用如Scrapy这样的爬虫框架能够高效抓取网页数据,Scrapy提供了强大的抓取和解析功能,能够自动处理网页请求和响应,并提供灵活的数据提取和处理方式。

遵守网站协议与爬虫伦理

在采集数据时,务必遵守各网站的使用协议和爬虫伦理,注意分析网站的反爬机制,并采取相应的策略应对,以避免过度抓取和侵犯他人权益。

利用云服务器优势

利用阿里云服务器的高性能,可以大幅提升爬虫的工作效率,通过控制单IP抓取速度在网站允许的范围内,并使用多条ADSL或VPN切换IP,以避免被网站封禁。

关注搜索引擎工作原理

了解搜索引擎的工作原理有助于优化爬虫策略,提高数据抓取效率,搜索引擎蜘蛛从服务器出发,沿着已有的URL抓取网页内容,并对网页进行分析和收录。

网页抓取方法

1、使用Python的Requests库请求网页,然后用Beautiful Soup库进行页面解析,提取目标数据。

2、使用Selenium库模拟浏览器操作,通过CSS Selector或XPath定位数据。

使用API接口获取数据

另一种高效的数据获取方式是使用网站的API接口,查看网站开发者文档,了解如何使用API接口获取数据,这种方式速度快且准确。

数据清洗与存储

在采集过程中,要关注数据清洗和存储工作,对抓取到的数据进行去重、纠错、格式转换等处理,并选择合适的数据存储方式,如数据库或文件存储。

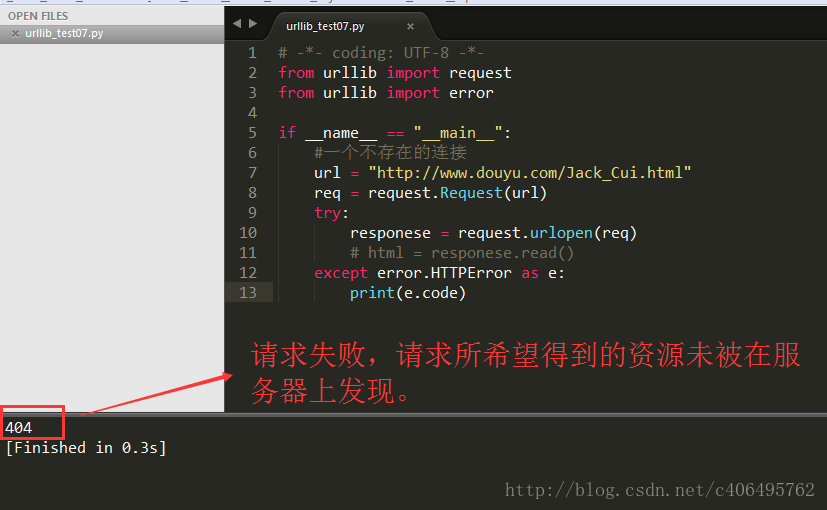

应对反爬策略

若遇到网站反爬策略,如通过robotstxt文件屏蔽爬虫,可以采取修改User-agent或按照网站规定的时间间隔发送请求等策略进行应对。

代理IP的使用

为了应对IP被封锁的问题,可以使用代理IP,根据需要选择提取数量、代理协议格式等,生成API链接后进行使用。

Python爬虫的应用领域

Python爬虫主要用于抓取证券交易数据、天气数据、网站用户数据和图片数据等,Python内置了大量支持网络爬虫正常功能实现的库,这些库主要可分为请求库、解析库、并发库等类型。

十一、网络爬虫的挑战与解决方案

除了之前提到的挑战和解决方案,网络爬虫在实际应用中还可能面临数据质量和完整性的挑战,确保数据的准确性和有效性是非常重要的,在实际应用中,还需要注意以下几点:熟悉阿里云的服务器配置和网络环境、熟悉阿里云的安全策略和服务支持、关注阿里云的优惠活动以降低成本投入、遵守法律法规和道德伦理、不断学习新的技术和知识以适应不断变化的网络环境和技术需求。

通过遵循以上指南和建议,用户可以更有效地利用阿里云服务器进行网页数据抓取工作,无论是初学者还是资深开发者,都能从中获得有益的指导和启示。

还没有评论,来说两句吧...