温馨提示:这篇文章已超过469天没有更新,请注意相关的内容是否还可用!

摘要:TimeXer技术探索利用Transformer模型进行时间序列预测,通过引入外部变量来增强模型的预测能力。该技术旨在解决传统Transformer模型在处理时间序列数据时面临的挑战,如缺乏上下文信息和时序依赖性。TimeXer通过结合外部变量和Transformer模型的优势,提高了时间序列预测的准确性,为相关领域的研究和应用提供了新思路。

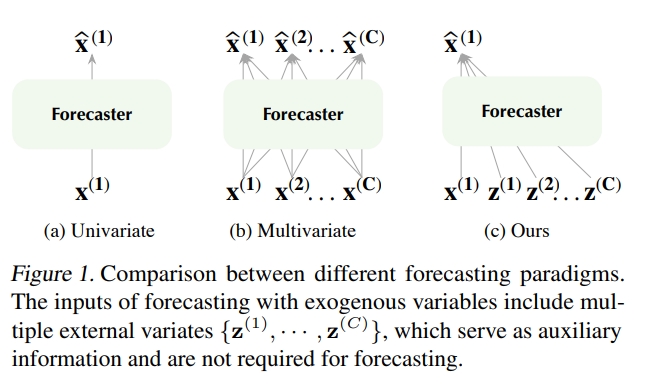

近期研究表明,在结合外部变量时,时间序列预测的性能可以显著提高,由于现实世界应用中的部分观察性质,仅依赖目标变量的内部信息往往难以保证精确预测,外部序列能够为内部变量提供宝贵的外部信息,针对这一挑战,本文提出了一种新型框架——TimeXer,旨在利用这些外部信息增强内部变量的时间序列预测。

背景与意义

TimeXer的设计旨在解决如何有效地结合内部变量和外部变量进行时间序列预测的问题,在现实世界的应用中,时间序列数据往往受到多种因素的影响,而外部变量可以提供对这些因素的描述,从而辅助内部变量的预测,现有的时间序列预测方法在处理外部变量时面临挑战,如如何有效地结合内外部信息、如何处理不同来源的数据等,TimeXer框架旨在解决这些问题,提高预测性能。

TimeXer框架的主要创新点包括:

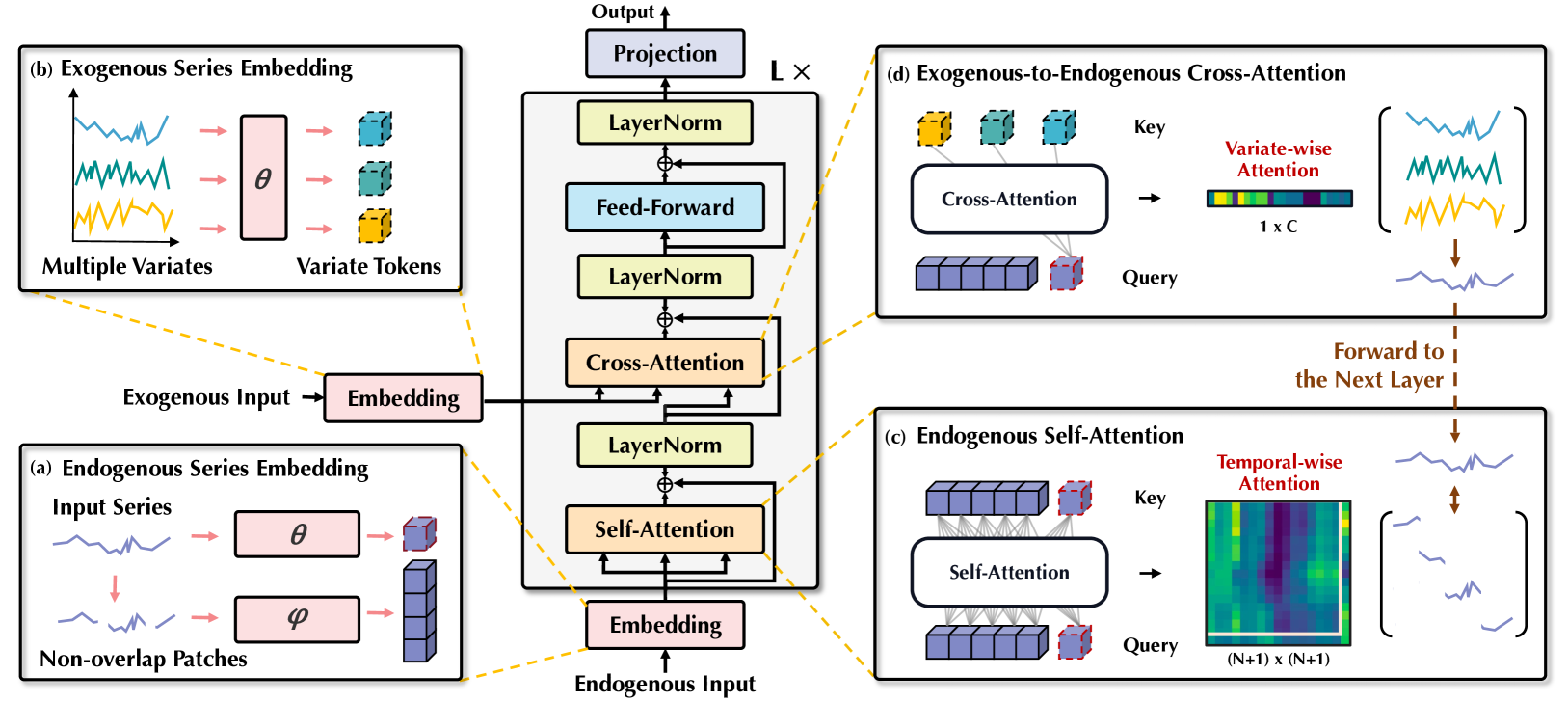

1、嵌入层设计:使标准的Transformer架构能够协调内源和外源信息。

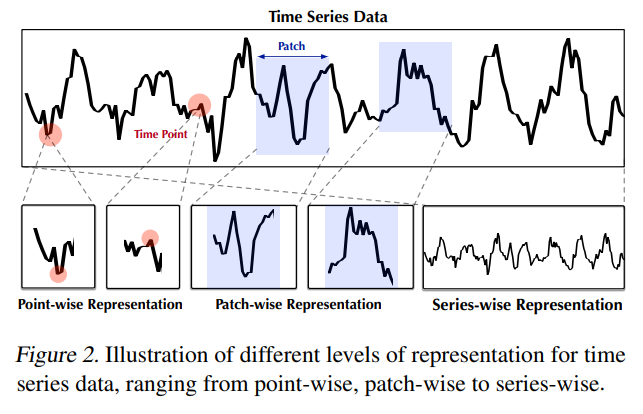

2、采用patch-wise self-attention和variate-wise cross-attention机制,通过全局内部变量tokens有效地将外部序列桥接到内部时间补丁中。

实验验证与性能评估

为了验证TimeXer的有效性,论文进行了一系列实验,包括数据集选择、基线模型对比、预测性能评估等,实验结果表明,TimeXer在多个真实世界的时间序列预测任务中取得了最先进性能,论文还通过消融研究、模型效率分析、表示学习分析和可视化分析等方法,深入探讨了TimeXer的优越性能。

进一步探索的方向

尽管TimeXer已经取得了显著的成果,但仍有一些潜在的研究方向可以进一步探索,如模型泛化能力、计算效率优化、不确定性量化、多任务学习等,长期依赖性建模、可解释性和透明度、数据不平衡和缺失处理、实时预测和在线学习以及跨领域知识迁移等也是未来研究的重要方向。

本论文提出了一种名为TimeXer的新型框架,旨在增强Transformer模型在时间序列预测中的性能,同时有效利用外部变量提供的额外信息,通过设计嵌入层、采用自注意力和交叉注意力机制等方法,TimeXer能够捕捉内部和外部变量之间的依赖关系,提高预测的准确性和可靠性,实验结果证明了TimeXer在多个真实世界时间序列预测任务中的优越性。

还没有评论,来说两句吧...