温馨提示:这篇文章已超过409天没有更新,请注意相关的内容是否还可用!

摘要:Yolov8n可轻松部署于瑞芯微RKNN、地平线Horizon等芯片上,通过TensorRT加速部署工程,降低部署难度,提高模型推理速度。瑞芯微RKNN、地平线Horizon与TensorRT的联合,实现了高效的模型推理。Yolov8n的部署过程简单,可快速实现高性能的目标检测。

YOLOv8n模型轻松部署在瑞芯微RKNN和地平线Horizon等芯片上,通过TensorRT进行部署,工程难度大幅降低,模型推理速度显著提升,结合瑞芯微RKNN和地平线Horizon芯片的强大性能,实现了高效的模型推理,该部署方案具有简单易用、性能卓越的特点,为人工智能应用提供了强有力的支持。

介绍:

本文主要介绍了YOLOv8模型在瑞芯微RKNN和地平线Horizon等芯片上的部署流程,以及通过TensorRT进行部署的优势,该部署方案解决了之前YOLOv8模型部署存在的两大问题:部署难度大和模型推理速度慢,经过研究和实践,本文提供了一种简便、高效的部署方式。

模型和训练:

本文使用的训练代码基于官方开源的YOLOv8训练代码,通过优化训练过程,提高了模型的性能。

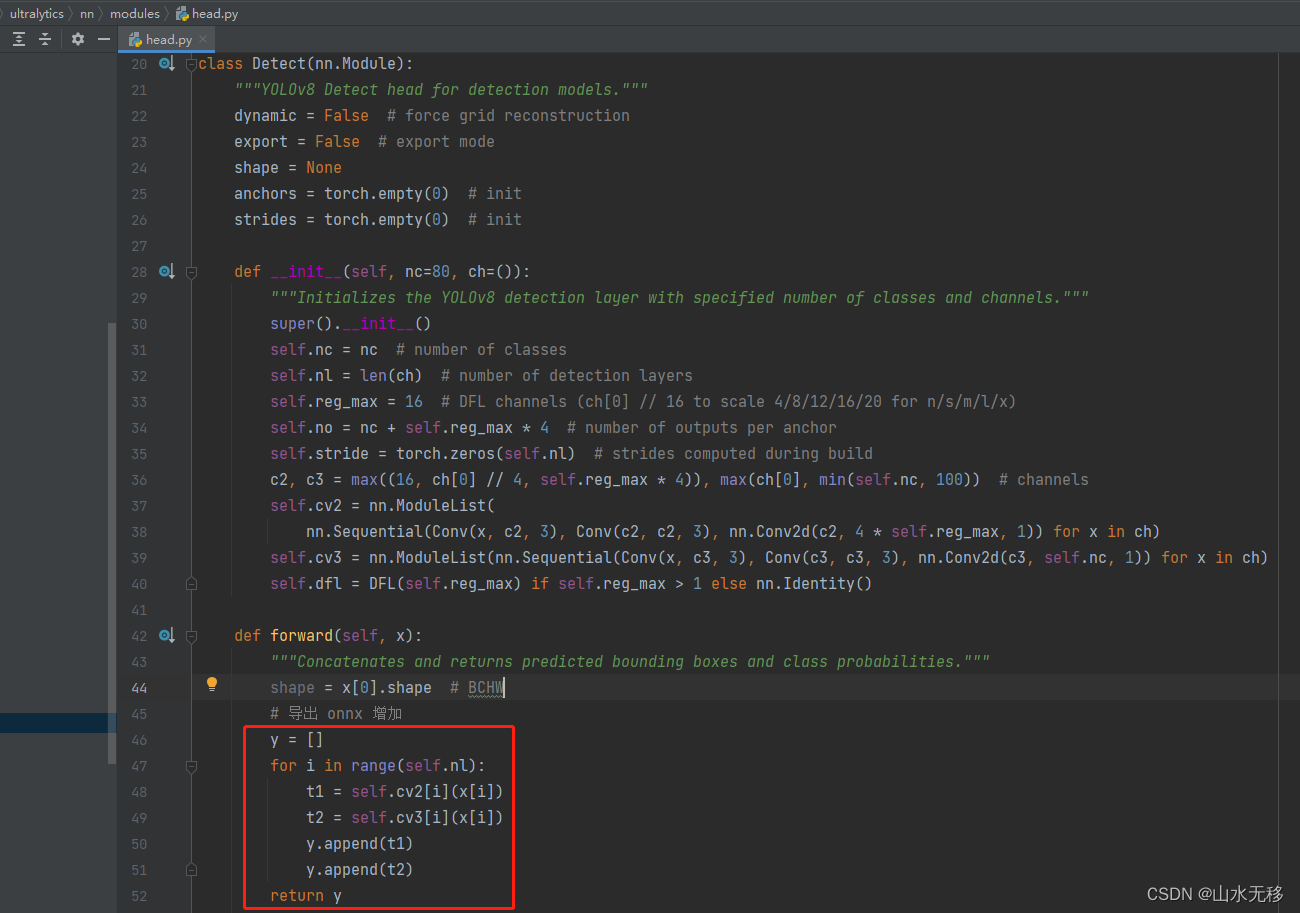

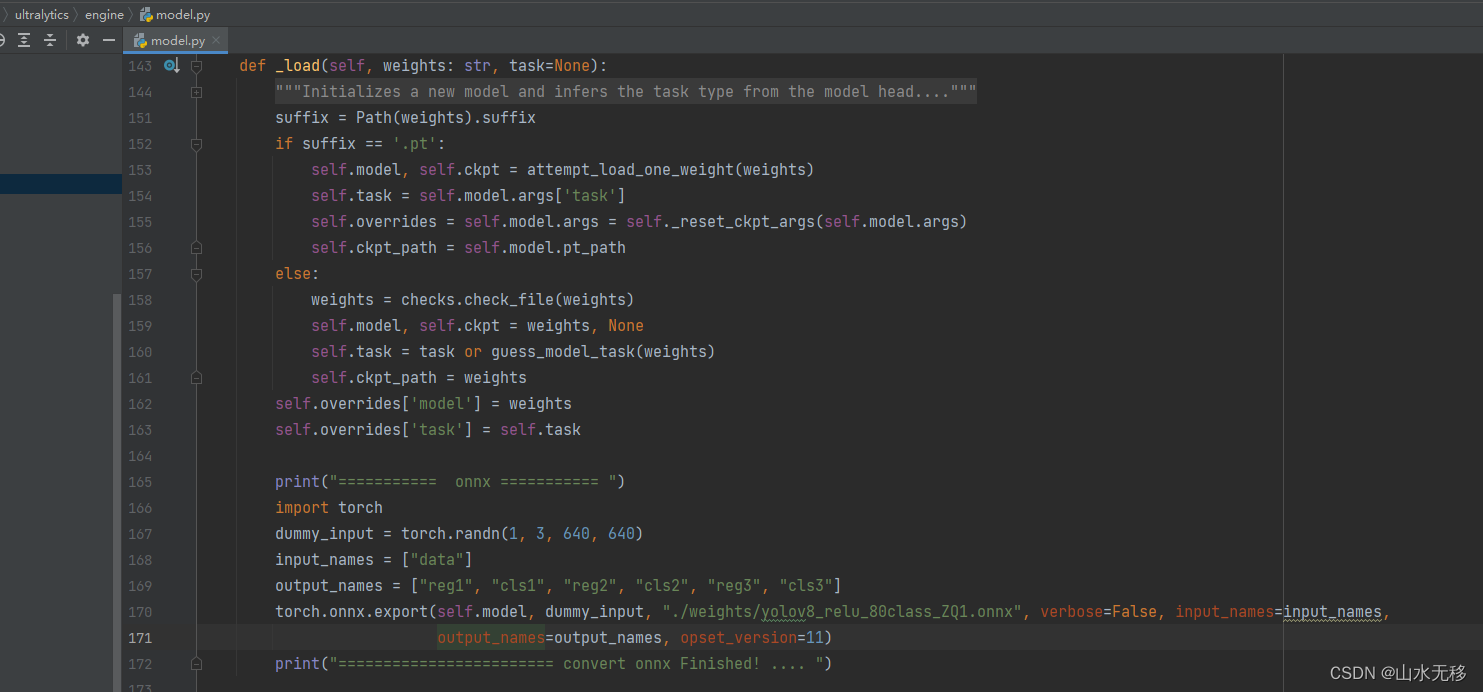

导出YOLOv8 ONNX模型:

为了在不同的平台上进行模型推理,我们将YOLOv8模型导出为ONNX格式,在导出过程中,增加了特定的代码片段以适应ONNX模型的导出,并提供了详细的保存ONNX模型的步骤。

YOLOv8 ONNX 测试效果:

本文展示了ONNX模型和完整的测试代码,可通过GitHub下载,测试结果显示,YOLOv8模型在目标检测任务中表现出优异的性能。

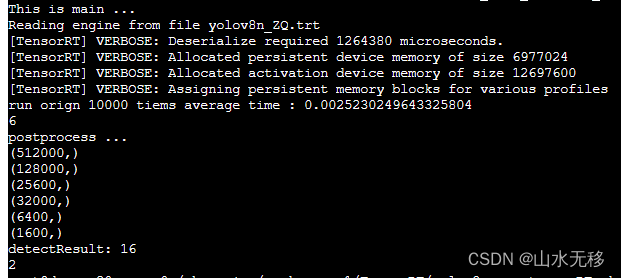

TensorRT优化前后时耗对比:

本文对比了使用TensorRT部署前后的推理时耗,结果显示,经过优化的部署方案在推理速度上有了显著的提升。

RKNN板端C++部署:

本文提供了完整的C++部署代码和模型示例,相较于之前在RK3588上的推理时耗,本文的部署方法将时耗降低到了17ms,还提供了后处理代码的优化版本,以进一步降低后处理的时耗。

本文详细描述了YOLOv8模型的部署过程,包括模型训练、导出为ONNX格式、测试效果、TensorRT优化前后的时耗对比以及RKNN板端C++部署,通过优化,本文提供了一种快速、高效的YOLOv8模型部署方法,为实际应用提供了便利。

希望这个整理后的内容对您有所帮助,您提供的图片和描述可能需要根据实际情况进行替换和调整,以确保与文章内容相符。

还没有评论,来说两句吧...