温馨提示:这篇文章已超过411天没有更新,请注意相关的内容是否还可用!

摘要:在第六天的Yolov8实战中,我们将重点介绍如何使用TensorRT C++部署Yolov8模型。本教程为保姆级攻略,包括部署过程中的踩坑与平坑策略,旨在为开发者提供全面的部署详解,确保顺利将Yolov8模型应用于实际场景中。

我们将详细介绍yolov8实战第六天的核心内容,重点关注yolov8的TensorRT C++部署流程,本文旨在帮助读者理解并掌握yolov8 TensorRT C++部署的关键步骤和注意事项,同时提供保姆级别的教程以指导读者顺利部署模型,在部署过程中可能遇到的常见问题及解决方案也将一一阐述。

C++结合TensorRT部署深度学习模型的优势:

1、高效的性能:TensorRT通过优化深度学习模型来提高推理速度,减少延迟,这对于实时处理应用如视频分析、机器人导航等至关重要。

2、降低资源消耗:TensorRT在GPU上高效运行模型,降低内存占用并提高吞吐量,尤其适用于资源受限的环境或多任务并行处理的情况。

3、跨平台和硬件兼容性:C++是一种跨平台语言,结合TensorRT,可在多种硬件和操作系统上部署深度学习模型,包括嵌入式设备和服务器。

4、准确性和稳定性:TensorRT采用精确的数学和统计方法,减少浮点运算误差,确保深度学习应用的准确性和稳定性。

5、定制和灵活性:开发者可以使用C++和TensorRT高度定制他们的深度学习应用,包括调整模型结构、优化算法和调节性能参数以满足特定需求。

6、支持复杂网络和大规模部署:TensorRT支持最新的深度学习网络结构,并能处理复杂的计算任务,适用于需要部署大型、复杂网络的工业应用。

7、易于集成和扩展:C++提供了与其他系统和工具集成的灵活性,TensorRT也可轻松集成到其他NVIDIA工具链中。

准备部分补充:

在下载YOLOv8项目和Tensorrt部署项目时,请确保选择官方或可信赖的源,以确保项目的完整性和正确性,注意保存yolov8s.pt模型文件的完整性,并在ultralytics目录下正确放置。

环境准备部分补充:

在安装Visual Studio时,请确保选择包含C++桌面开发的组件,在安装CUDA和cudnn时,按照官方指南操作,并注意版本兼容性,配置环境变量时,确保opencv和tensorrt的路径正确设置。

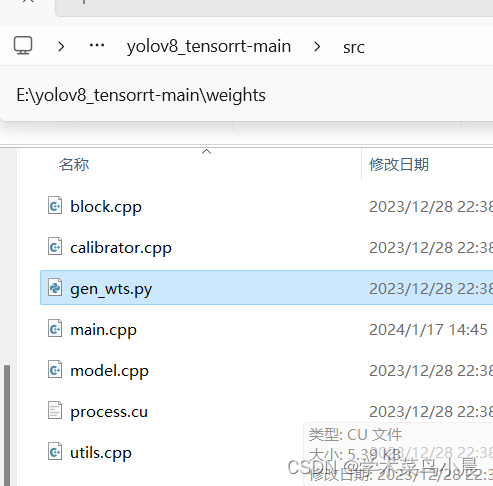

编译部分补充:

使用cmake编译时,请仔细阅读cmake的配置选项,确保正确填写opencv和tensorrt的路径,遇到编译问题时,查看错误日志,根据提示解决。

运行和调试部分补充:

运行程序前,确保所有配置正确无误,输出检测结果后,可以根据实际需求进一步优化性能或调整模型参数,如果遇到问题,可以查阅C++代码进行调试。

建议您在文章最后提供一些额外的资源链接或常见问题解答,以便读者在遇到问题时能够找到更多的帮助。

希望以上内容能对您有所帮助!如有任何疑问或需要进一步的解释,请随时提问。

还没有评论,来说两句吧...