论文题目:Early Convolutions Help Transformers See Better

早期的卷积网络帮助transformers性能提升

vit 存在不合格的可优化性,它们对优化器的选择很敏感。相反现代卷积神经网络更容易优化。

vit对优化器的选择[40](AdamW [27] vs. SGD),对特定于数据的学习超参数的选择[13,40],对训练计划长度,网络深度[41]等都很敏感。这些问题使得以前的训练食谱和直觉无效,阻碍了研究

为什么vit会有这样的问题:ViT将输入图像“贴片”为p×p不重叠的贴片,以形成转换器编码器的输入集。这个补丁系统是作为一个stride-p p×p卷积实现的,p = 16是默认值。这种大内核加大步幅卷积与典型的设计背道而驰

相互融合之后与原始cnn相比的好处是:vit用多头自注意进行的全局处理取代了卷积固有的局部处理的归纳偏见[42]。这种设计有可能提高视觉任务的性能,类似于在自然语言处理中观察到的趋势

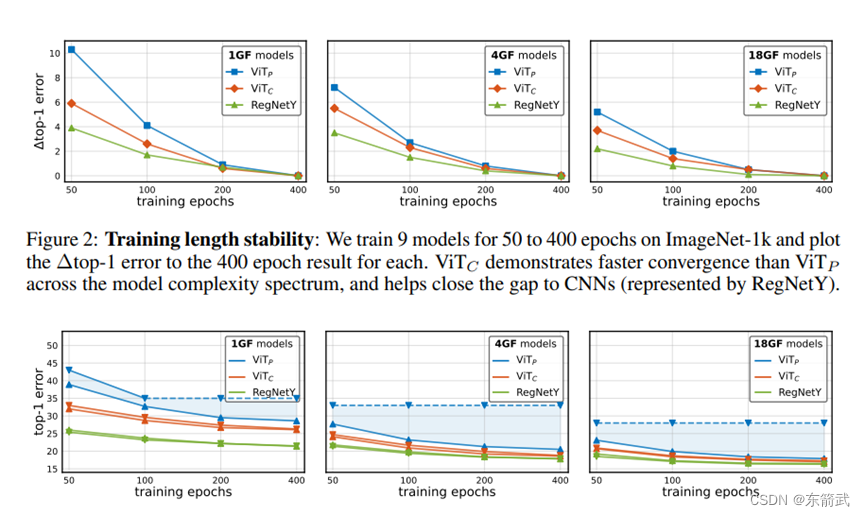

.vit+cnn融合之后的好处:在ViT中使用卷积干可以显著提高优化稳定性,并提高峰值性能(在ImageNet-1k中提高1-2%的top-1精度),同时保持故障和运行时间. 这种改进可以在模型复杂性(从1G到36G)和数据集规模(从ImageNet-1k到ImageNet-21k)的广泛范围内观察到

具体改进:

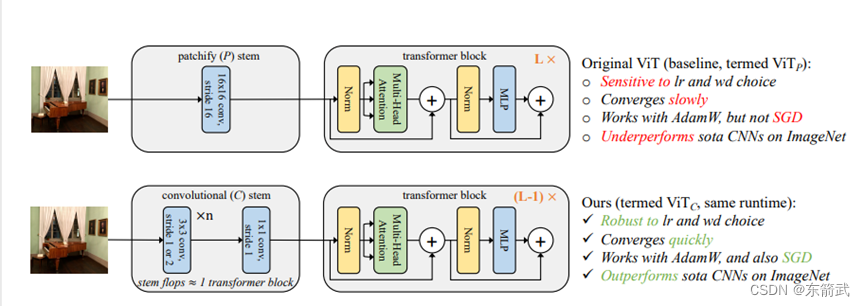

作者推测,与cnn相比,ViT模型的次优性主要源于其patchify系统执行的早期视觉处理,该系统由非重叠stride-p p×p卷积实现,默认p = 16。我们用一个只有~ 5个卷积的标准卷积系统最小限度地替换了ViT中的补丁系统,该系统与单个变压器transformer blocks块具有大致相同的复杂性。我们将变压器块的数量减少了一个(即,L−1 vs. L),以维持一致性失败、参数和运行时间。我们将得到的模型称为ViTC,将原始的ViT称为vitp。这两个模型执行的绝大多数计算是相同的,但令人惊讶的是,我们观察到ViTC (i)收敛得更快,(ii)第一次使用AdamWor SGD而没有显着的精度下降,(iii)在学习率和权重衰减选择方面表现出更大的稳定性,(iv)在ImageNet top-1误差方面取得了改进,使ViTC优于最先进的cnn,而ViTP则没有

另外作者测试了这个vitc模型

还没有评论,来说两句吧...