温馨提示:这篇文章已超过465天没有更新,请注意相关的内容是否还可用!

摘要:本笔记分享是关于深度学习领域中的GPT模型搭建的内容,由Andrej Karpathy分享。该笔记详细介绍了从头开始搭建GPT模型的过程,包括模型架构、训练方法和优化技巧等。通过本笔记,读者可以了解GPT模型的原理和实现细节,掌握深度学习领域的前沿技术。该笔记对于深度学习爱好者、研究人员和开发者都具有重要的参考价值。

本笔记详细介绍了由Andrej Karpathy主导开发的GPT模型,从原理到实现过程,涵盖了数据预处理、模型架构、训练与优化等关键步骤,通过本笔记,读者可深入了解GPT模型的构建过程及其在自然语言处理领域的应用和优势。

数据处理

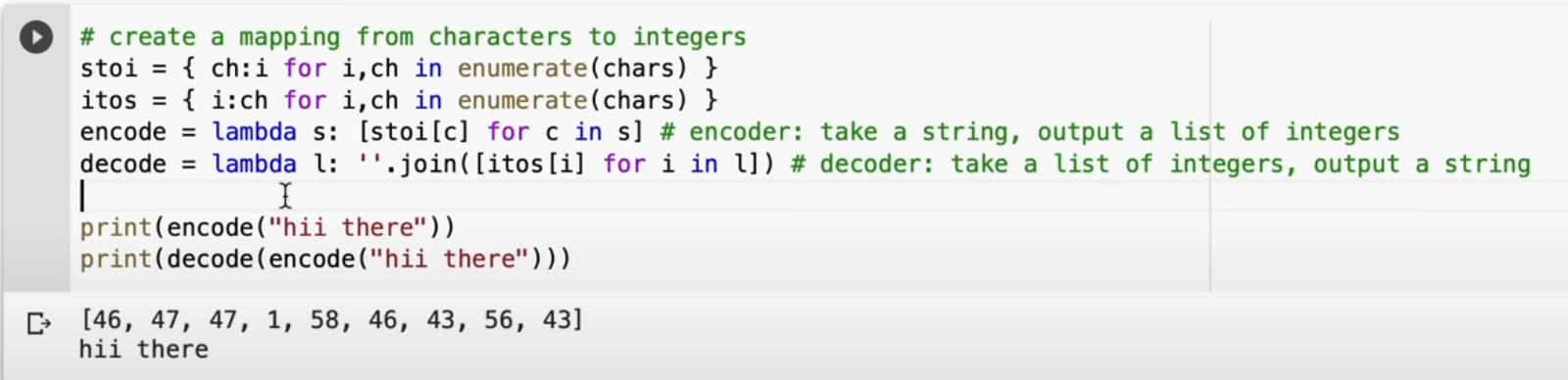

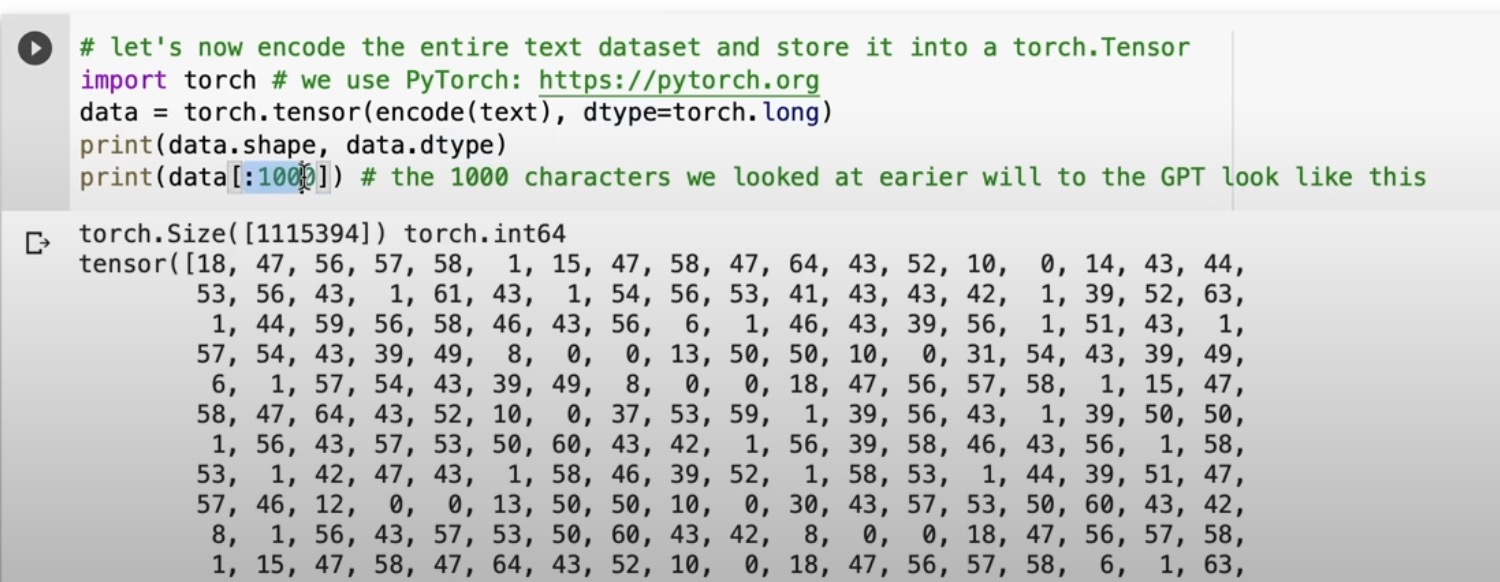

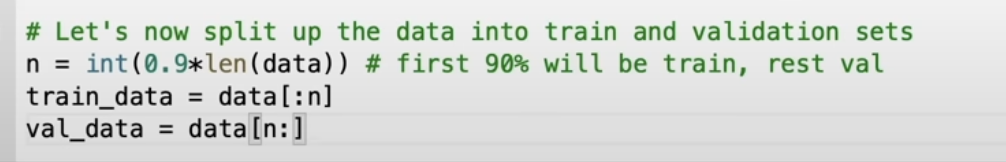

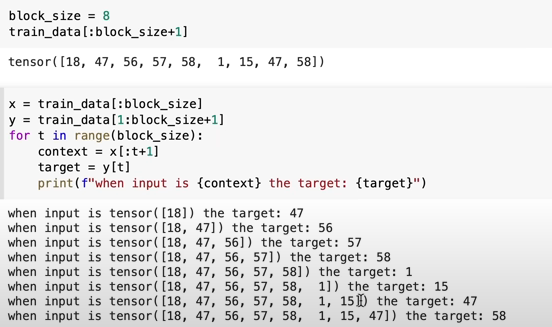

在数据处理阶段,GPT模型采用了多种技术进行处理,使用到了google的sentence piece和OpenAI的分词器进行tokenization,值得一提的是,OpenAI使用的是其独有的分词器,称为“GPT分词器”。

计算Loss

在模型的训练过程中,采用cross entropy来计算loss,为了生成logits,模型采用了一种名为“连接层”(connection layer)或“输出嵌入”(output embeddings)的结构,然后计算与真实标签之间的cross entropy loss。

Self-Attention机制

在self-attention部分,通过query和key的点积来计算注意力分数,在计算权重时,还需应用softmax函数,确保权重总和为1,这样,模型能够捕捉到输入序列中各个元素之间的依赖关系。

GPT模型的独特训练步骤

1、Pre-training阶段:在pre-training阶段,GPT模型只使用decoder部分,并采用双向的self-attention机制,每个token都能关注到它之前和之后的所有token。

2、Fine-tuning阶段:在fine-tuning阶段或生成文本时,为了遵循语言的时间顺序性,GPT模型采用单向的自注意力机制,这一阶段通常需要对模型进行微调,使其适应特定的任务或数据集,通常使用监督学习的方法来最小化预测结果与真实结果之间的loss。

五、Transformer中的FeedForward网络(FFN)

FFN在GPT模型中扮演着增加模型非线性能力的角色,它通常包括两个线性层和一个非线性激活函数(如ReLU),在GPT模型中,FFN的输出维度会扩大,但在后续的层中会再次缩小到原始维度。

六、Layer Normalization与Pre-Normalization(Pre-norm)

近年来,Pre-norm在transformer模型中的使用越来越普遍,因为它有助于解决深度网络中的训练问题,GPT模型也采用了这一技术,以提高模型的训练效果。

本笔记详细解析了GPT模型的构建过程,从数据处理到模型训练,每个步骤都有详细的解释和图示,对于不熟悉GPT模型的人来说,这是一个很好的入门教程,希望通过本笔记,读者能够对GPT模型有更深入的了解,并能在自然语言处理领域应用这一强大的模型。

还没有评论,来说两句吧...