温馨提示:这篇文章已超过466天没有更新,请注意相关的内容是否还可用!

GPT-Crawler实现一键爬虫构建GPTs知识库的功能。通过简单的操作,用户可以轻松抓取互联网上的信息,并构建自己的知识库。这一技术为用户提供了便捷的数据获取方式,能够快速积累大量知识资源。GPT-Crawler的出现,极大地简化了知识库的构建过程,使得用户能够更高效地获取和管理知识。

写在最前面

随着互联网的快速发展,网络信息量呈爆炸式增长,如何有效地从这些海量信息中提取有价值的知识,成为技术人员面临的一大挑战,GPT-Crawler作为一款强大的爬虫工具,能够帮助开发者和数据科学家高效地构建和维护GPTs的知识库,本文将详细介绍如何利用GPT-Crawler来爬取网站数据,并结合OpenAI技术,实现自定义assistant和GPTs。

准备工作

1、安装node.js

确保你的计算机上安装了Node.js,你可以从官方网站下载并安装最新版本的Node.js,安装完成后,在命令行输入node -v,如果能够显示版本信息,则表示安装成功。

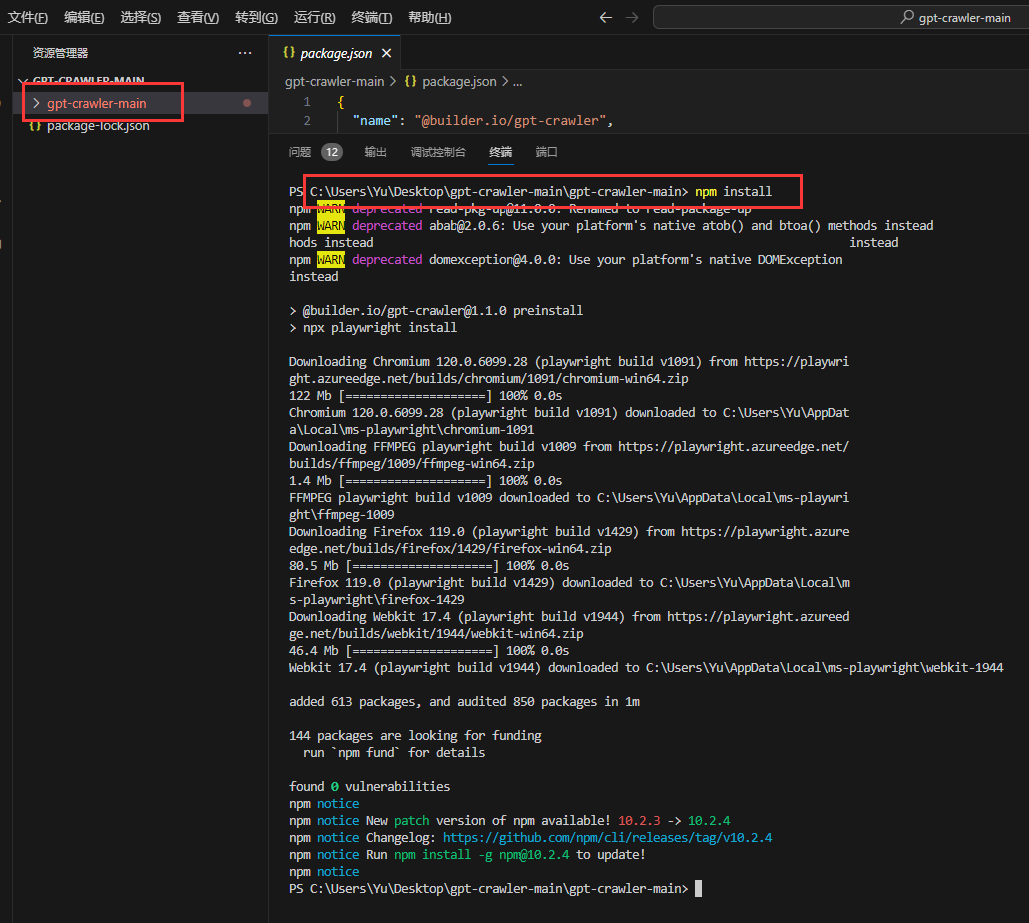

2、安装GPT-Crawler

GPT-Crawler项目能够从网站上爬取数据,并生成用于创建GPTs的知识库文件,你可以从GitHub上下载该项目,并使用VSCode等编码工具打开,切换到项目目录后,执行npm install命令,安装项目依赖包。

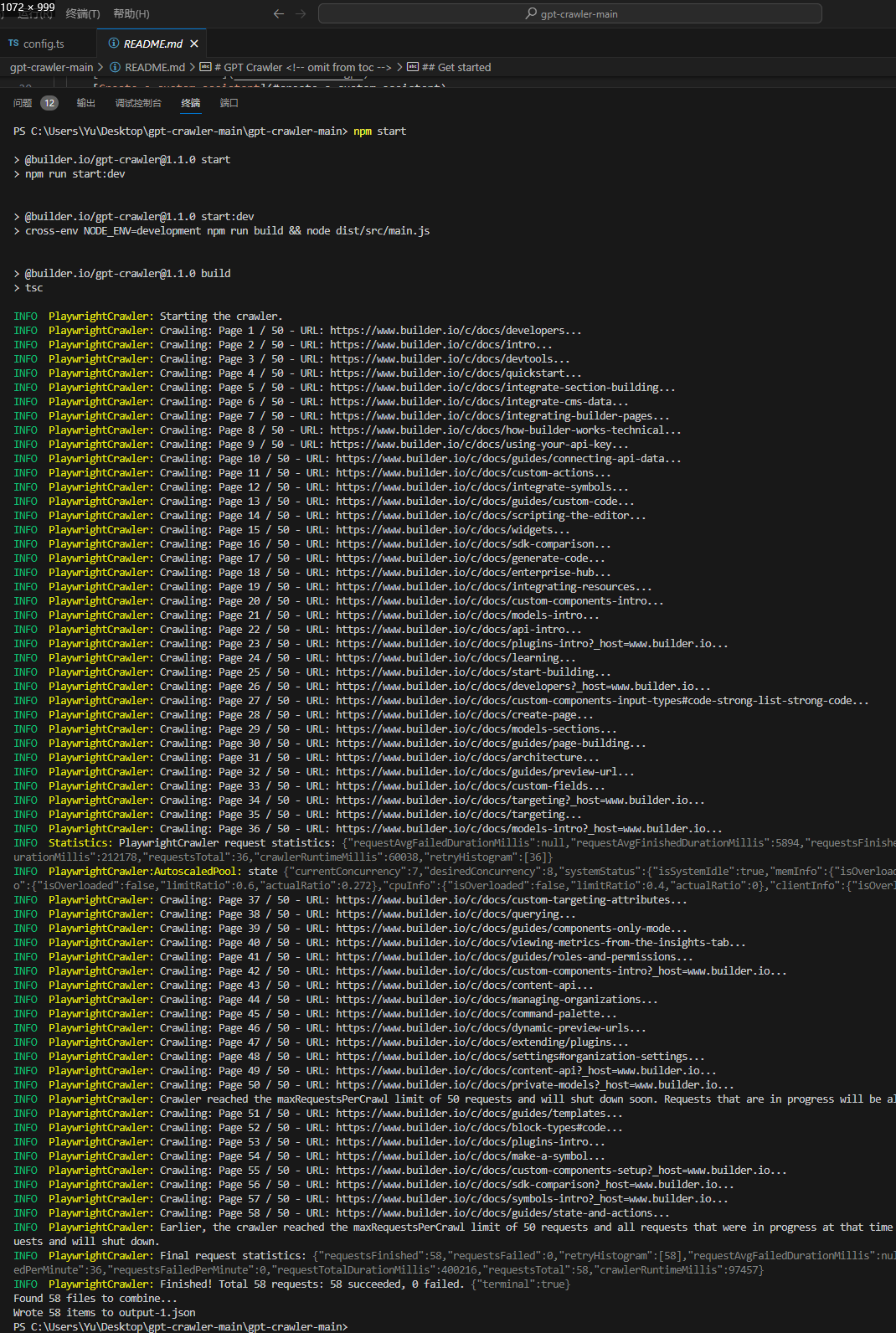

启动爬虫

在项目目录下执行npm start命令,启动爬虫程序,程序会在项目根目录输出一个名为output.json的文件,这就是我们需要的文件。

结合OpenAI

这一步需要一个OpenAI账户,将生成的output.json文件上传到OpenAI平台,你可以通过自定义Assistants页面创建一个Assistant,并添加output.json文件,配置其他选项后,保存并测试。

自定义assistant和GPTs

你可以根据自己的需求自定义assistant和GPTs,在OpenAI平台上,选择自定义Assistants页面,创建一个Assistant,并上传output.json文件,对于GPTs的自定义,需要付费Plus版本,并且目前官方尚未提供GPTs的API可用。

GPT-Crawler项目让我们能够轻松地构建自己的知识库,结合OpenAI的API,我们可以实现更多功能,本文详细介绍了GPT-Crawler的安装、启动过程,以及与OpenAI的结合方法,希望本文能够帮助你更好地利用GPT-Crawler构建GPTs知识库,无论你是开发者还是数据科学家,都可以通过本文获得有价值的信息和实践指导。

还没有评论,来说两句吧...