温馨提示:这篇文章已超过454天没有更新,请注意相关的内容是否还可用!

摘要:,,本实践指南介绍了如何使用LlamaIndex和Qwen1.5搭建本地知识库问答机器人。通过详细步骤和经验分享,帮助读者了解如何实践搭建过程,充分利用本地知识库实现高效问答功能。攻略涵盖了搭建流程、注意事项和经验总结,为开发者提供了宝贵的参考和指导。

本实践指南详细介绍了如何利用LlamaIndex和Qwen1.5技术搭建本地知识库问答机器人,通过分享具体的步骤和实践经验,帮助读者了解如何结合这两个工具构建高效、智能的问答机器人,实现基于本地知识库的快速问答,为用户提供便捷的服务。

随着人工智能技术的飞速发展,问答机器人在许多领域的应用越来越广泛,本文将介绍一种基于LlamaIndex和Qwen1.5技术的本地知识库问答机器人的搭建方法,以实现问答机器人的智能化,提高回答问题的准确性和效率。

什么是RAG?

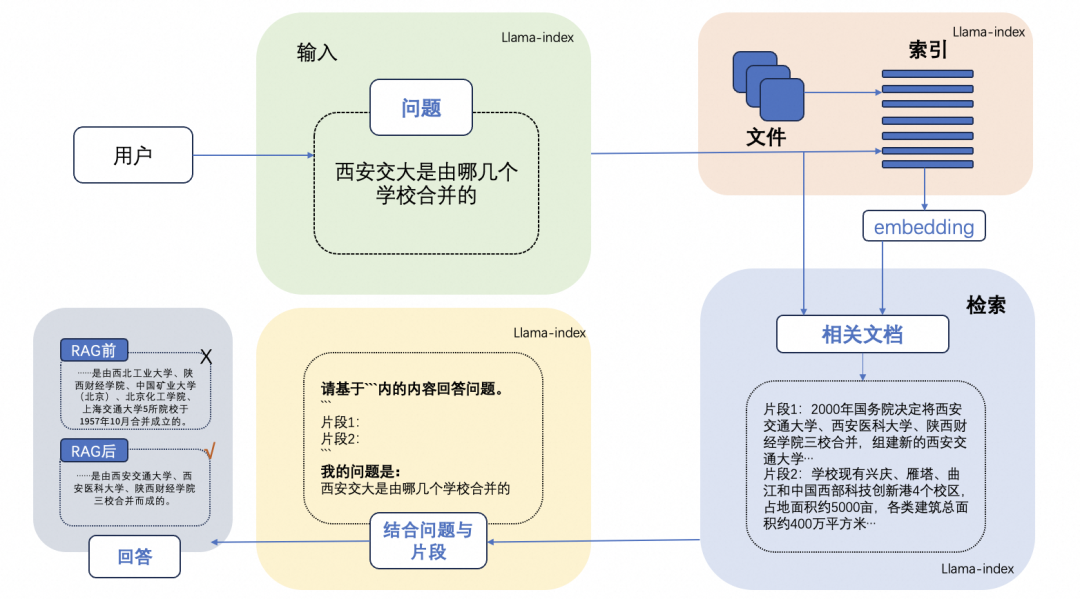

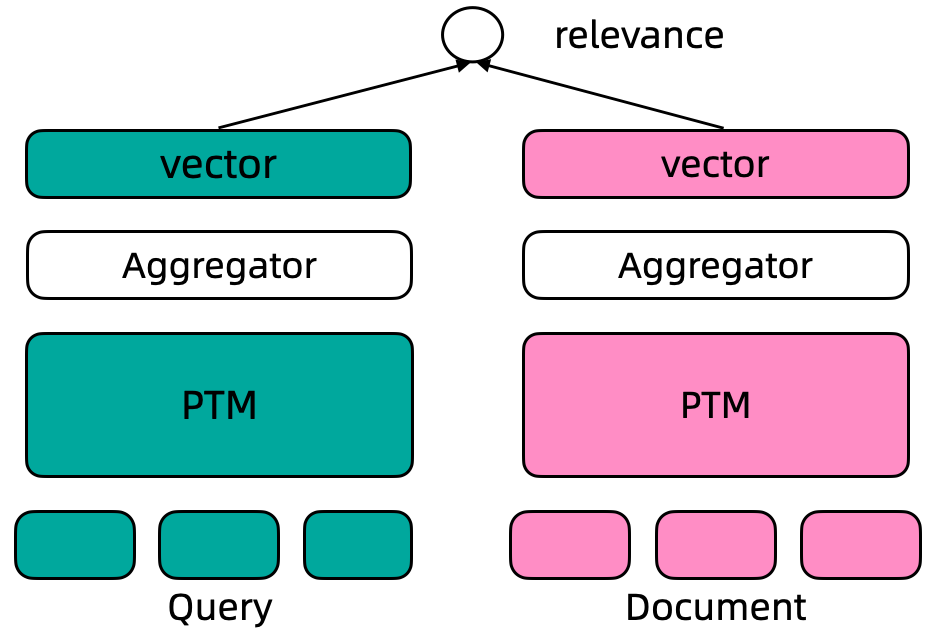

RAG,即检索增强生成(Retrieval-Augmented Generation),是AI时代的一大趋势,RAG技术在生成答案前,先从广泛的文档数据库中检索相关信息,然后利用这些信息来引导生成过程,从而提高了内容的准确性、相关性、知识更新的速度以及内容生成的可追溯性。

技术与交流

我们重视技术的分享与交流,为此已经建立了一个大模型面试和技术交流群,欢迎加入我们一起探讨,获取相关资料、进行技术交流以及答疑。

Qwen1.5版本介绍

Qwen1.5版本在年前开源了不同大小的基础和聊天模型,与之前的版本相比,Qwen1.5显著提升了聊天模型与人类偏好的一致性,并且改善了其多语言能力,所有模型提供了统一的上下文长度支持,为开发者带来更佳的体验。

LLaMaIndex介绍

LLaMaIndex是一个基于LLM的应用程序数据框架,受益于上下文增强,这种LLM系统被称为RAG系统,LLaMaIndex提供了必要的抽象,使摄取、构建和访问私有或特定领域的数据更加轻松,从而实现更准确的文本生成。

最佳实践

1、环境配置与安装:首先配置环境,安装Python、PyTorch等必要软件库,推荐使用pip进行安装依赖库的安装。

2、加载大语言模型:使用Hugging Face LLM进行模型的加载。

3、基于文档对象列表建立其索引:便于后续的检索操作。

4、利用本地知识库搭建问答引擎进行查询和问答。

本文还将通俗讲解大模型系列内容,包括面试宝典、实战宝典、大模型感悟等,以LangChain中的大模型RAG技术的实战应用为例,详细讲解如何提升大模型Agent的能力、部署大模型、使用LangChain封装自定义LLM等,我们还将提供部署本地知识库问答系统的详细教程以及大模型基础环境安装的指导,帮助大家更好地理解大模型和RAG技术。

通过基于LlamaIndex和Qwen1.5搭建的本地知识库问答机器人,将实现问答机器人的智能化,提高其回答问题的准确性和效率,为用户提供更便捷、高效的服务体验,我们将持续更新更多相关技术和实战内容,以满足广大开发者和用户的需求。

还没有评论,来说两句吧...