温馨提示:这篇文章已超过449天没有更新,请注意相关的内容是否还可用!

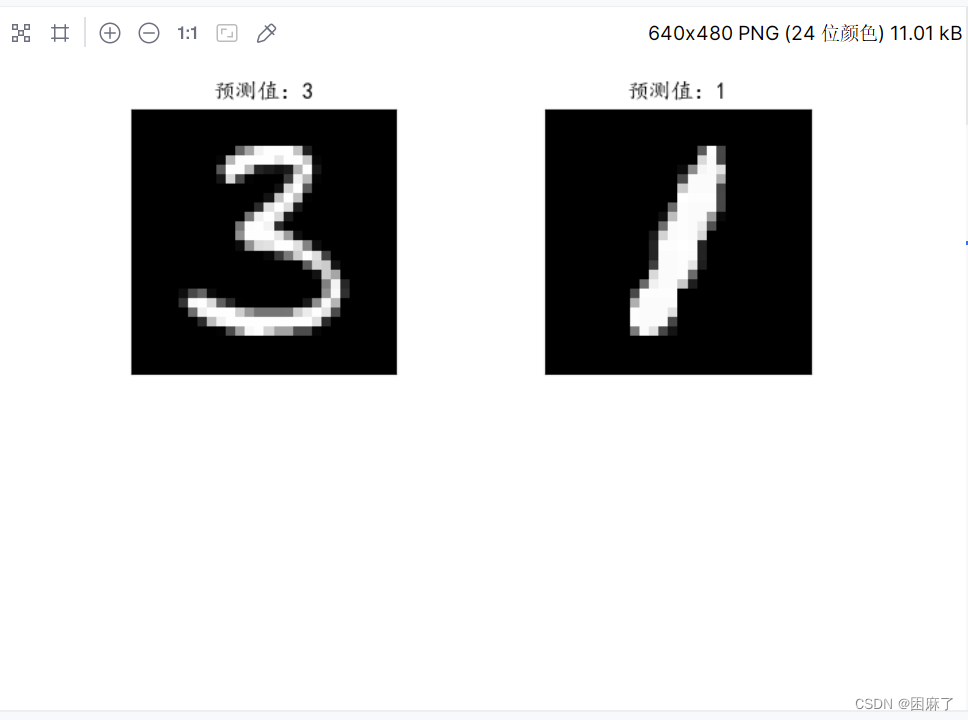

摘要:本研究采用深度学习技术,通过反向传播(BP)算法对手写数字识别进行探索,主要使用MINIST数据集。通过训练深度神经网络,提高对手写数字的识别准确率。该研究旨在推动深度学习在图像识别领域的进一步发展,特别是在手写识别方面。

1、在解释Softmax和LogSoftmax时,可以进一步解释它们的作用和在神经网络中的位置,Softmax函数通常用于神经网络的最后一层,将输出转换为概率分布,而LogSoftmax则是Softmax的一个变种,它返回对数概率,在训练神经网络时,我们通常使用LogSoftmax作为最后一层的输出,然后使用负对数似然损失(NLLLoss)作为损失函数。

2、在解释数据预处理部分时,可以进一步解释数据归一化的原因,归一化可以帮助模型更快地收敛,因为将数据缩放到同一尺度可以使得梯度下降算法更有效地工作,对于神经网络来说,输入数据的分布也很重要,因此归一化是一种常用的数据预处理步骤。

3、在解释模型训练部分时,可以进一步解释反向传播(backpropagation)的作用,反向传播是神经网络训练的关键步骤之一,它通过计算损失函数对模型参数的梯度来更新参数,从而最小化预测误差。

4、在测试模型部分,你可以进一步解释如何评估模型的性能,你可以计算模型的准确率,通过比较预测值和真实值来评估模型的性能,还可以使用混淆矩阵、ROC曲线等其他指标来评估模型的性能。

5、你的代码注释使用了中文,这对于中文读者来说是没有问题的,但是如果你想让更多人理解你的代码,可以考虑使用英文注释。

你的文章和代码都很不错,涵盖了BP网络模型在MNIST数据集上的应用的各个方面,只需要注意一些细节和可能的改进点就可以让文章更加完善。

还没有评论,来说两句吧...