温馨提示:这篇文章已超过445天没有更新,请注意相关的内容是否还可用!

摘要:Densenet是一种深度卷积神经网络结构,具有密集连接的特点,能够显著提高特征提取的效率。而SE(Squeeze-and-Excitation)模块则是一种有效的注意力机制,能够增强网络对重要特征的感知能力。结合Densenet和SE模块,可以进一步提高网络性能,特别是在图像分类等任务中表现优异。这种结合方法旨在通过增强特征表达和注意力机制,提升网络模型的准确性和性能。

SE注意力机制简介

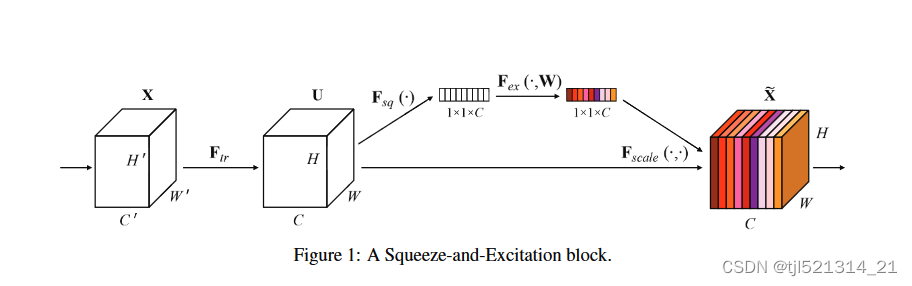

SE注意力机制是一种用于增强卷积神经网络(CNN)性能的注意力机制,特别适用于图像分类任务,该机制由Jie Hu等人于2018年提出,旨在通过动态调整特征图中每个通道的权重,从而增强模型对重要特征的感知能力。

SE注意力机制的基本思想是利用全局信息来动态调整特征图中各个通道的重要性,该机制包括两个关键步骤:Squeeze(压缩)和Excitation(激励)。

Squeeze(压缩):

在Squeeze阶段,通过全局池化操作(通常是全局平均池化)来压缩特征图在空间维度上的信息,假设输入特征图的尺寸为H×W×C,其中H和W分别是特征图的高度和宽度,C是通道数,通过全局平均池化操作,将每个通道的特征图转换为长度为C的向量,表示每个通道的全局重要性。

Excitation(激励):

在Excitation阶段,利用一个小型的全连接网络(或者称为多层感知机)来学习每个通道的激励权重,将Squeeze阶段得到的长度为C的向量输入到一个两层的全连接网络中,通过激活函数(如ReLU)和sigmoid函数,输出每个通道的激励权重(或者称为通道注意力权重),这些权重用于对原始特征图进行加权,从而增强对重要特征的感知能力。

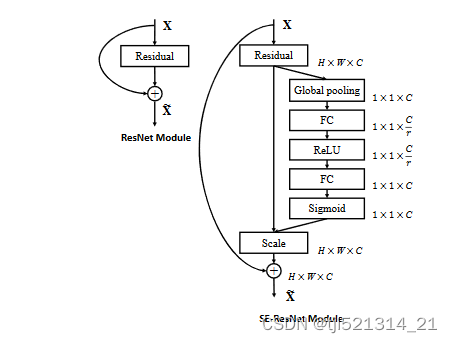

神经网络插入注意力机制

以Resnet为例,可以通过在残差模块中加入SE注意力机制,提升模型的性能。

SE插入Densenet

在Densenet中加入SE注意力机制,需要对DenseNet的架构进行修改,可以在每个Dense Block中加入SE Block,SE Block的实现方式如下:

class SE_Block(nn.Module):

def __init__(self, ch_in, reduction=16):

super(SE_Block, self).__init__()

self.avg_pool = nn.AdaptiveAvgPool2d(1) # 全局自适应池化

self.fc = nn.Sequential(

nn.Linear(ch_in, ch_in // reduction, bias=False), # 降维

nn.ReLU(inplace=True), # ReLU激活函数

nn.Linear(ch_in // reduction, ch_in, bias=False), # 升维

nn.Sigmoid() # 输出通道注意力权重

)

def forward(self, x):

b, c, _, _ = x.size() # 获取输入张量的维度信息

y = self.avg_pool(x).view(b, c) # Squeeze操作:将空间维度压缩成一个通道描述符

y = self.fc(y).view(b, c, 1, 1) # 获取通道注意力权重,是具有全局信息的

return x * y.expand_as(x) # 将注意力权重应用到输入张量的每个通道上可以在Dense Layer中加入SE Block,实现Densenet与SE注意力机制的结合,具体的实现方式可以参考下面的代码片段:

(此处省略了完整的代码实现,具体实现方式需要根据实际需求进行调整和优化。)需要注意的是,加入SE Block会增加模型的参数数量和计算复杂度,需要根据实际情况进行权衡和选择,还需要通过实验来验证模型的效果和性能。

还没有评论,来说两句吧...