温馨提示:这篇文章已超过445天没有更新,请注意相关的内容是否还可用!

摘要:本文介绍了Py深度学习中的Batch Normalization技术。Batch Normalization是一种用于加速神经网络训练的技术,通过对每个batch的数据进行归一化处理,使得网络的训练更加稳定。通过减少内部协变量移位,BN能够帮助模型更好地学习数据的内在规律。BN还可以作为正则化手段,提高模型的泛化能力。在深度学习中,掌握Batch Normalization技术对于提升模型的性能至关重要。

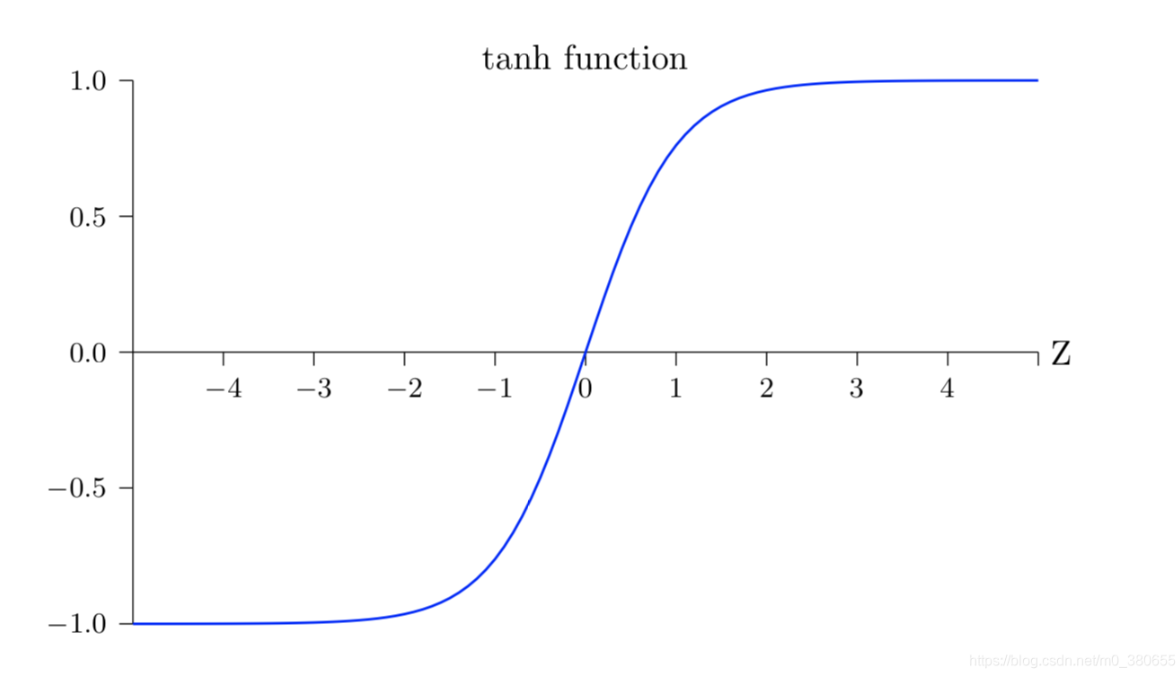

我们在输入层进行数据的标准化处理,以让模型学习更好的特征,在神经网络的中间层,数据分布的变化会对训练产生影响,以tanh激活函数为例,当输入值过大时,其输出值接近饱和状态,此时再增大输入,输出几乎没有任何变化,可以理解为模型对数据变得不再敏感,这种情况在隐藏层中时有发生,可能导致训练困难,Batch Normalization(BN)层就是为了解决这一问题而出现的。

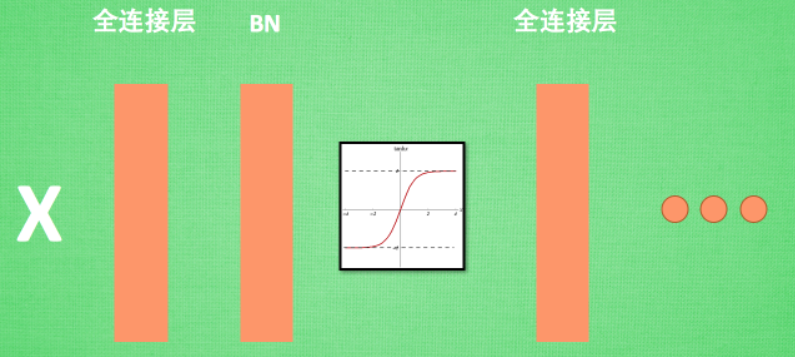

2. Batch Normalization层位置

Batch Normalization(BN)层被添加在每个全连接层和激活函数之间,这样做可以有效地对每一层的输入进行标准化,加速训练过程并提升模型的性能。

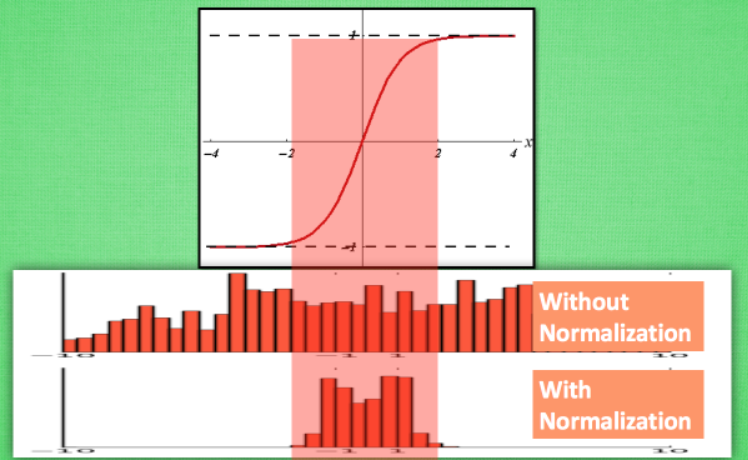

3. Batch Normalization作用的形象理解

对于激活函数如tanh,其效果最好的是当输入值分布在一个特定的区间内,通过Batch Normalization,我们可以将数据分布在这个区间内,从而更有效地利用tanh进行非线性化处理,如果没有进行normalization,数据分布可能大部分处于激活函数的饱和阶段,导致激活值大部分为-1或1,而经过normalization后,数据分布更加均匀,每个区间都有数据存在,这样更有利于神经网络的计算。

BN算法

Batch Normalization的公式包括标准化过程,以及随后的扩展和平移操作,标准化是为了将数据分布调整到更利于神经网络学习的状态,而扩展和平移操作则是为了让神经网络自行学习和调整这两个参数(gamma和beta),以判断normalization操作是否起到了优化作用,如果效果不理想,神经网络可以通过调整这两个参数来部分抵消normalization的影响。

Batch Normalization通过标准化中间层的输出,改善了数据的分布,使得神经网络训练更加稳定,同时也提升了模型的性能,这在深度学习中是一个非常重要的技术。

注:以上内容参考了https://zhuanlan.zhihu.com/p/24810318,并进行了适当的修改和补充,以使其更加清晰和完整。

还没有评论,来说两句吧...