温馨提示:这篇文章已超过451天没有更新,请注意相关的内容是否还可用!

摘要:本文介绍了Spark机器学习中的特征工程之特征提取技术。特征提取是机器学习的重要步骤,能够从原始数据中提取出有用的信息,提高模型的性能。在Spark环境下,利用其二阶库Spark MLlib,可以方便地进行特征提取操作。本文详细阐述了特征提取的方法和技巧,为机器学习和数据分析人员提供了有价值的参考。

本文介绍了Spark机器学习中的特征提取部分,特征提取是机器学习的重要环节,能够从原始数据中提取有用的信息,为模型训练提供更高质量的数据,在Spark环境下,利用分布式计算的能力,可以高效地处理大规模数据集并进行特征提取,本文将详细阐述特征提取的方法和技巧,包括文本、图像等数据的特征提取方式,为机器学习模型的性能提升打下基础。

特征提取

什么是特征提取?

特征提取(Feature Extraction)是机器学习和模式识别中的一个重要步骤,旨在从原始数据中提取出有意义的、对解决问题有帮助的信息,即特征,这些特征通常是对原始数据的简化表示,能够捕捉数据的关键属性,同时减少数据的复杂性和冗余性。

特征提取的主要目的是:

2、避免过拟合:避免提取过多的特征,以免导致模型过拟合,通常需要通过交叉验证等技术来评估特征提取的效果。

3、考虑计算效率:特征提取的过程应尽可能高效,避免在大数据集上花费过多的计算资源。

示例代码

在本篇文章中,我会提供TF-IDF和Word2Vec两种算法的简单示例。

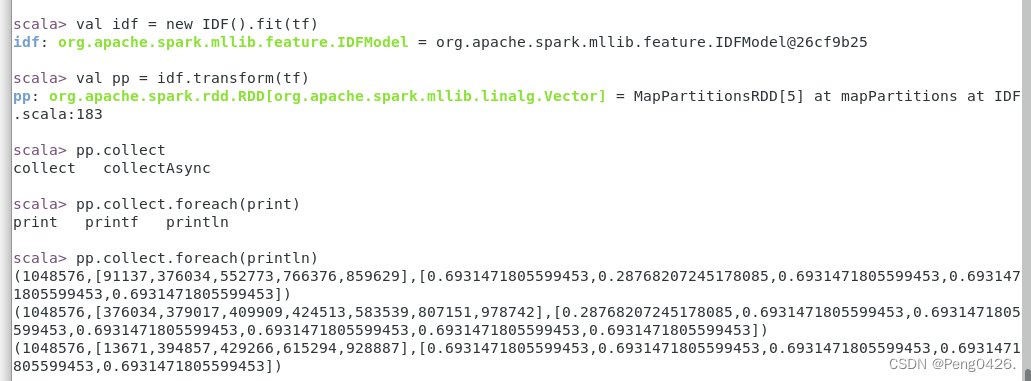

(一)TF-IDF实现文档向量化(词频-逆文档频率计算)

什么是TF-IDF?TF-IDF是用一个一层的神经网络(即CBOW)将one-hot形式的稀疏词向量映射为一个n维(n一般为几百)的稠密向量的过程,这种n维的稠密向量即为word2vec中的K维度稠密向量,相较于传统NLP的高维、稀疏的表示法(One-hot Representation),Word2Vec训练出的词向量是低维、稠密的,其语义信息更加丰富,这种表示方法使得意思相近的词在向量空间中会被映射到相近的位置。

代码实现:这里我们有一个名为tf-idf.txt的文本文档,我们需要将它从指定地址提取文档文件并进行我们的文档向量化。

(二)Word2Vec(创建K维度的稠密向量)

Word2Vec是一种用于生成词向量的深度学习模型,通过训练神经网络来学习词汇表中每个单词的分布式表示,这些向量能够捕捉单词之间的语义和语法关系,使得语义上相近的单词在向量空间中的位置也相近。

代码实现:假设你的文本数据在"/opt/spark-3.2.1/P/word2vec.txt"文件中,通过Word2Vec模型进行训练,可以查找特定词的向量。

拓展-特征提取的各种方法及优点

以下是几种常见的特征提取方法及它们的优点:

1、TF-IDF:能够综合考虑词在文档中的出现频率和在整个语料库中的稀有性,适用于文本分类、信息检索等任务,能够有效地提取出文本中的关键信息。

2、主成分分析(PCA):可以降低数据维度,去除噪声和冗余特征,提高模型性能,易于理解和可视化。

3、线性判别分析(LDA):能够找到最具区分性的特征,提高分类性能,对数据的分布有一定的鲁棒性。

4、SIFT(尺度不变特征变换):对尺度、旋转和光照变化具有不变性,适用于复杂场景和大量数据的处理,提取的特征具有较高的鲁棒性和独特性。

5、Word2Vec:捕捉单词的语义和上下文信息,提高文本处理任务的性能,适用于各种自然语言处理任务。

本文详细介绍了Spark机器学习中的特征提取方法,包括文本、图像等数据的特征提取方式,通过特征提取,可以从原始数据中提取出有意义的特征,为机器学习模型提供更高质量的数据,从而提高模型的性能和可解释性,在实际应用中,根据数据的类型和问题的性质选择合适的特征提取方法是非常重要的。

还没有评论,来说两句吧...