温馨提示:这篇文章已超过437天没有更新,请注意相关的内容是否还可用!

摘要:本文介绍了一种针对动态场景中任意形状针的单目3D位姿估计方法。该方法结合了高效的视觉学习和几何建模技术,旨在实现精确的位姿估计。通过采用先进的视觉算法,能够在动态场景中有效识别并跟踪针的形状,进而实现其三维位置的精确估算。该方法具有广泛的应用前景,可应用于机器人导航、增强现实等领域。

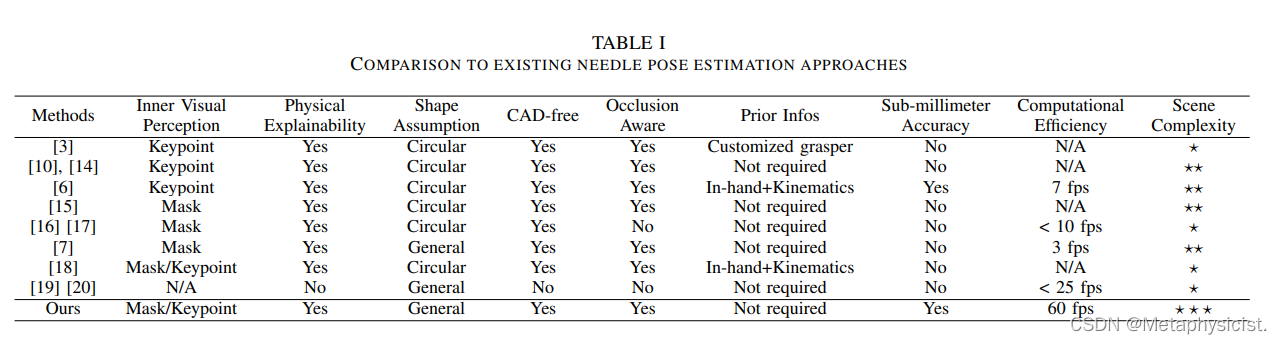

这篇论文报告了一种创新的系统框架,用于在具有挑战性的手术场景中实现针具姿态的实时精确估计,通过引入定制的视觉学习网络和新颖的几何模型,该框架不仅能够在动态且多变的手术环境中捕获针具的精细特征,而且能够在存在遮挡的情况下实现亚毫米级别的精度,与传统的依赖先验信息的方法不同,该框架具有通用性,可以广泛估计其他小型平面轴对称物体的姿态,它在体内实验和模拟模型中的验证证明了其在实际手术应用中的潜力。

1、问题阐述:

手术场景中针具姿态估计面临的主要挑战在于如何在动态、复杂的环境中实现高精度的估计,这不仅需要强大的视觉感知模型来提取准确的特征,还需要高效的姿态求解器来在缝合过程中提供精确指导,算法应对噪声不敏感,以保持姿态估计的鲁棒性,考虑到不同手术中针具的多样性,算法应具备通用性,以适应不同形状的针具。

2、方法描述:

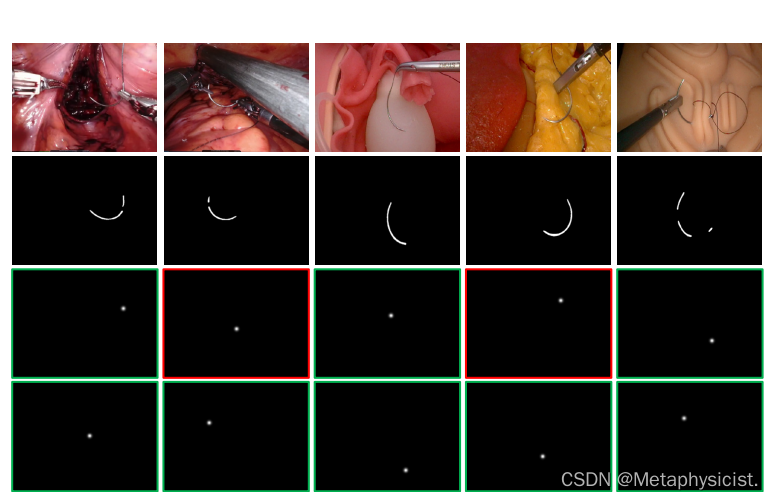

论文提出了一种结合视觉学习与几何建模的系统框架,通过引入多尺度掩码轮廓融合机制,精确捕获针具的特征,建立了一个新的姿态表示状态空间,并开发了一种基于稀疏点描述符和几何模型的物理投影模型来推导姿态,为了处理遮挡问题,论文制定了一个抗遮挡目标函数,使用非线性优化器进行姿态估计,实现了高效且准确的姿态估计,整个框架在自收集的活体临床数据集和模拟数据集上进行了验证,并在达芬奇研究套件上进行了机器人手术模拟评估。

3、实验部分补充:

实验结果表明,与传统的姿态估计方法相比,该框架在检测、分割和姿态估计方面均取得了显著的优势,具体而言,它在各种遮挡场景、反射和其他具有挑战性的条件下均表现出鲁棒性,对20个案例数据集的定量评估显示,中位位置误差仅为1.42毫米,中位方向误差为2.16度,最重要的是,该框架已成功部署在真实的机器人手术平台上,证明了其在自动针操作任务中的实用性。

这篇论文提出了一种高效且精确的针具姿态估计方法,为机器人手术中的自动针操作奠定了坚实的基础,通过结合视觉学习与几何建模,该框架能够在动态且复杂的手术场景中实现亚毫米级别的姿态估计,它在广泛的实验验证中表现出了卓越的性能和鲁棒性,证明了其在真实机器人手术部署中的潜力,这项工作不仅为机器人手术中的针具操作自动化提供了重要的技术支持,还为其他小型物体的姿态估计提供了有益的参考。

参考文献

论文引用了相关的研究工作作为背景和基础,这些参考文献对于理解论文的方法和结果非常重要,在引用时,要确保准确无误地标注每个参考文献的作者、标题、出版年份和出版社等信息。

还没有评论,来说两句吧...