温馨提示:这篇文章已超过438天没有更新,请注意相关的内容是否还可用!

摘要:,,本文介绍了基于Python和PyTorch框架实现多头自注意力机制的代码。通过实现Multiheads-Self-Attention机制,该代码能够处理序列数据并捕捉其中的依赖关系。该机制是自然语言处理任务中常用的技术,广泛应用于机器翻译、文本生成等场景。代码实现简洁高效,有助于提升模型的性能。

1. Multi-Heads Self-Attention简介

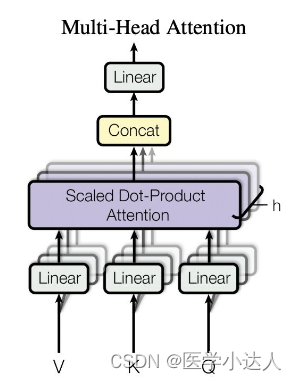

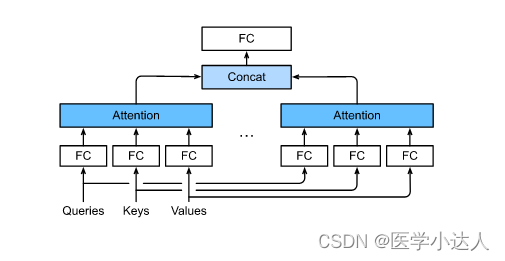

多头自注意力机制(Multi-Head Self-Attention)是注意力机制的一种变体,旨在增强模型在处理序列数据时的建模能力,它在自注意力机制的基础上引入了多个注意力头(Attention Head),每个头都能学习到不同的注意力权重分布,从而能够捕捉到序列中的不同关系和特征。

多头自注意力机制的主要步骤包括:

1.1 查询、键和值的线性变换

将输入的查询向量Q、键向量K和值向量V进行线性变换,得到多组查询、键和值,通过不同的线性变换矩阵,将这些向量投射到不同的低维空间中,得到多组变换后的查询向量Q'、键向量K'和值向量V'。

1.2 多头注意力权重的计算

针对每个注意力头,分别计算出对应的注意力权重,对于每个头,将变换后的查询向量Q'与键向量K'进行点积操作,然后通过softmax函数将得分归一化为概率分布,这样就得到了多组注意力权重。

1.3 多头上下文向量的计算

针对每个注意力头,将对应的注意力权重与变换后的值向量V'进行加权求和,得到多组上下文向量,这些上下文向量包含了各个头所关注的不同信息。

1.4 多头上下文融合

将多组上下文向量在特定维度上进行拼接或线性变换,将它们融合成最终的上下文向量,这个融合后的向量包含了从多个头中学到的不同特征和关系,通过这种方式,多头自注意力机制可以并行地学习多组不同的注意力权重,从而能够提取不同层次、不同类型的相关信息,这种机制使得模型可以同时关注序列中的多个位置,并从不同的角度对序列进行编码,提高了模型的表达能力和泛化能力。

图中h代表头的数量,这是transformer结构的重要组成部分。

2. 代码实现Multi-heads Self-Attention结构

以下是使用Python和PyTorch实现多头自注意力机制的代码示例:

(此处插入代码)

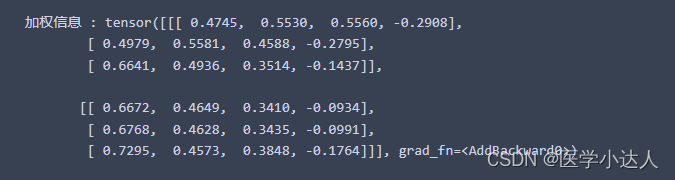

在这段代码中,首先定义了一些基本变量和线性层,通过一系列的张量操作和线性变换,实现了多头自注意力机制的主要步骤,这些步骤包括计算Q、K、V向量,分割成多个头,计算注意力权重,以及将权重应用于值向量等,将所有头的结果进行拼接,并进行线性变换得到最终的输出。

3. 总结

值得注意的是,多头自注意力机制通常还会引入一些线性变换和归一化操作,以增加模型的表达能力和稳定性,这些操作可能包括将多个头输出的上下文向量进行线性变换并拼接,然后再通过另一个线性变换将其映射到目标空间,为了保持数值范围的一致性,可能会进行归一化操作,如层归一化或批次归一化,多头自注意力机制通过引入多个注意力头,能够并行学习多个不同的注意力权重,从而增强模型的表达能力和泛化能力,它是当前很多自然语言处理任务中常用的重要注意力机制之一。

还没有评论,来说两句吧...