温馨提示:这篇文章已超过437天没有更新,请注意相关的内容是否还可用!

摘要:,,本实践指南介绍了在Linux平台上利用Ollama和Open WebUI部署大模型的步骤和流程。通过结合Ollama和Open WebUI的技术优势,提供了一种高效、灵活的部署方案。本指南旨在帮助开发者在Linux平台上成功部署大模型,实现更好的模型应用效果。

随着人工智能的飞速发展,大模型的部署成为了一项重要任务,在Linux平台上,Ollama和Open WebUI的结合为这一任务提供了强大的支持,Ollama以其强大的计算能力和高效的资源管理,为大规模模型的运行提供了坚实的基础,而Open WebUI则为用户提供了一个直观的操作界面,便于模型的部署、监控和管理,二者的结合实现了Linux平台上的大模型高效运行,极大地促进了人工智能在各个领域的应用和发展。

在人工智能领域,部署大型深度学习模型一直是一个挑战,对于不熟悉复杂技术栈的用户来说,这个过程可能显得尤为困难,随着开源技术的不断发展,出现了一些强大的工具,如Ollama和Open WebUI,使得部署大型模型变得更加简单和高效。

本文将详细介绍如何利用Ollama和Open WebUI在Linux平台上部署大型深度学习模型,通过简单的步骤,用户可以轻松搭建起一个高效的模型部署环境。

Ollama安装

Ollama是一个专门用于部署深度学习模型的强大平台,其安装步骤如下:

1、安装Docker:确保您的Linux系统已经安装了Docker,您可以按照Docker官方文档提供的指南进行安装。

2、拉取Ollama镜像。

3、运行Ollama容器,并将其与宿主机的端口进行映射。

4、打开浏览器,访问Ollama的Web界面,开始构建、训练和部署深度学习模型。

Open WebUI安装

Open WebUI是一个开源的Web用户界面工具,为用户提供了友好的界面来与Ollama平台进行交互,其安装步骤如下:

1、拉取Open WebUI镜像。

2、运行Open WebUI容器。

3、打开浏览器,访问Open WebUI的用户界面,与Ollama平台交互,方便地管理模型和监控训练过程。

配置及使用

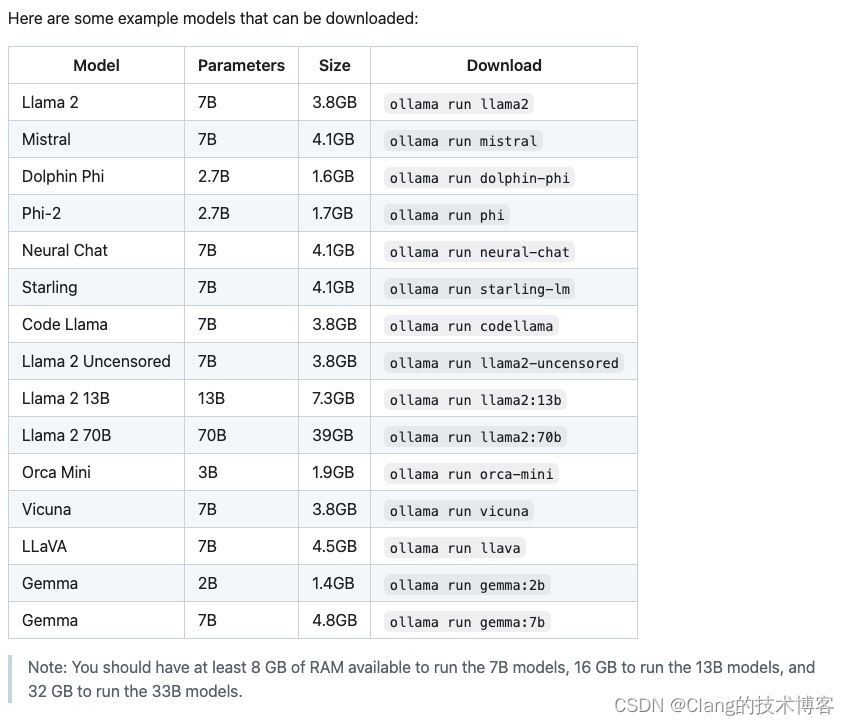

1、下载模型:在Open WebUI页面中设置模型下载,选择需要下载的模型并进行下载。

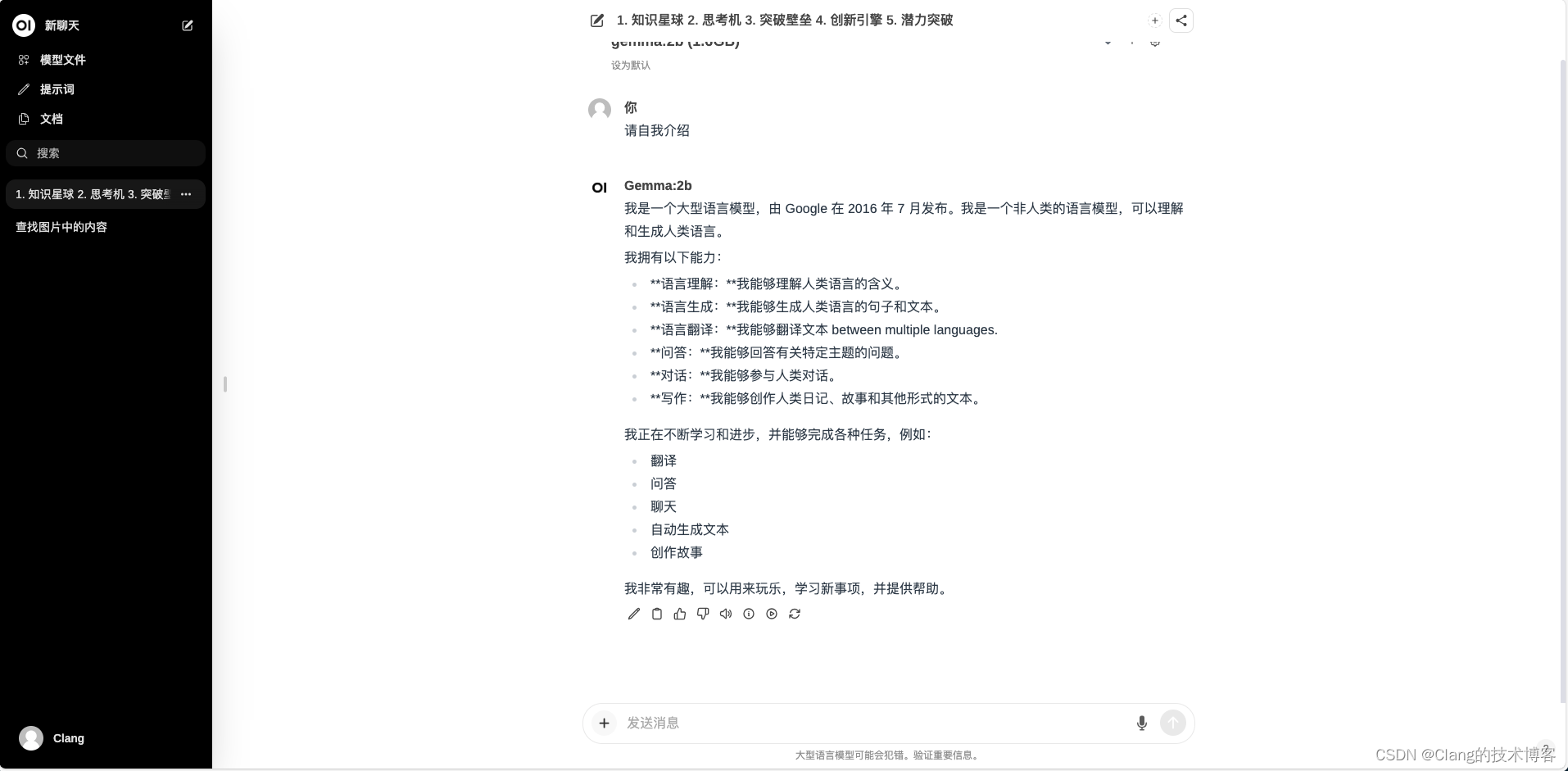

2、使用模型:选择希望使用的模型,即可通过直观的界面开始使用。

本文还介绍了如何配置和使用这些工具,包括如何下载和使用模型等详细内容,通过简单的步骤,用户可以快速部署和使用这些工具,加速深度学习模型的开发和部署过程。

Ollama和Open WebUI的结合为在Linux平台上部署大模型提供了强大的支持,通过简单的安装和配置步骤,用户可以轻松搭建起一个高效的模型部署环境,促进人工智能在各个领域的应用和发展,更多详细信息和教程,可以访问Clang的博客以获取更多指导。

还没有评论,来说两句吧...