温馨提示:这篇文章已超过446天没有更新,请注意相关的内容是否还可用!

摘要:早停法是一种防止机器学习模型过拟合的有效策略。该方法通过监视模型的验证误差,在模型性能开始下降时停止训练,避免过度复杂化模型。早停法能够节省计算资源,提高模型泛化能力。实施时需注意选择合适的验证数据集,并设定合理的早停条件和时机,以确保模型性能最优化。

早停法是一种常用的深度学习模型训练策略,其核心原理是在模型性能开始下降之前停止训练,以提高模型的泛化能力并避免过拟合,通过监测验证集上的表现,早停法能够在模型尚未过度拟合训练数据时及时停止训练,从而节约计算资源,避免不必要的计算资源消耗,有效节省训练时间。

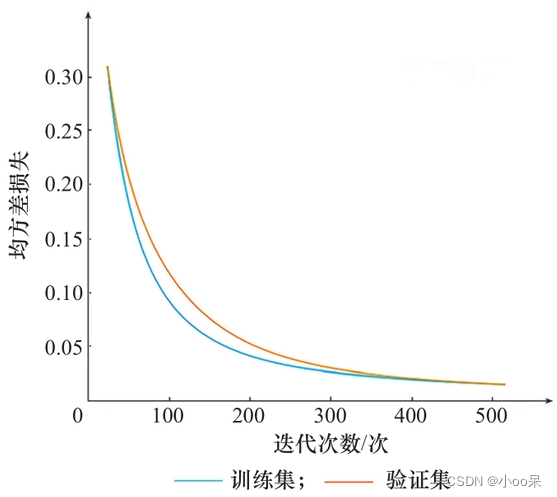

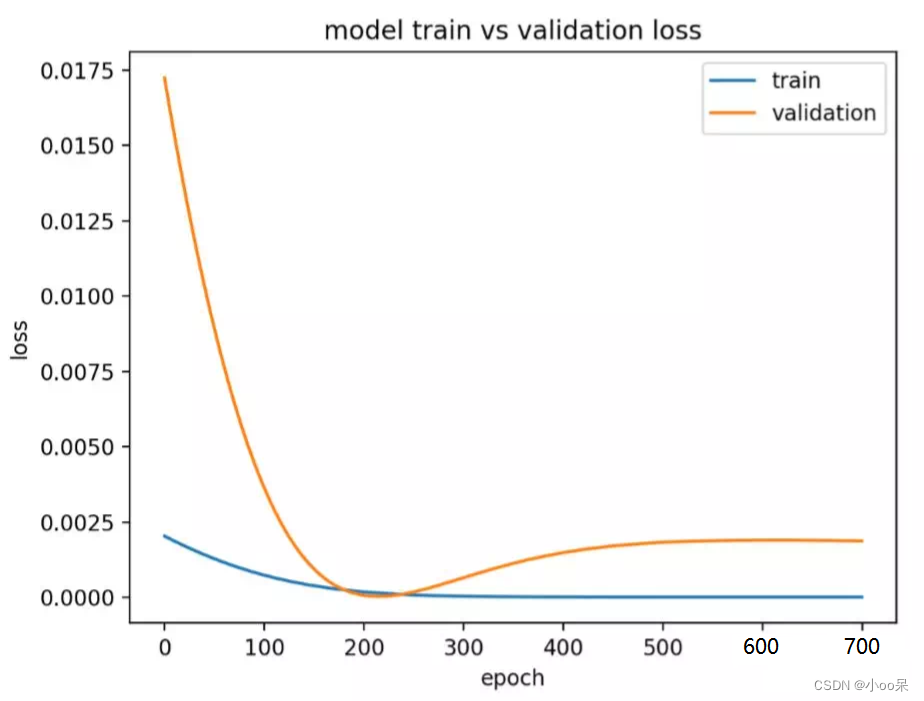

为了更好地理解早停法,我们可以观察损失函数随迭代轮次变化的图像,在训练过程中,我们通常会关注验证集上的损失函数,它反映了模型在未见数据上的表现,一个理想的模型损失函数图像应该呈现出收敛的状态,在实际应用中,如果验证集上的损失函数值在迭代轮次到达某个点后反而开始上升,就表示模型可能已经出现了过拟合现象,这时,早停法就显得尤为重要。

早停法的具体实现细节包括设置触发早停的条件、设置耐心参数以及恢复学习,常见的触发条件包括最优值法和阈值法,最优值法关注连续若干次迭代中验证集损失是否达到新的最低值,而阈值法则是当验证集损失相对于其最小值的增大幅度超过预设阈值时停止训练,为了判断损失函数是否不再下降,需要设置一个“耐心”参数,当连续未见改善的epoch数达到耐心值时,早停生效,为了尝试恢复模型的学习能力,可以设置一个“冷却期”参数,在连续未见改善的epoch数达到耐心的一部分时,暂时降低学习率,然后再根据情况决定是否继续早停。

早停法的优点包括节约计算资源、防止过拟合以及自动停止训练,早停法也存在一些缺点,如依赖验证集的质量、可能导致欠拟合以及对噪声敏感,为了提高早停法的鲁棒性,可以采取一些策略,如结合使用多种验证指标、动态调整早停条件等。

在实际应用中,早停法的实施需要结合具体任务和数据特点,灵活调整早停法的参数和策略,选择合适的早停策略能够显著提高模型训练的效率和效果,对于深度学习从业者来说,掌握和理解早停法的原理和实施细节是非常重要的。

还没有评论,来说两句吧...