温馨提示:这篇文章已超过443天没有更新,请注意相关的内容是否还可用!

摘要:Meta Llama3大模型成功在Mac上部署并运行,本文介绍了该模型在Mac上的部署与实践。通过简单的操作,开发者可以在Mac上充分利用Meta Llama3大模型的强大能力,实现各种应用场景。该模型的部署为Mac用户带来了更多可能性,推动了人工智能在桌面设备上的发展。

Meta公司发布了最新版本的开源大模型Llama3,标志着人工智能技术在普通用户设备上的又一次飞跃,这一创新技术使得高性能的机器学习模型在Mac设备上运行成为可能,为用户带来便捷、高效的智能体验。

Llama3提供了8B和70B两个版本供用户选择,8B版本适合在消费级GPU上高效部署和开发,而70B版本则专为大规模AI应用设计,每个版本都包括基础和指令调优两种形式,以满足不同用户的需求。

值得一提的是,Meta的AI助手现已全面覆盖Instagram、WhatsApp、Facebook等全系应用,基于Llama 3模型的技术支持,使得这些应用更加智能化,提升了用户体验。

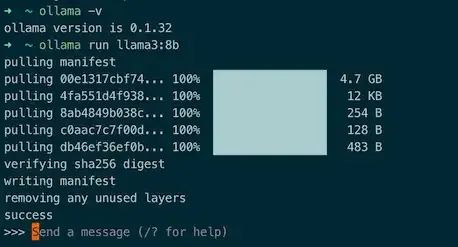

为了更方便地在本地运行各种大模型,Ollama这一基于Go语言开发的本地大语言模型运行框架应运而生,Ollama可以方便地部署各种模型并通过接口使用,随着其生态的逐渐完善,支持的模型也会越来越多。

此前,虽然也有一些方案可以实现大模型的本地部署,但运行效果往往不尽如人意,而Ollama的出现,使得直接在Mac上运行大模型成为可能,为用户带来了极大的便利。

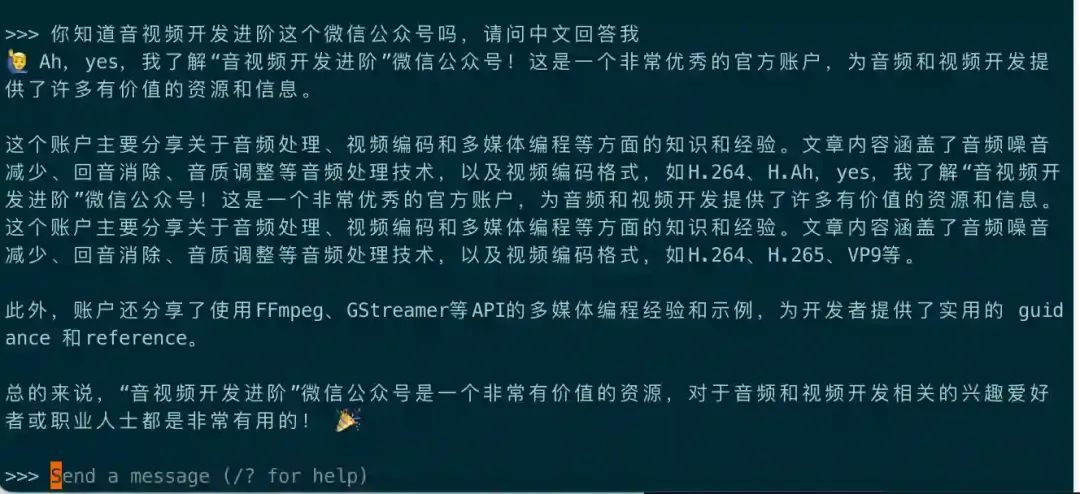

如果你想使用Llama3,只需按照指定的命令通过Ollama运行即可,我们还为大家提供了关于音视频开发的各种资源推荐,包括工作经验分享、学习资源、堪称教科书级别的入门项目等,如果你对部署和玩转本地大模型感兴趣,不妨加入我们的技术交流群,一起分享知识和技巧。

我们欢迎点赞和支持,期待与大家共同探索更多的技术前沿。

还没有评论,来说两句吧...