温馨提示:这篇文章已超过446天没有更新,请注意相关的内容是否还可用!

摘要:在Mac M1笔记本上运行大语言模型llama3需要四个步骤。安装必要的软件和依赖;从仓库中拉取代码;运行模型进行初始化;通过接口向模型提问或获取答案。这些步骤简便易懂,使得在Mac M1笔记本上体验和使用llama3模型变得轻松便捷。

Ollama是一个强大的本地大语言模型LLM运行工具,支持多种模型,操作简便。

下载ollama工具后,可以通过简单的命令下载和运行模型。

提供了详细的步骤说明,包括下载ollama、下载模型文件、运行模型等。

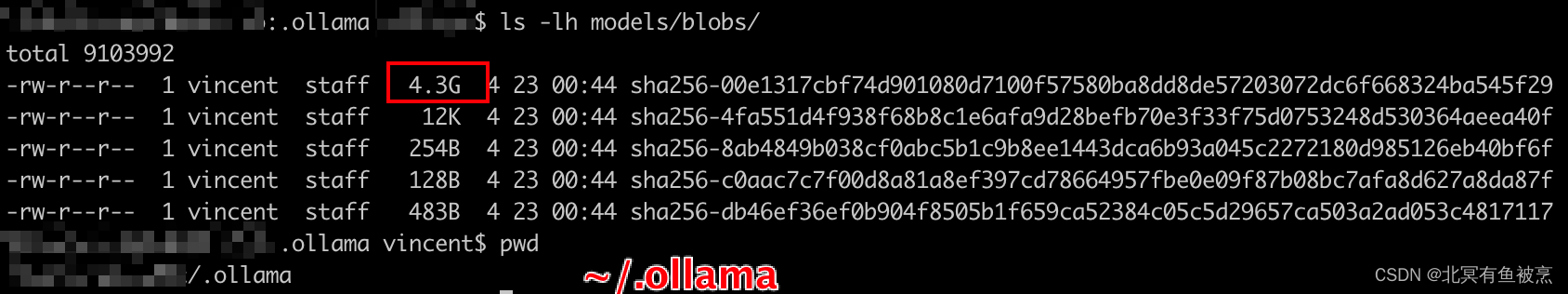

ollama的存储机制与git类似,以blobs的形式存储模型,配置信息存储在models/manifests中。

运行后可通过RESTful接口访问,支持通过curl等工具进行交互。

端侧模型具有记忆能力,能反馈错误并进行修正。

步骤详解:

Step 1: 下载ollama

1、访问ollama官网或GitHub页面,找到下载链接。

2、根据平台选择合适的版本进行下载。

3、安装软件并将解压后的文件拷贝到应用程序目录。

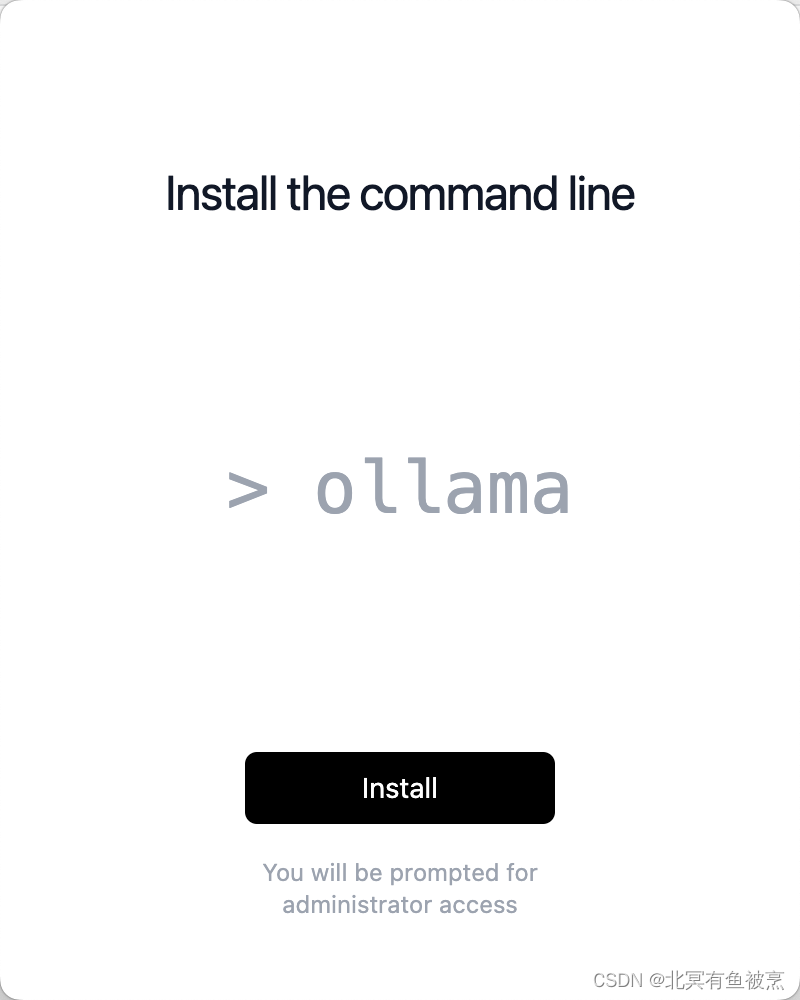

4、安装用户态命令。

Step 2: 下载模型文件

1、访问ollama的库页面,查看支持的模型列表。

2、选择要下载的模型,例如llama3。

3、使用命令行进行安装。

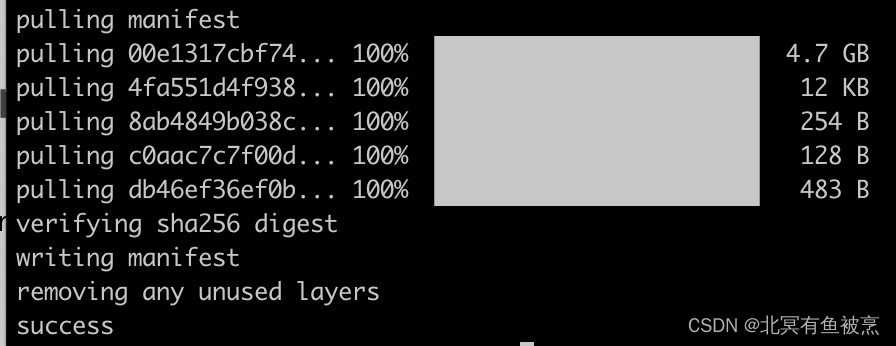

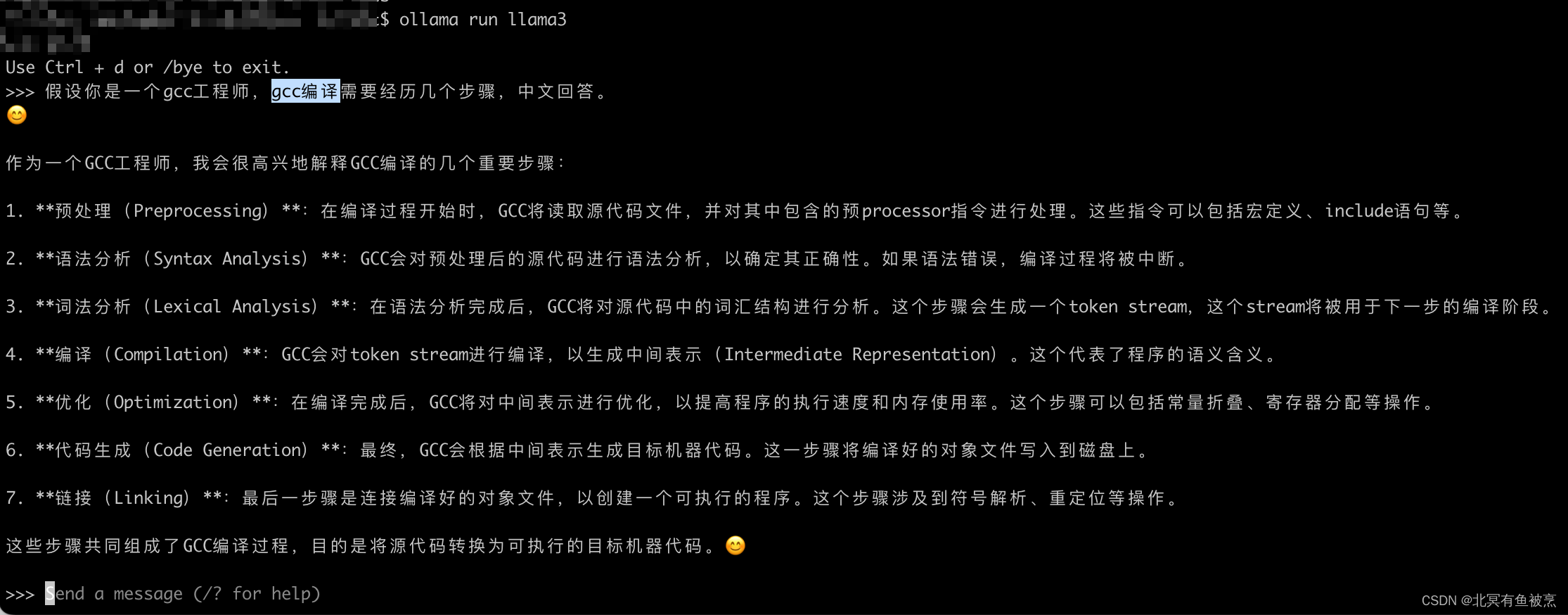

Step 3: 运行模型

1、使用命令“ollama run 模型名称”来运行模型。

2、根据模型大小和网络状况,安装过程可能需要一些时间。

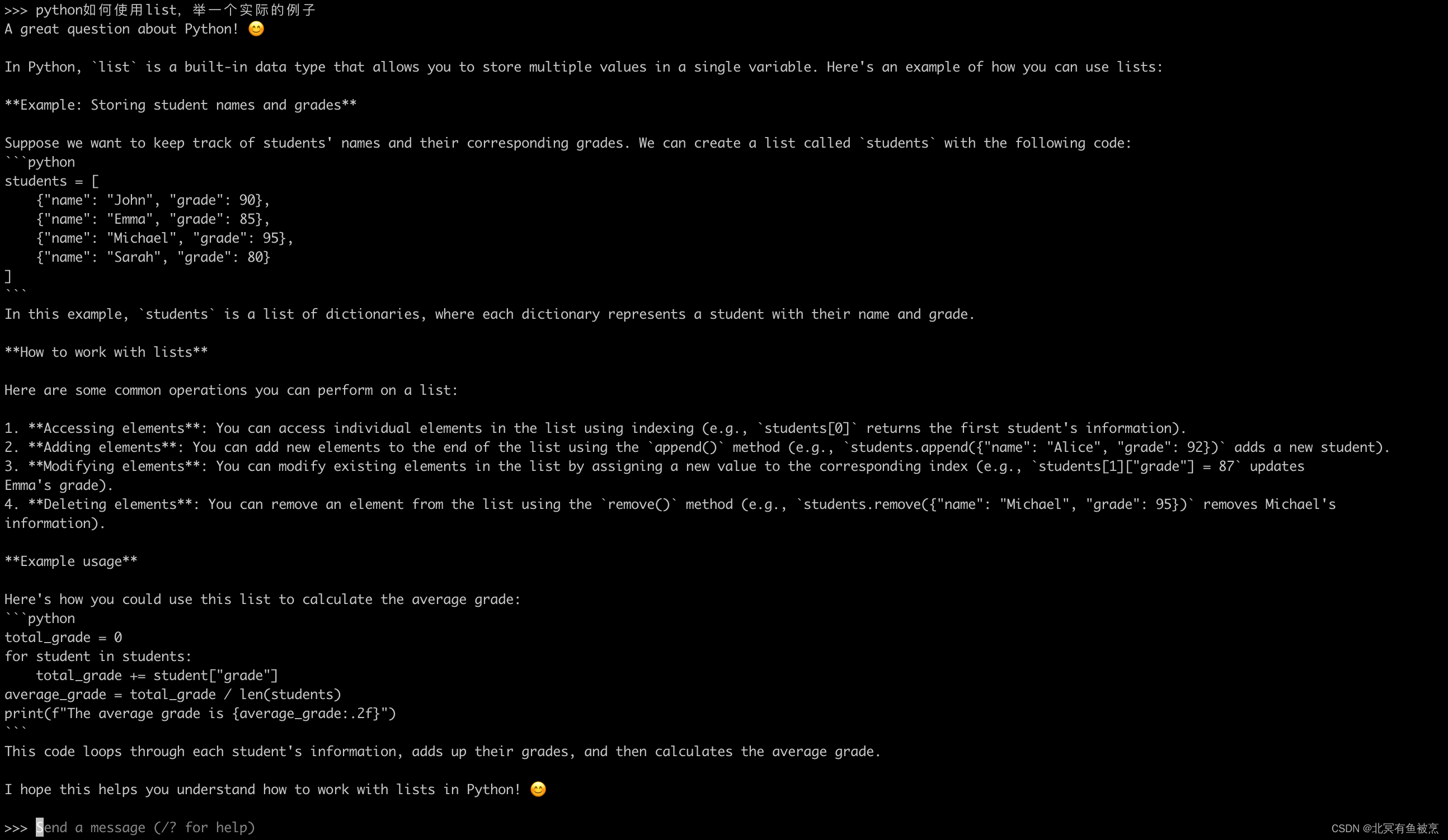

3、安装完成后,可以通过直接与模型交互来测试其功能。

其他注意事项:

ollama的模型存储地址在mac上是~/.ollama/models/blobs/。

models/manifests中存储了模型的配置信息。

运行模型后,可以通过局域网访问,端口为11434。

可以通过curl等工具使用restful方式访问模型。

端侧模型具有记忆能力,并能反馈和修正错误。

可以通过命令“/show info”查看当前使用的模型信息。

Ollama是一个简单易用的本地大语言模型运行工具,通过简单的步骤就能使用各种大语言模型,一台性能不错的笔记本加上网络连接,就能快速体验各种语言大模型的魅力。

还没有评论,来说两句吧...