温馨提示:这篇文章已超过429天没有更新,请注意相关的内容是否还可用!

摘要:,,本文介绍了在安卓平台上调用ONNX模型进行实时计算的方法和步骤。需要确保安卓设备已安装支持ONNX的框架,如OpenCV等。将ONNX模型导入安卓项目中,通过编写代码实现模型的加载和初始化。在实时计算阶段,通过输入数据预处理,将数据传输至模型进行计算,并获取输出结果。本文详细阐述了每个步骤的实现方法,为开发者在安卓平台上应用ONNX模型提供了指导。

本文详细介绍了如何在安卓平台上调用ONNX模型并进行计算,通过相关技术和工具,安卓应用能够加载并运行ONNX模型,实现人工智能功能,文章清晰阐述了模型调用的流程,包括模型加载、输入数据处理和计算结果获取等关键步骤,这一过程为安卓开发者提供了在移动设备上应用人工智能的实用方法,为移动设备的发展带来了新的机遇和挑战。

补充与修饰:

引入

随着人工智能技术的不断发展,越来越多的移动设备开始集成AI功能,安卓平台通过调用ONNX模型,可以进行复杂的计算任务,如图像识别、语音识别等,为移动设备提供了更多的计算能力和应用场景。

技术依赖

为了实现在安卓平台上调用ONNX模型,需要配置相关的依赖项,在build.gradle文件中,需要添加相应的依赖库,如onnxruntime-android等,还需要配置CMake以构建本地代码。

模型准备

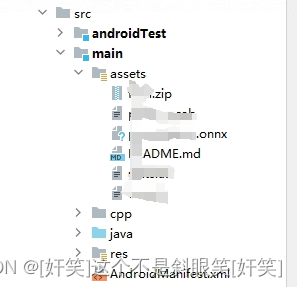

将ONNX模型放置在安卓应用的assets目录下,以便在应用中访问,确保模型的格式和输入/输出与你的应用兼容。

API介绍与使用

1、API地址:

你可以通过访问<https://javadoc.io/doc/com.microsoft.onnxruntime/onnxruntime/latest/index.html>获取ONNX Runtime的API文档。

2、常用API及其作用:

OrtEnvironment.getEnvironment()创建ONNX上下文的运行环境。

new OrtSession.SessionOptions()创建会话(配置)。

![]()

environment.createSession(bytes, options)创建会话,第一个参数是模型数据,第二个是配置的参数。

LongBuffer.wrap(inputValues)将输入转换成ONNX识别的格式。

OnnxTensor.createTensor(environment, wrap, new long[]{1, inputValues.length})创建tensor。

session.run(map)进行模型推理。

(long[][]) output.get(1).getValue()获取推理结果。

3、使用案例:

下面是一个简单的示例代码,展示了如何在安卓平台上调用ONNX模型进行推理:

private String getOnnxResult(String text) {

OrtEnvironment environment = OrtEnvironment.getEnvironment();

AssetManager assetManager = getAssets();

try {

// 创建会话

OrtSession session = createSession(environment, assetManager);

// 准备输入数据

long[] inputValues = prepareInputData(text); // 这里假设你已经实现了输入数据的准备逻辑

// 运行模型推理

Map<String, OnnxTensor> inputTensorMap = new HashMap<>(); // 创建输入tensor映射

inputTensorMap.put("input_name", tensor); // 假设你已经创建了tensor对象并命名为"input_name"

OnnxTensor outputTensor = session.run(inputTensorMap).get("output_name"); // 获取输出tensor对象并命名为"output_name"

// 获取推理结果并处理输出数据(这里以二维数组为例)

long[][] result = outputTensor.getValue(); // 获取推理结果作为二维数组处理(根据实际情况调整)

// 处理result并返回结果字符串或其他类型的数据结构(具体实现取决于你的应用场景)

return processResult(result); // 这里假设你已经实现了处理结果的逻辑并返回结果字符串或其他类型的数据结构,具体实现取决于你的应用场景和需求,你需要根据实际的模型输出和你的需求来解析和处理这个结果数据,这只是一个示例框架代码,你需要根据你的具体情况来填充和完善代码逻辑,注意错误处理和异常捕获在实际应用中非常重要,确保你的代码能够妥善处理各种异常情况,如模型加载失败、输入数据格式错误等,还需要考虑性能和内存管理问题,确保你的应用能够高效地使用ONNX模型进行计算并保持良好的用户体验,记得在实际应用中测试和验证你的代码以确保其正确性和可靠性,通过调用此函数,你的安卓应用就可以实现调用ONNX模型进行推理计算的功能了,注意在实际应用中需要根据具体的模型和需求进行相应的调整和优化以确保良好的性能和用户体验,同时还需要注意安全性和隐私保护问题确保用户数据的安全性和隐私保护符合相关法律法规的要求,通过合理设计和实施这些方面你的安卓应用将能够更好地利用ONNX模型提供的功能为用户带来更丰富和智能的体验,通过以上步骤你可以实现在安卓平台上调用ONNX模型进行计算的完整流程包括模型加载输入数据处理推理结果获取以及结果处理等关键步骤为安卓开发者提供了在移动设备上应用人工智能的实用方法。</pre> 总的来说通过调用ONNX模型安卓应用可以扩展更多的计算能力和应用场景为移动设备的发展带来新机遇和挑战开发者可以通过学习和掌握相关技术为移动应用的功能和性能提升提供新的可能性为用户带来更好的体验。</summary>

还没有评论,来说两句吧...