温馨提示:这篇文章已超过425天没有更新,请注意相关的内容是否还可用!

摘要:本文介绍了神经网络与深度学习领域中的时间卷积网络(TCN)。TCN是一种新型的深度学习模型,通过引入时间卷积结构,解决了循环神经网络(RNN)在处理序列数据时存在的计算效率低下和难以学习长期依赖关系的问题。TCN具有并行计算能力强、计算效率高等优势,在语音识别、自然语言处理等领域得到了广泛应用。

时间卷积网络(Temporal Convolutional Network,TCN)是一种基于卷积神经网络(CNN)思想的深度学习模型,专门用于处理时序数据,通过卷积操作,TCN能够提取和学习时序数据中的特征,与传统的循环神经网络(RNN)相比,TCN具有诸多优势。

TCN可以高效地并行计算,在处理长序列数据时表现出卓越的性能,TCN通过使用可扩展的膨胀卷积(Dilated Convolution)捕捉长期依赖关系,能够更好地处理长距离的时间依赖,相较于RNN,TCN更易于训练,并有效避免梯度消失或梯度爆炸的问题。

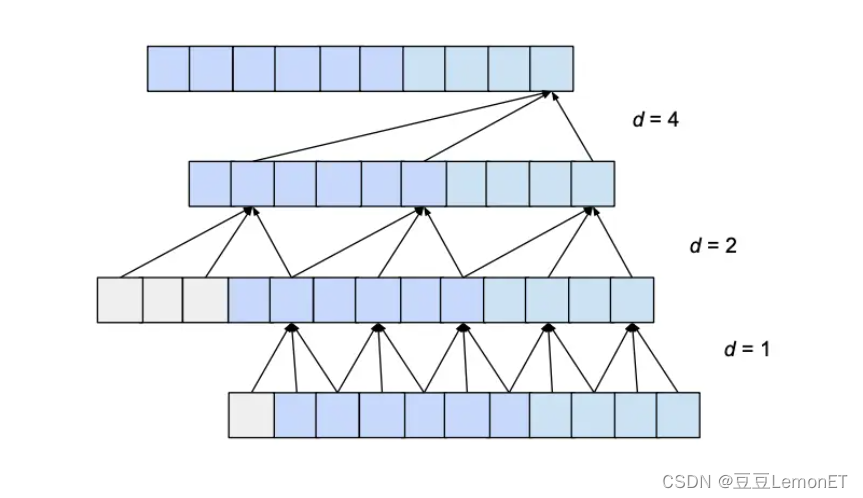

TCN的核心在于使用膨胀卷积(Dilated Convolution),这种卷积结构在不增加参数数量的前提下扩大了网络的感受野(Receptive Field),从而有效地捕捉长期依赖关系,通过堆叠多层卷积,TCN增加了模型的表示能力,使其在各种时序任务中表现出色。

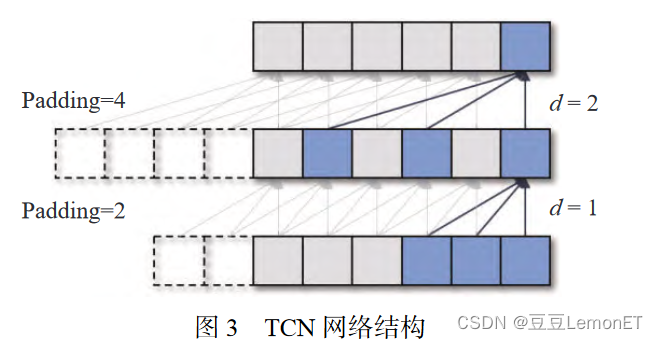

TCN的网络结构中的膨胀卷积部分,d表示膨胀系数,最下面的层d=1,表示对输入进行每个点的采样,随着层数的上升,d的值逐渐增加,意味着输入采样的间隔增大,这种设计使得有效窗口的大小随着层数呈指数型增长,使得卷积网络在较少的层数下就能获得很大的感受野。

TCN在处理时序数据方面具有重要的研究和应用意义,其在语音识别、自然语言处理、动作识别等领域得到了广泛应用,并且在一些任务中取得了与RNN和传统时间序列模型相媲美甚至超越的性能表现。

空洞 / 膨胀卷积(Dilated Convolution)

膨胀卷积是卷积神经网络中的一种卷积操作,也称为空洞卷积,相较于普通卷积,膨胀卷积引入了膨胀率(dilation rate)参数,可以在不增加参数数量的前提下增大感受野,从而捕获更广泛的上下文信息。

在膨胀卷积中,卷积核中的元素不再直接对应输入数据中的相邻位置,而是通过插入空洞来扩大感受野,这种操作可以有效地增加卷积层的视野范围,从而更好地捕获输入数据中的长程依赖性,膨胀卷积有助于神经网络更好地处理具有全局关联性的任务,如语义分割、图像超分辨率等。

为了确保输出序列与输入序列具有相同的长度,膨胀卷积过程中会应用一些零填充,这意味着在输入张量的开始或结束处添加额外的零值项,以确保输出具有所需的长度。

感受野的大小取决于网络的结构和参数设置,可以通过卷积核的大小、步长以及网络的层数来调节,较小的感受野主要捕获局部特征,而较大的感受野则能捕获更广泛的上下文信息,感受野宽度的计算公式给出了一个量化的方法来确定感受野大小与网络结构之间的关系。

时间卷积网络(TCN)主要利用卷积神经网络(CNN)对只有时间序列关系的数据进行特征提取,其主要优点包括并行化处理的高效性、捕获长距离依赖的能力、参数共享以及易于实现和调试等,TCN也存在一些缺点,如固定长度建模、信息丢失、处理长期依赖关系的挑战以及在某些情况下的稀疏性问题,TCN是一种有效的时序数据处理方法,具有广泛的应用前景。

还没有评论,来说两句吧...