温馨提示:这篇文章已超过421天没有更新,请注意相关的内容是否还可用!

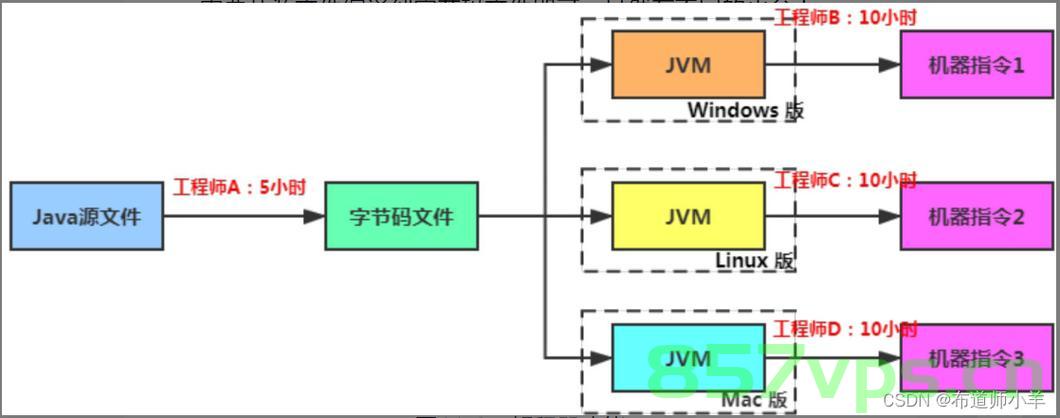

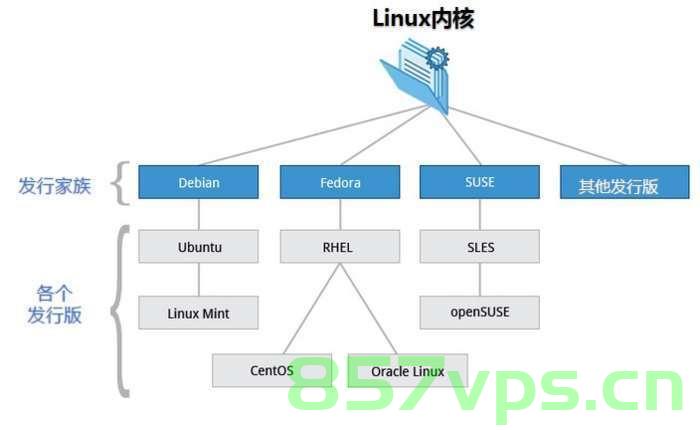

摘要:本教程全网唯一,详细介绍了在Linux Ubuntu、Mac和Windows系统上部署离线通义千问1.8B参数4-bit量化大模型的步骤。本文提供了详细的指南,包括大模型的离线部署参数和4-bit量化解析,帮助用户在这三种操作系统上顺利部署通义千问大模型。

本文为读者提供了在Linux Ubuntu、Mac和Windows系统上部署离线通义千问1.8B参数4-bit量化大模型的详尽步骤,结合独特的教程内容和实用的操作建议,帮助用户在这三种主流操作系统上成功部署大模型,本文旨在普及和推广相关技术,为相关领域的研究者和爱好者提供便利。

预备知识

为确保顺利部署,读者需具备基本的Python知识,包括Python和pip的安装,以及如何使用pip安装依赖库,对于希望直接使用离线大模型整合包的读者,目前支持Windows系统,相关介绍链接如下:

Windows系统的离线整合包文章介绍链接[链接地址]

对于没有Python基础或不想手动安装依赖库的读者,可通过以下链接获取更多信息和使用方法:

链接1[链接地址]

链接2[链接地址]

正文部分:

1. CPU运行部署步骤

(1) 安装Python并确保版本为3.8或以上,建议在虚拟环境中进行安装,以隔离不同项目的依赖关系。

(2) 安装llama cpp python库,这是运行大模型所必需的依赖库。

(3) 使用pip安装llama-cpp-python库,为加速安装过程,可以使用清华大学的镜像源:

pip install llama-cpp-python -i https://pypi.tuna.tsinghua.edu.cn/simple/

(4) 从百度网盘下载模型文件,模型文件大约1.3GB,下载链接:[链接地址](提取码:xxxx),下载后,解压文件夹内将包含所需的大模型文件。

接下来的内容可以根据实际情况进行补充和完善,包括但不限于:

详细解释如何解压模型文件并放置到指定目录。

如何在不同操作系统上配置环境变量。

启动模型的命令和步骤。

常见问题解决方案和注意事项。

本文提供了详细的教程,帮助用户在Linux Ubuntu、Mac及Windows系统上部署离线通义千问1.8B参数4-bit量化大模型,随着技术的不断进步和模型的持续更新,未来的大模型部署可能会更加简便和高效,我们期待更多的研究者和爱好者加入到这一领域,共同推动技术的发展。

还没有评论,来说两句吧...