温馨提示:这篇文章已超过414天没有更新,请注意相关的内容是否还可用!

摘要:,,本次排查记录显示服务器GPU温度过高导致故障。具体表现为无法确定设备句柄,错误提示为“Unknown Error”。经过初步检查,问题可能与GPU 0000:01:00.0的硬件故障或驱动程序问题有关。当前正在进一步排查硬件故障并尝试更新或重新安装驱动程序以解决问题。需要密切关注GPU温度,并采取有效的散热措施,以避免类似问题再次发生。

在深度学习的计算过程中,突然发现GPU运行中断,通过命令nvidia-smi查看,发现GPU出现问题,显示错误信息为“Unable to determine the device handle for GPU”,重启后,问题短暂解决,但过一段时间后又会再次出现,究竟是什么原因导致GPU自动掉线呢?

问题排查

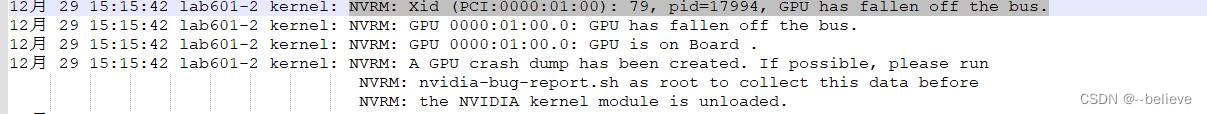

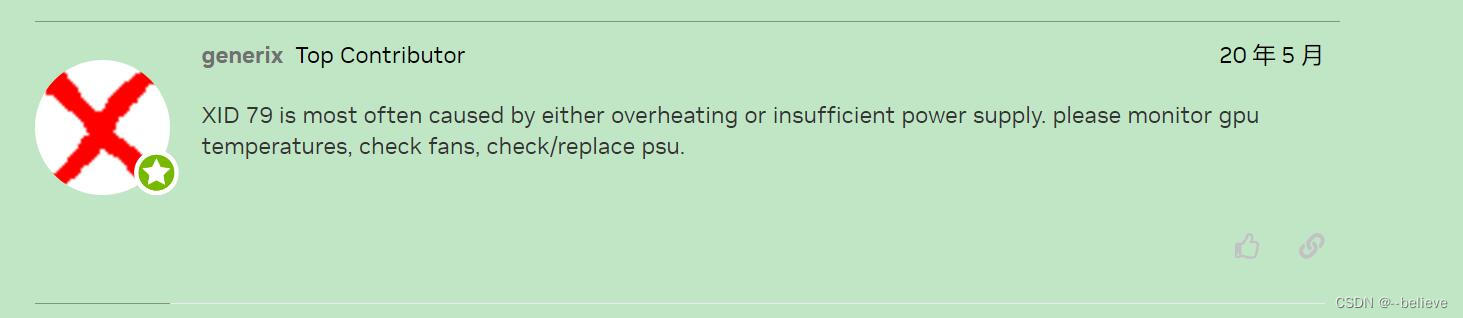

通过运行nvidia-bug-report.sh生成日志,查找错误原因,在日志中发现报错代码和相关描述,通过网上查询,可能是电源问题或温度过高导致。

重现问题,查看温度日志

为了确认是否是GPU温度过高导致的问题,我们使用了nvidia-smi -q -l 2 -d TEMPERATURE -f nvidiatemp.log命令来记录温度日志,在代码运行过程中,等待问题重现后查看温度日志,果然,当GPU掉线后,日志中的当前温度超过了设定的自动掉线温度。

三. 问题定位

通过查看温度日志,我们发现CurrentTemp(当前温度)超过了Shutdown Temp(自动掉线温度),证实了温度过高是导致GPU掉线的原因。

解决问题

经过检查,发现服务器散热存在问题,一个显卡风扇转动较慢,拆开发现,风扇转轴有杂质,增大了风扇阻力,清理杂质并上润滑油后,装上风扇,服务器温度得以正常控制,GPU再也没有出现掉线问题。

本案例详细描述了服务器GPU因温度过高自动掉线的问题排查与解决过程,通过查看日志、重现问题、查看温度日志、定位问题、解决问题等步骤,最终成功解决了GPU过热问题,这也提醒我们,服务器的硬件维护和散热问题需引起足够的重视,参考链接:gpu-has-fallen-of-the-bus。

还没有评论,来说两句吧...