温馨提示:这篇文章已超过411天没有更新,请注意相关的内容是否还可用!

摘要:,,使用Python的pyarrow.parquet和pandas库,可以轻松读取和使用Parquet文件。Parquet是一种列式存储格式,适用于大数据处理。通过pyarrow.parquet,可以高效读取Parquet文件数据,并结合pandas进行数据分析和处理。这一组合提供了快速的数据加载、查询和分析能力,适用于处理大规模数据集。

文章目录

1、所需的库

使用pyarrow.parquet模块处理Parquet文件时,通常需要导入以下库:

import pyarrow.parquet as pq import pandas as pd

pyarrow.parquet模块提供了读取和写入Parquet文件的功能,以及一系列与Parquet格式相关的操作,也可以利用该模块将DataFrame的数据保存为Parquet格式。

2、终端指令

为了安装pyarrow库,可以使用以下终端指令:

conda create -n DL python==3.11 conda activate DL conda install pyarrow

或者

pip install pyarrow

pyarrow.parquet操作指南

当使用pyarrow.parquet模块时,常见的操作包括读取和写入Parquet文件,以及对Parquet文件中的数据进行操作和转换,以下是一些常见用法:

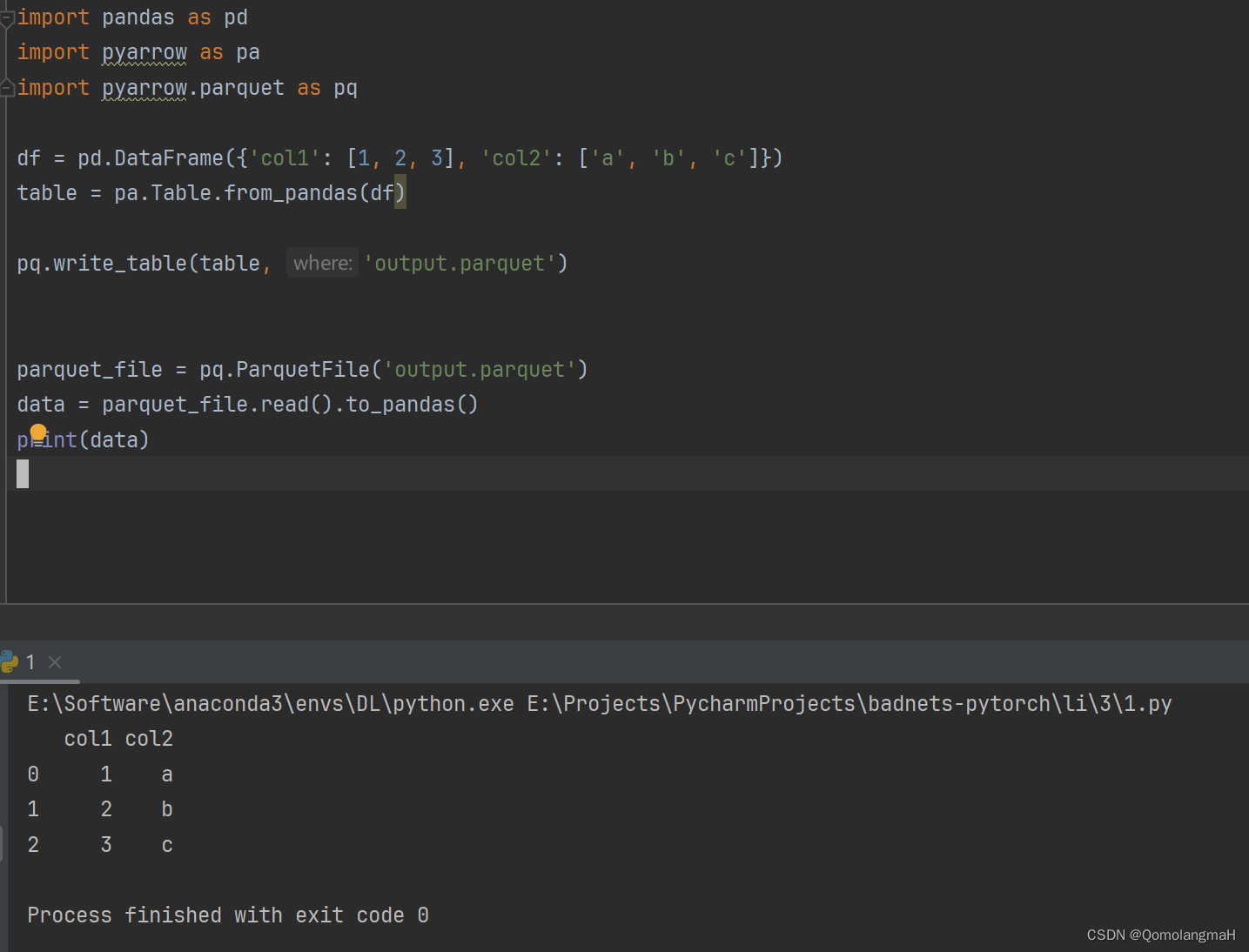

1、读取Parquet文件

使用pyarrow.ParquetFile打开Parquet文件,然后使用read().to_pandas()方法将文件中的数据读取为pandas DataFrame,示例代码如下:

parquet_file = pq.ParquetFile('file.parquet')

data = parquet_file.read().to_pandas()2、写入Parquet文件

将pandas DataFrame转换为Arrow的Table格式,然后使用pq.write_table方法将Table写入为Parquet文件,示例代码如下:

df = pd.DataFrame({'col1': [1, 2, 3], 'col2': ['a', 'b', 'c']})

table = pa.Table.from_pandas(df)

pq.write_table(table, 'output.parquet')3、对数据进行操作

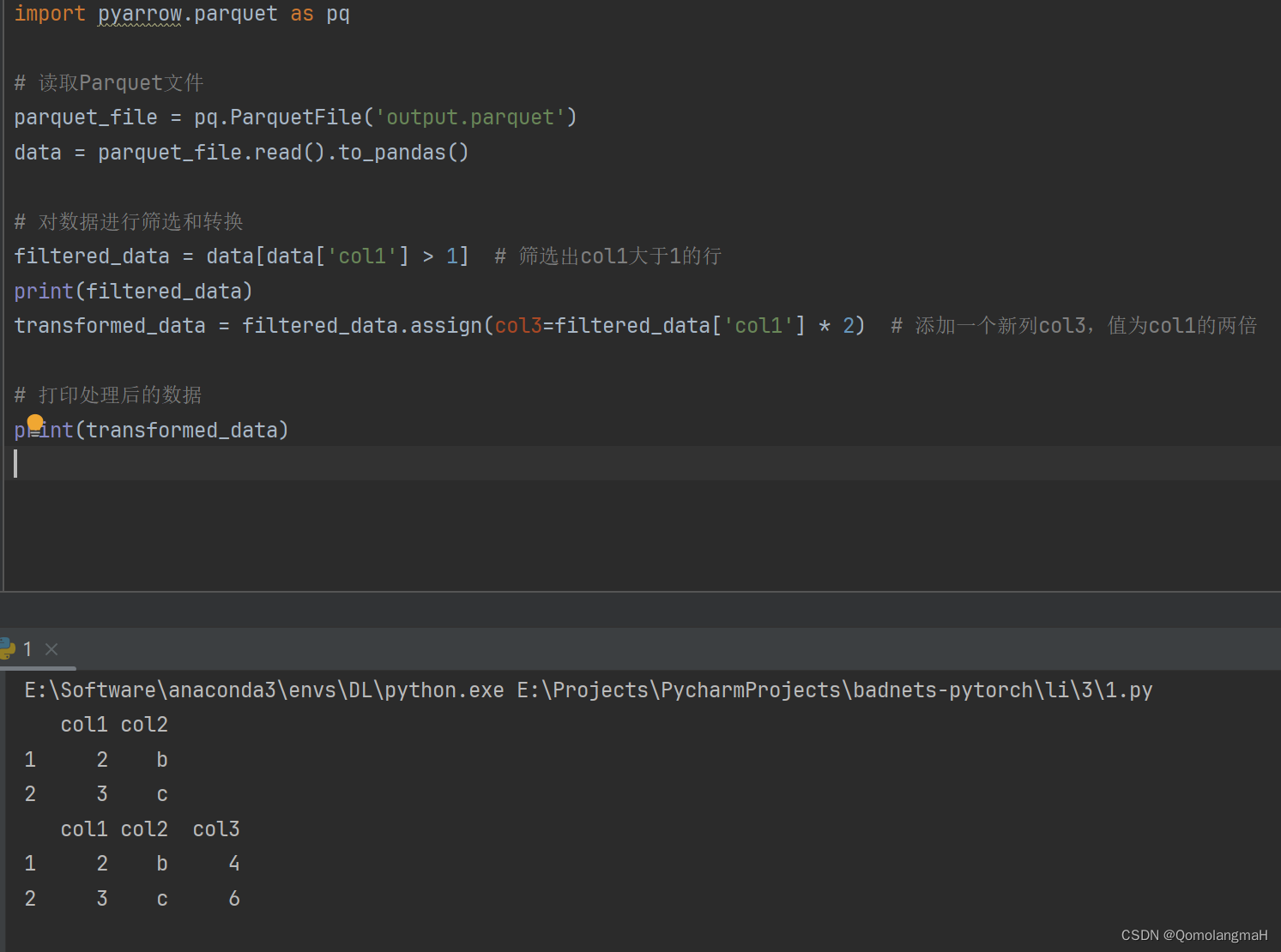

读取Parquet文件中的数据,然后对其进行筛选、转换等操作,示例代码如下:

parquet_file = pq.ParquetFile('output.parquet')

data = parquet_file.read().to_pandas()

对数据进行筛选和转换

filtered_data = data[data['col1'] > 1] # 筛选出col1大于1的行

transformed_data = filtered_data.assign(col3=filtered_data['col1'] * 2) # 添加一个新列col3,值为col1的两倍

打印处理后的数据

print(transformed_data)4、导出数据为csv

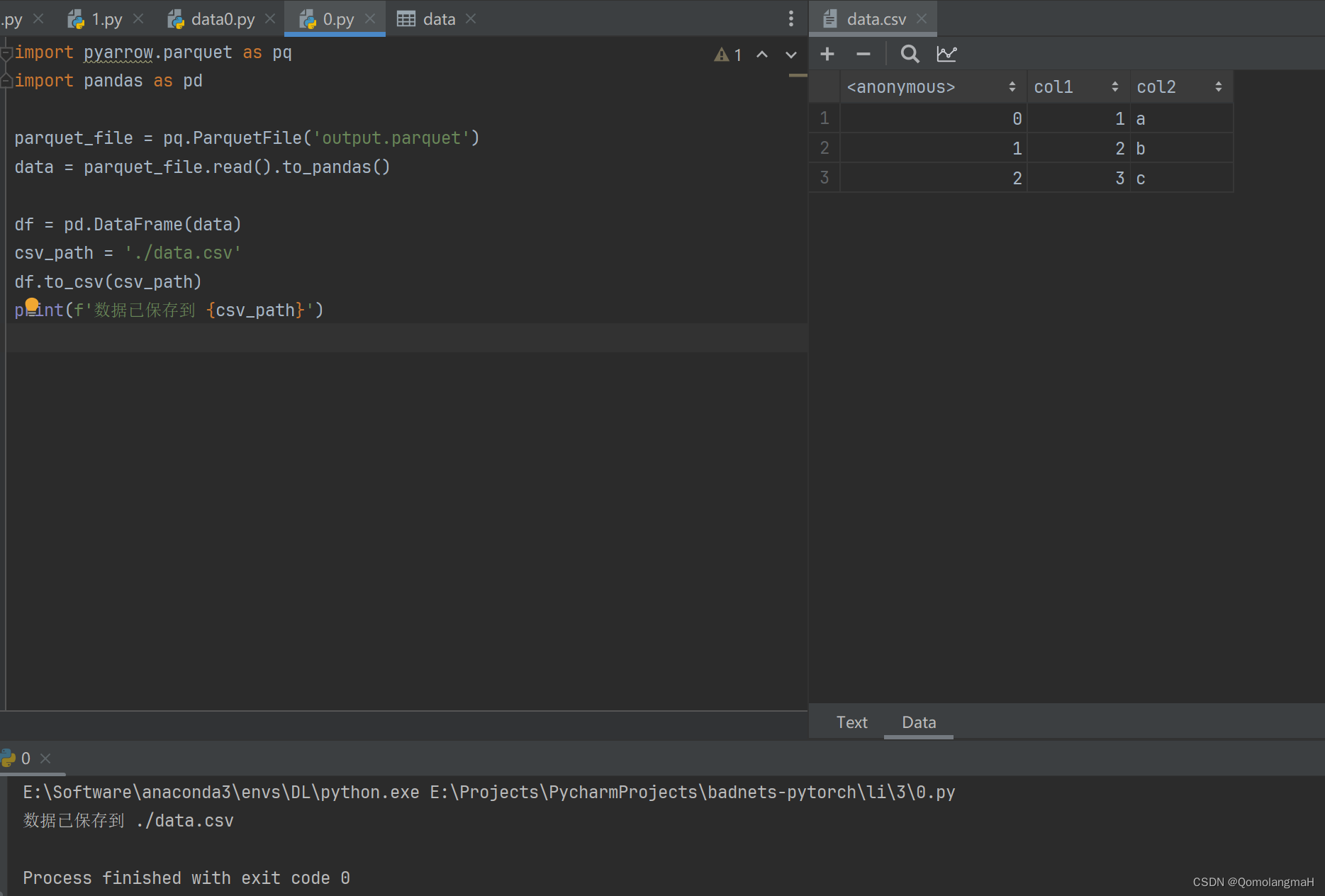

将处理后的数据保存为csv文件,示例代码如下:

df = pd.DataFrame(data)

csv_path = './data.csv'

df.to_csv(csv_path)

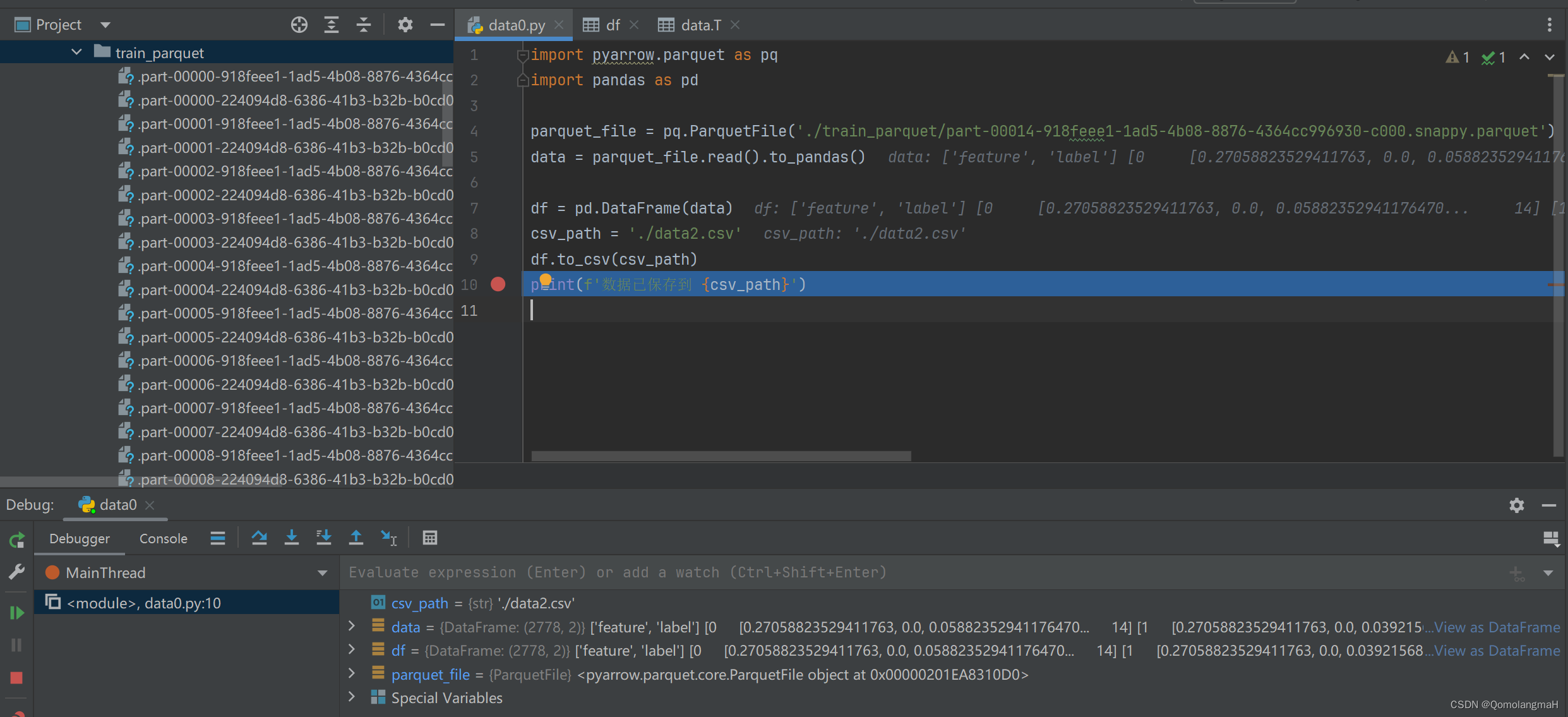

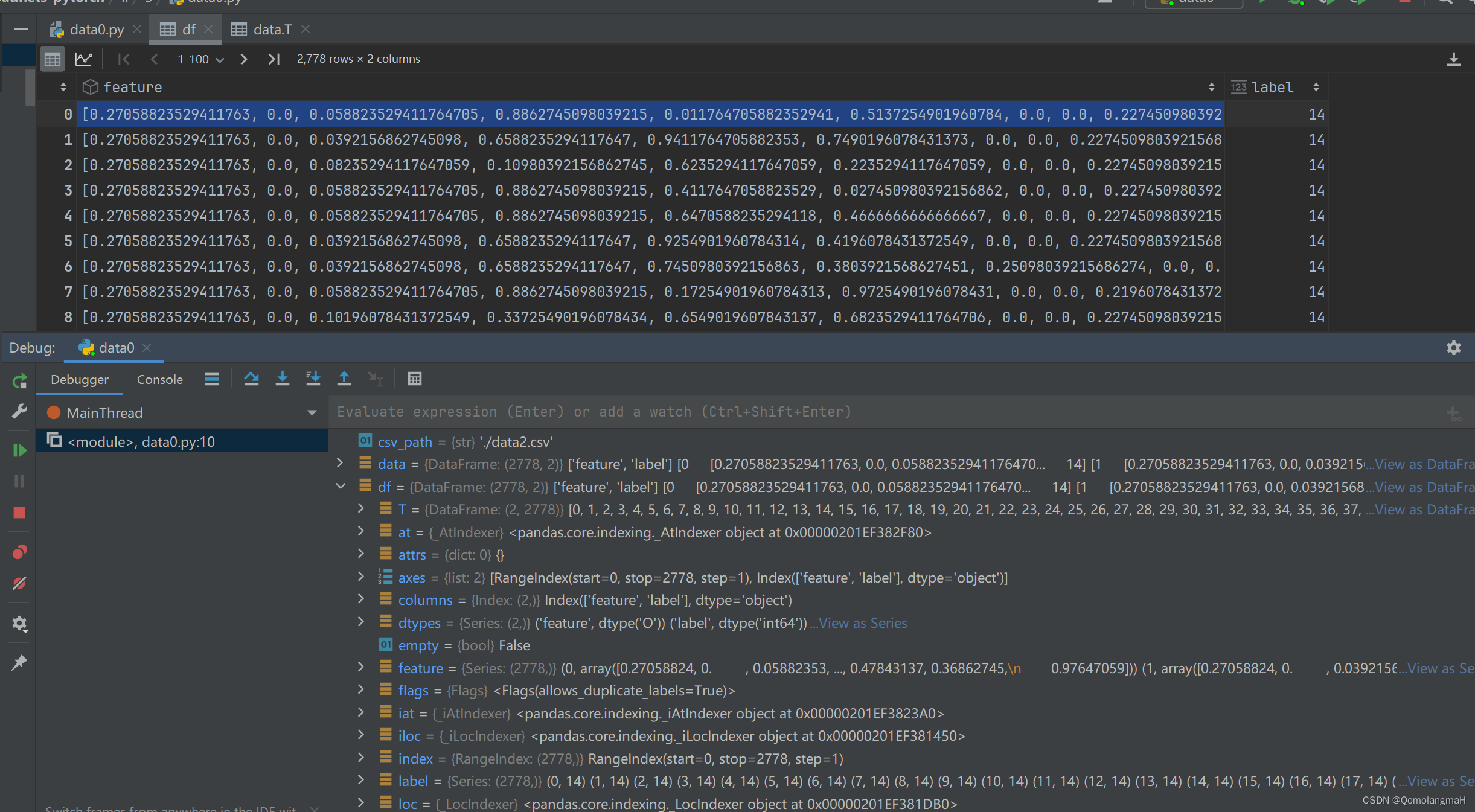

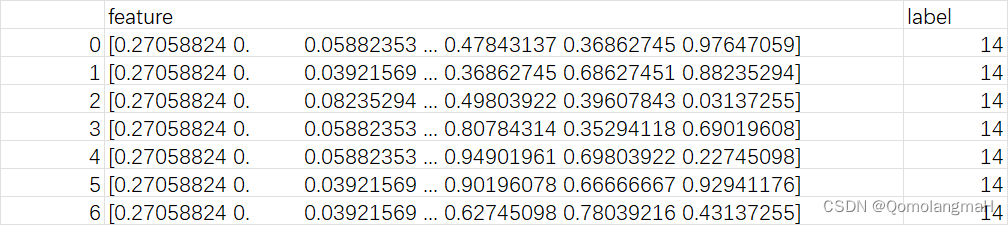

print(f'数据已保存到 {csv_path}')三 实战操作 ...........(后续部分按照您的实战内容继续编写)

文章版权声明:除非注明,否则均为VPS857原创文章,转载或复制请以超链接形式并注明出处。

还没有评论,来说两句吧...