温馨提示:这篇文章已超过410天没有更新,请注意相关的内容是否还可用!

摘要:本文介绍了PyTorch中的torch.no的详细解释。torch.no是一个用于禁用计算图的上下文管理器,它可以帮助减少计算资源的占用和提高计算效率。在使用torch.no时,可以暂停梯度计算和跟踪,从而避免不必要的内存占用和计算开销。本文简要概述了torch.no的作用和使用方法,以帮助读者更好地理解和应用这一工具。

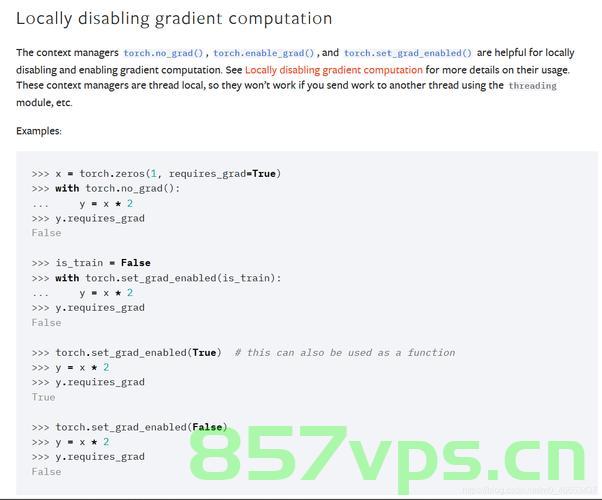

【Python】torch.no_grad() 是一个上下文管理器,用于在执行某些操作时暂时禁用梯度计算,在PyTorch框架中,torch.no_grad()用于确保某些操作不会计算梯度,从而避免不必要的内存使用和计算时间,这对于仅评估模型而不进行训练时特别有用,简而言之,torch.no_grad()是一个控制PyTorch操作是否计算梯度的工具。

当你在torch.no_grad()的上下文管理器中执行张量操作时,PyTorch不会为这些操作计算梯度,这意味着这些操作不会累积梯度,并且执行速度会更快,这对于调试和测试过程中的操作顺序控制特别有帮助。

以下是使用torch.no_grad()的示例代码:

import torch

创建一个需要梯度的张量

x = torch.tensor([1.0], requires_grad=True)

使用torch.no_grad()上下文管理器来禁用梯度计算

with torch.no_grad():

y = x * 2 # 这个操作不会计算梯度

由于在no_grad()上下文中,所以无法对y进行反向传播计算梯度

如果尝试这样做,将会出现错误

try:

y.backward() # 这将引发错误,因为y是在没有梯度计算的上下文中计算的

except RuntimeError as e:

print(f"错误:{e}") # 输出:错误:element 0 of tensors does not require grad and does not have a grad_fn

如果不使用torch.no_grad(),则可以正常计算梯度

y = x * 2 # 这个操作会计算梯度

y.backward() # 正确计算梯度

print(x.grad) # 输出:tensor([2.])在上面的代码中,当使用torch.no_grad()时,尝试对没有计算梯度的张量进行反向传播会引发错误,而在不使用torch.no_grad()的情况下,可以正常计算梯度并打印出来。

文章版权声明:除非注明,否则均为VPS857原创文章,转载或复制请以超链接形式并注明出处。

还没有评论,来说两句吧...