温馨提示:这篇文章已超过410天没有更新,请注意相关的内容是否还可用!

本文是关于YOLOv8实战第三天的保姆级教程,主要介绍了如何使用TensorRT部署YOLOv8模型并使用Python进行推理。本文详细指导了从模型部署到Python推理的整个过程,适合初学者入门学习。通过本文的学习,读者可以掌握YOLOv8模型在TensorRT上的部署方法和Python推理技巧。

本文详细介绍了如何使用TensorRT部署YOLOv8模型,并利用Python进行推理,对于初学者来说,这是一个绝佳的入门教程,通过本文的学习,读者将掌握YOLOv8模型的部署和Python推理技巧。

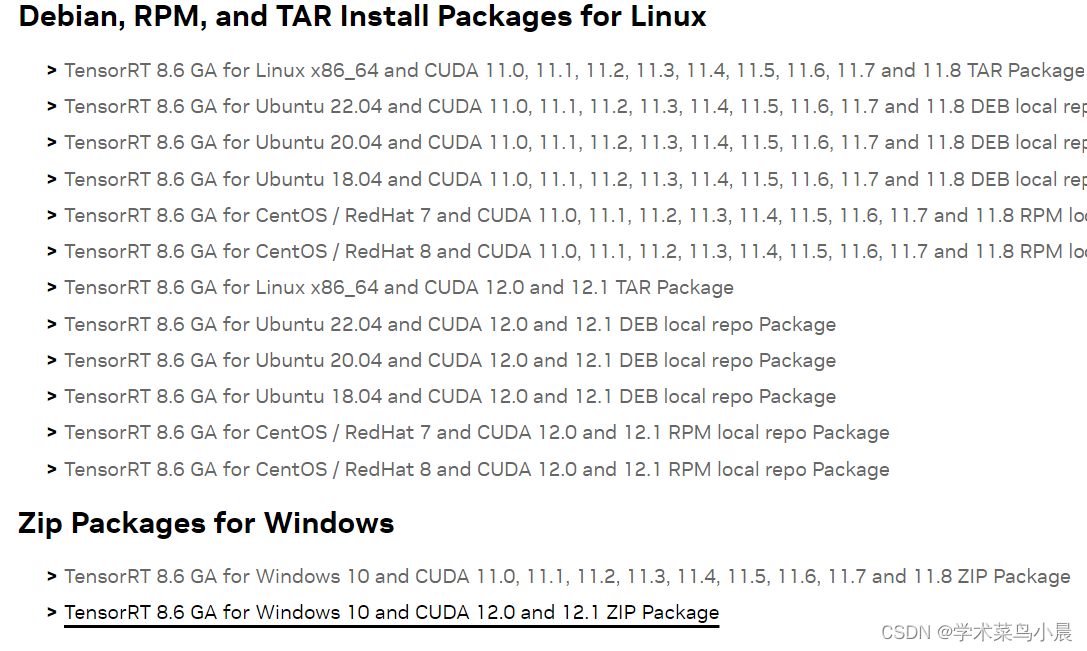

请前往NVIDIA开发者网站下载TensorRT,推荐的下载版本是TensorRT-8.6.1.6,接下来是安装和配置TensorRT的步骤:

1、将TensorRT的头文件复制到CUDA的include文件夹。

2、将lib文件复制到CUDA的lib文件夹中的x64子文件夹。

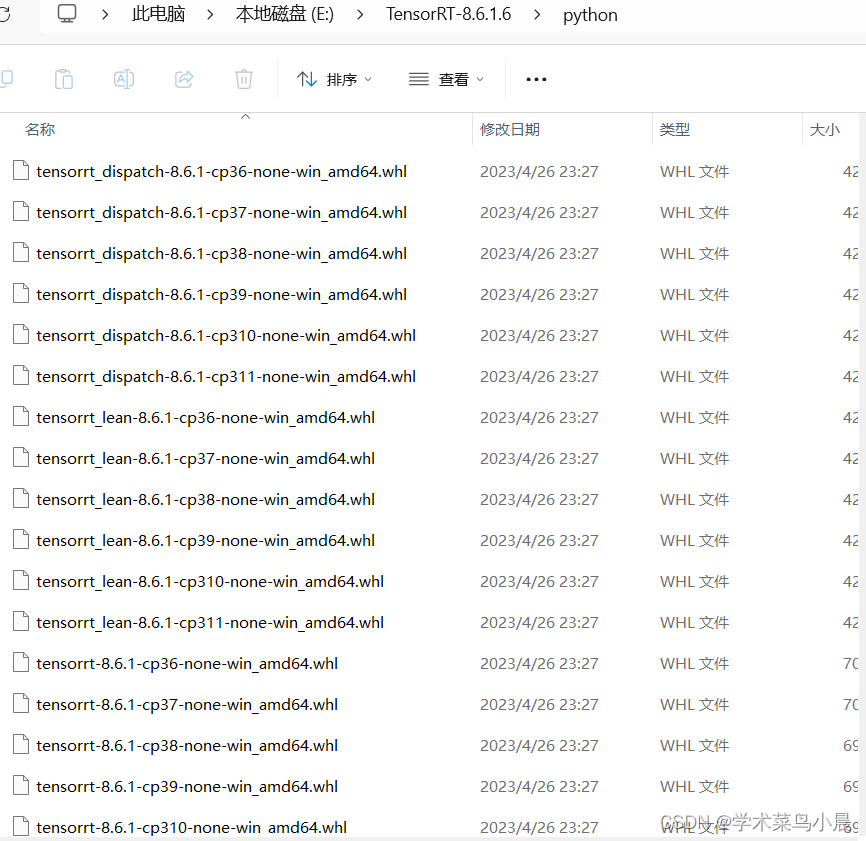

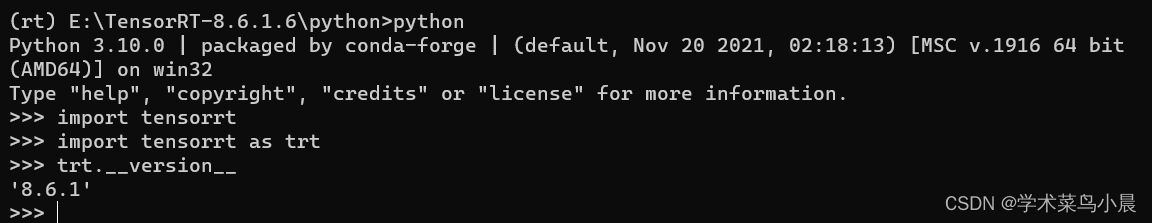

在Python环境中,使用以下命令安装TensorRT:

pip install tensorrt-8.6.1-cp310-none-win_amd64.whl

请确保CUDA版本与TensorRT版本兼容,关于CUDA的安装和配置,您可以参考NVIDIA官方文档或其他相关教程。

我们将进入模型转换和部署阶段,需要将模型转换为ONNX格式,在开始转换之前,请确保您已经安装了所有必要的环境和工具,参考相关教程和GitHub资源,使用特定命令生成ONNX模型,具体的命令参数可能根据您的模型和需求有所不同,请根据实际情况进行调整。

接下来是TensorRT部署阶段,您需要导出engine模型,然后可以使用Python脚本进行推理,编写一个名为infer-det.py的脚本,利用TensorRT进行推理并展示检测结果,具体代码实现可以参考提供的代码片段或相关教程,在运行脚本时,您需要指定engine文件路径、输入图片路径、是否展示检测结果、输出目录和推理设备等信息,脚本会将检测结果绘制在图片上并保存。

至此,您已经完成了使用YOLOv8模型进行目标检测的TensorRT部署过程,在此过程中,我们提供了详细的步骤和说明,希望对您有所助益,如果在任何环节遇到问题,欢迎随时提问,为了更好地优化模型和提高检测精度,您可以进一步探索YOLOv8的进阶功能和技巧,祝您在目标检测领域取得更多成果!

还没有评论,来说两句吧...