温馨提示:这篇文章已超过467天没有更新,请注意相关的内容是否还可用!

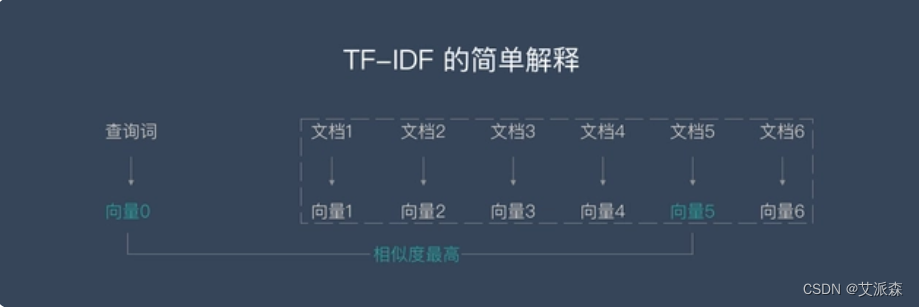

摘要:本文介绍了基于TF-IDF和KMeans聚类算法构建中文文本分类模型的方法,包括案例实战。通过TF-IDF算法对中文文本进行特征提取和权重计算,再利用KMeans聚类算法对特征进行聚类,从而构建文本分类模型。该方法具有简单易懂、易于实现等优点,适用于处理大规模中文文本数据。本文还提供了详细的案例实战,为相关研究人员和开发者提供了有益的参考。

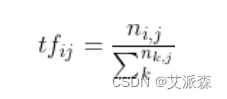

1、在TF-IDF算法介绍部分,关于TF(词频)的计算,你提到了归一化以防止因文本长度不同导致的偏差,这是一个很好的点,但也可以进一步解释,归一化是为了使不同长度的文档在特征空间中有相同的尺度,便于比较。

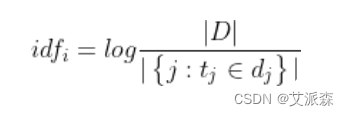

2、关于IDF(逆文档频率)的计算,你提到了分母加1是为了避免分母为0的情况,这种处理是为了防止某些词汇因为未出现在语料库中而导致IDF值过大。

3、在KMeans聚类的部分,关于选择K的值,除了肘部法则,还可以考虑其他的评估方法,如轮廓系数(Silhouette Coefficient)或戴维森-布尔丁指数(Davies-Bouldin Index)等,这些方法都可以帮助我们更科学地选择最佳的K值。

4、在项目实战部分,关于加载数据的部分,可以进一步说明数据预处理步骤,例如去除停用词、词干提取等,这些步骤对于提高文本分类的准确性非常重要。

5、在可视化部分,除了使用TSNE进行降维可视化,还可以尝试使用PCA或其他降维技术进行对比,对于大型数据集,可视化可能会变得困难,这时可以考虑使用降维技术来减少数据的维度以便可视化。

6、关于模型评估部分,除了准确率,还可以考虑使用其他评估指标,如召回率、F1分数等,以更全面地评估模型的性能。

7、关于总结部分,可以进一步讨论可能的改进方向,例如优化特征提取方法、调整模型参数、使用更复杂的模型结构等。

这是一篇很好的文章,详细介绍了TF-IDF和KMeans聚类算法以及一个完整的文本分类项目,通过补充和修正以上建议,可以使文章更加完善。

还没有评论,来说两句吧...