温馨提示:这篇文章已超过465天没有更新,请注意相关的内容是否还可用!

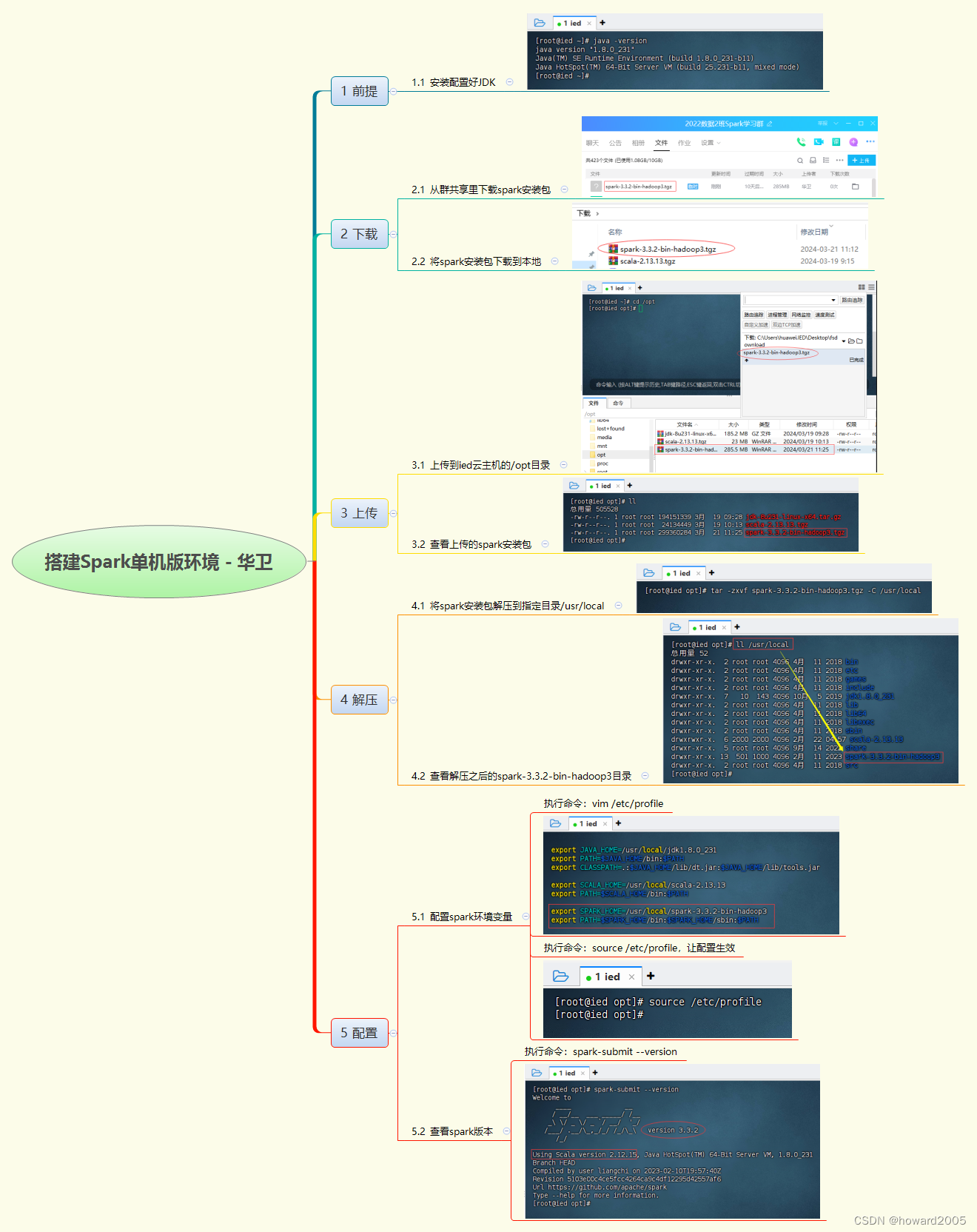

摘要:,,本文提供Spark单机版环境搭建指南。通过简单明了的步骤,让读者了解如何在单机上安装和配置Spark环境。本文旨在帮助开发者快速搭建Spark开发环境,以便进行数据处理和分析。该指南适用于初学者和有一定经验的开发者,是学习和使用Spark的必备参考。

前提条件

请确保您的计算机上已经安装了JDK,并且配置好了环境变量。

下载和安装Spark

1、从官方网站或可靠的群共享渠道下载Spark安装包。

2、将Spark安装包上传至目标主机的/opt目录。

3、解压Spark安装包至/usr/local目录。

配置Spark环境变量

1、编辑/etc/profile文件,添加以下两行配置:

export SPARK_HOME=/usr/local/spark export PATH=$PATH:$SPARK_HOME/bin

2、执行source /etc/profile命令,使配置生效。

验证安装是否成功

执行以下命令查看Spark版本信息,以验证安装是否成功:

spark-submit --version

如果成功显示Spark版本信息,则表示您已经成功搭建了Spark单机版环境。

为了更好地辅助学习和实践,您还可以在搭建完成后,尝试运行一些Spark的基本操作,如数据读取、转换、聚合等,以熟悉Spark的相关功能,这样,您就可以为后续的大数据处理和分析工作做好充分准备。

(注:图片插入描述)<img src="https://img-blog.csdnimg.cn/direct/a3b3bb0ac3684147b1497643563e9d93.png" alt="Spark单机版环境搭建完成示意图">

文章版权声明:除非注明,否则均为VPS857原创文章,转载或复制请以超链接形式并注明出处。

还没有评论,来说两句吧...