温馨提示:这篇文章已超过464天没有更新,请注意相关的内容是否还可用!

摘要:本文介绍了论文"LORA: LOW-RANK ADAPTATION OF LARGE LANGUAGE MODELS",该论文提出了一种针对大型语言模型的低秩适应技术。通过对大型语言模型进行低秩分解和压缩,LORA方法能够在有限的计算资源下提高模型的性能。该技术还可以快速适应不同的任务和数据集,从而提高了模型的灵活性和效率。该论文为大型语言模型的适应和优化提供了新的思路和方法。

文章目录

论文地址

主要贡献

模型图

技术细节

实验结果

论文地址

"LORA: 大规模语言模型低秩适应"

本文介绍了一种名为LoRA(Low-Rank Adaptation)的技术,这是一种针对大型语言模型进行低秩适应的方法,LoRA的核心思想是在预训练模型的基础上,通过注入可训练的低秩分解矩阵到Transformer架构的每一层,而不是对所有模型参数进行微调(fine-tuning),这种方法显著减少了下游任务的可训练参数数量,同时保持预训练权重不变,通过优化低秩矩阵来间接训练密集层的权重更新。

实验表明,LoRA在多个NLP任务上的表现与完全微调相当,甚至在某些情况下更优,LoRA还具有以下优势:

1、显著减少可训练参数数量,与GPT-3 175B微调相比,LoRA可以将可训练参数减少10,000倍。

2、降低GPU内存需求,提高训练效率。

3、由于LoRA的简单线性设计,不会在部署时引入额外的推理延迟。

4、LoRA与许多现有方法正交,可以与其结合使用,例如前缀微调(prefix-tuning)。

文章还提供了对LoRA的实证研究,探讨了语言模型适应中秩不足性的作用,并解释了LoRA的有效性。

主要贡献

文章的主要贡献可以总结为以下几点:

1、提出了LoRA方法:文章提出了一种新的低秩适应(Low-Rank Adaptation, LoRA)方法,用于在不重新训练所有参数的情况下,对大型预训练语言模型进行有效适应。

2、显著降低参数数量和内存需求:LoRA能够将可训练参数的数量减少10,000倍,同时将GPU内存需求降低3倍,使在资源受限的环境中部署和使用大型模型变得更加可行。

3、保持或提升模型性能:尽管LoRA减少了可训练参数的数量,但它在多个NLP任务上的性能与完全微调相当或更好。

4、无额外推理延迟:LoRA的设计允许在部署时将训练矩阵与冻结权重合并,这意味着在推理时不会引入额外的计算延迟。

5、与现有技术的兼容性:LoRA可以与许多现有的模型适应技术结合使用,如前缀微调(prefix-tuning),这增加了LoRA的灵活性和实用性。

6、实证研究:文章提供了对LoRA方法的实证研究,探讨了语言模型适应中秩不足性的作用,并解释了LoRA的有效性。

7、资源和工具的发布:作者发布了一个包,方便将LoRA与PyTorch模型集成,并提供了RoBERTa、DeBERTa和GPT-2的实现和模型检查点,为研究社区提供了宝贵资源。

文章的主要贡献在于提出了一种新的、高效的大型语言模型适应方法,该方法在减少资源消耗的同时,保持了模型的性能,并且易于与现有技术结合使用。

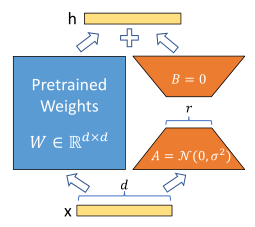

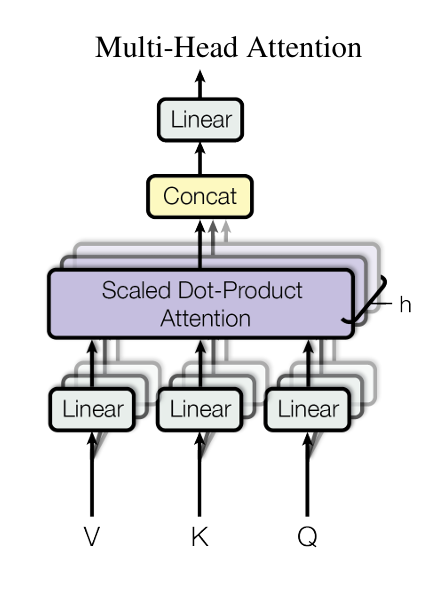

模型图

(在此处插入模型图)

注:左边为预训练模型权重保持不变,只训练右边的A和B矩阵。

(具体图像描述待补充)

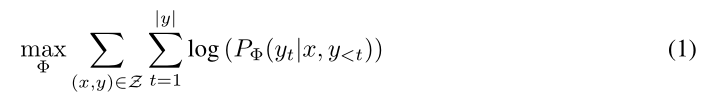

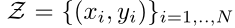

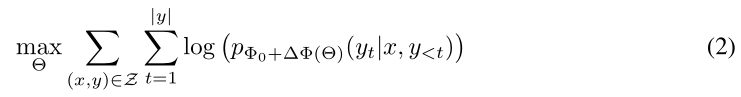

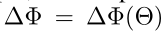

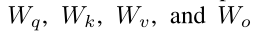

技术细节 假设预训练模型要进行常规全参数微调 (在此处插入技术细节图) 表示模型的参数,x表示输入,y表示输出 (具体图像描述待补充) 表示进行微调任务的数据集 此时我们需要调整的参数就是全参数 (具体图像描述待补充) 但是使用LoRA技术的话 预训练模型的参数都冻结不调整 只是额外加一组小小的参数也能做到和下游任务适配 (具体图像描述待补充) 而此时需要调整的参数远远小于预训练模型的参数 (具体图像描述待补充) 文章主要聚焦于将LoRA在transformer注意力机制上使用因为这是transformer的精髓 (具体图像描述待补充) 分别用于表示四个线性层的参数 (具体图像描述待补充) 用于表示预训练模型的参数 用于表示自适应过程中的累积梯度更新 r就是低秩矩阵的秩 例如我们在W上加个LoRA假设W0为512*512就单单只看这部分的话全参数微调需要调整512*512 = 262144个参数使用LoRA后这262144个参数就冻结了此时增加两个低秩矩阵例如512*2和2*512那么此时需要调整的参数大小就为512*2+2*512 = 2048个参数 这样一来要训练的参数就减少了许多 当面对不同的下游任务时预训练模型用一个就行只需要保存的参数就是加入的低秩矩阵这样也能节省大量的存储空间 可以看个伪代码 class LowRankMatrix(nn.Module): def init(selfweight_matrixrankalpha=1

还没有评论,来说两句吧...