温馨提示:这篇文章已超过404天没有更新,请注意相关的内容是否还可用!

摘要:本篇内容主要介绍了Spark架构的解析以及大数据处理之道。Spark作为一个大规模数据处理引擎,其架构设计和优化对于大数据处理至关重要。本文通过深入解析Spark架构,探讨了其在大数据处理中的应用和优势,包括高效的数据处理、灵活的编程模型以及良好的可扩展性等。对于理解Spark在大数据领域的作用和价值,本文提供了有益的参考。

本文深入探讨了大数据处理框架Spark系列的第十五部分——Spark架构,文章详细阐述了Spark架构的核心组件及其特点,包括集群管理器、工作节点、应用程序和驱动程序等,该架构具备可扩展性、高效性和灵活性,能够处理大规模数据集的复杂分析,通过分布式计算,Spark架构展现出快速的数据处理能力,本文还介绍了Spark系列的其他文章目录,并简要概述了Spark的关键特性和优势。

目录结构清晰,方便读者快速定位所需内容,接下来的部分将详细介绍:

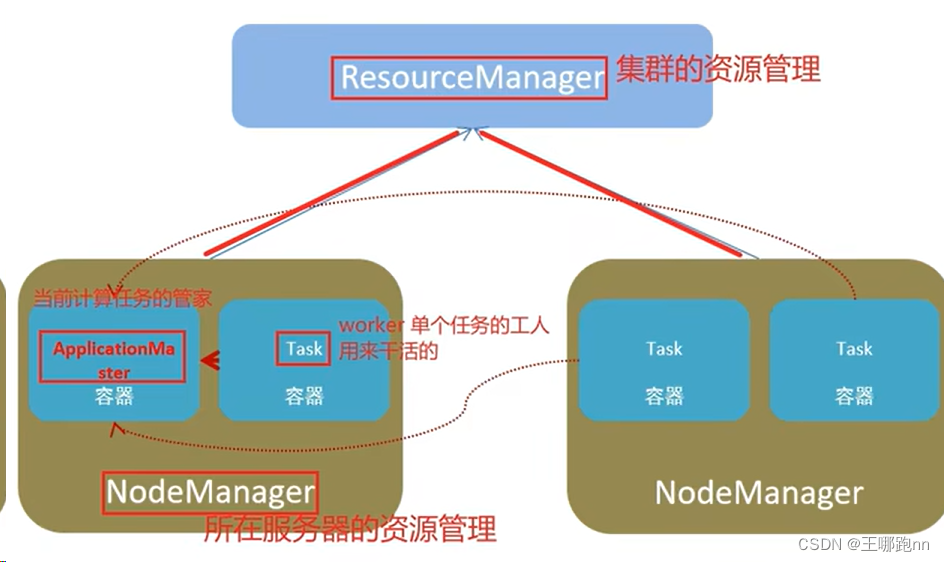

1、Yarn角色回顾:详细解释Yarn的角色分类,包括资源管理层面和任务计算层面的角色,并通过图片展示角色之间的关系。

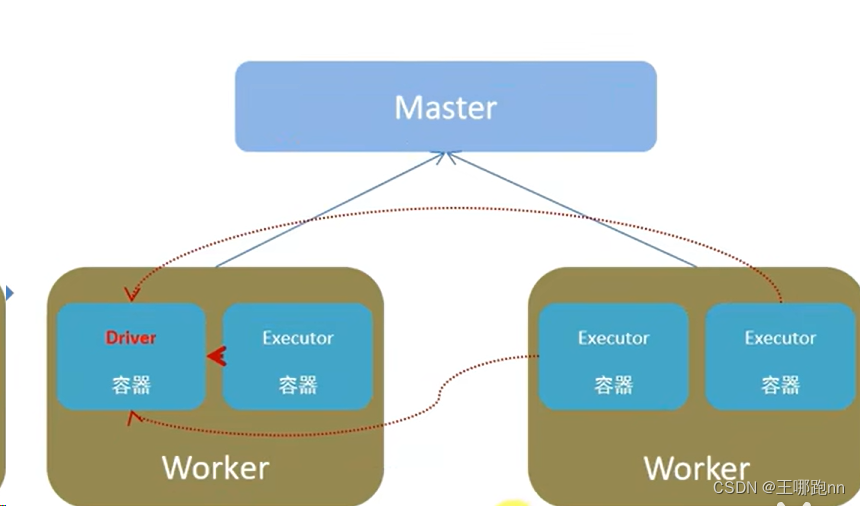

2、Spark运行角色:介绍Spark的运行环境角色,同样包括资源管理层面和任务计算层面的角色,通过图片展示角色间的关联。

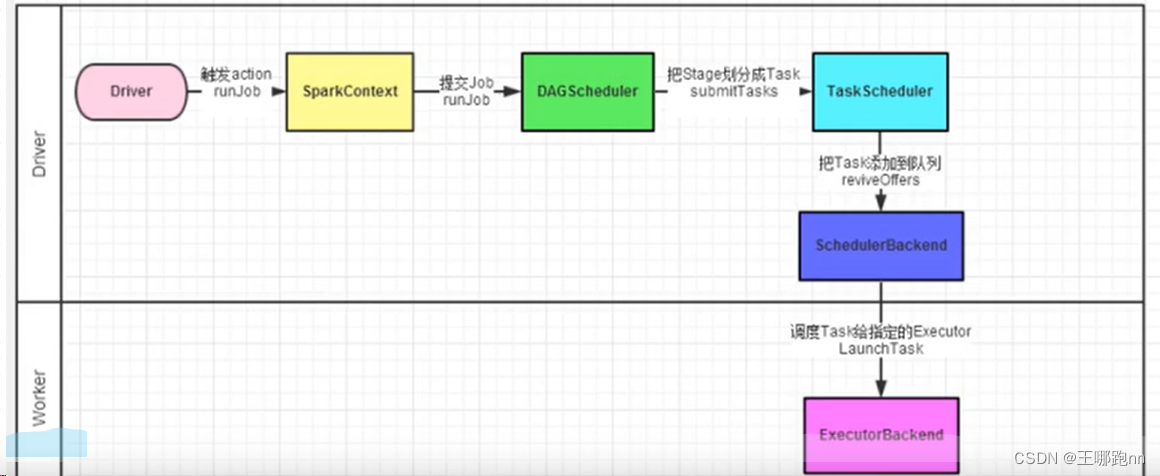

3、Spark的Job任务调度全流程:通过详细的解释和图片展示,让读者深入了解Spark的任务调度流程,包括任务提交、资源分配、任务调度等步骤。

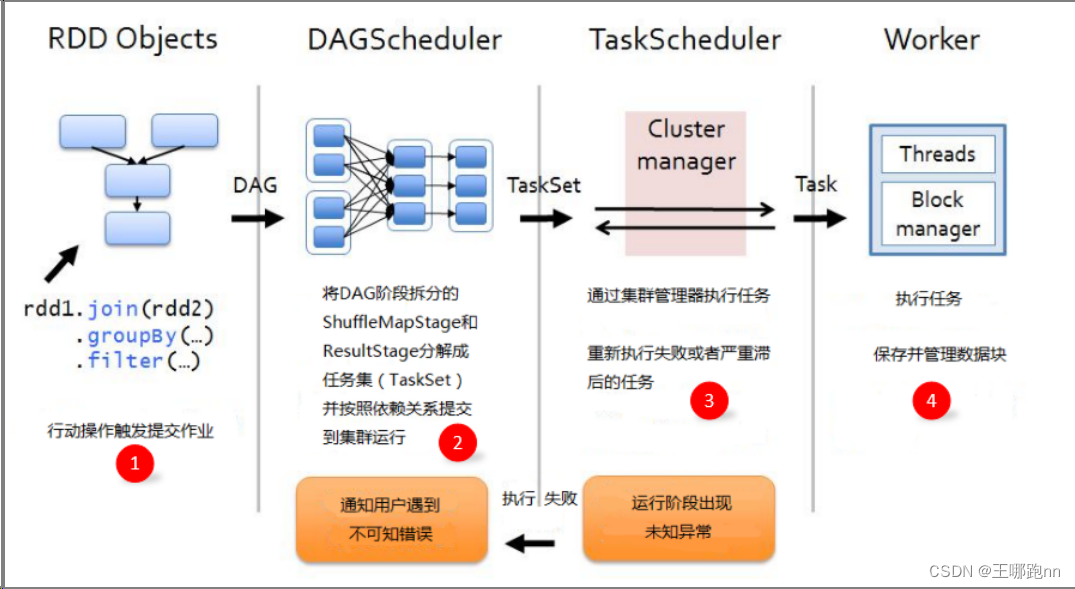

4、Spark的任务提交流程:介绍客户端向资源管理器发送请求、资源分配、任务执行等步骤,通过流程图展示整个过程。

5、Spark应用程序:深入解析Spark应用程序中的Job、Stage和Task的概念和关系,通过解释和示例帮助读者更好地理解。

大数据 - Spark系列文章目录如下:

1、大数据 - Spark系列《一》- 从Hadoop到Spark:大数据计算引擎的演进(CSDN博客)

2、大数据 - Spark系列《二》- 关于Spark在Idea中的一些常用配置(CSDN博客)

3、...(其他系列文章省略)

随着文章的深入,读者将逐渐了解并掌握Spark在大数据处理领域的核心技术和应用,本文为理解Spark架构及其运行机制提供了重要的基础。

还没有评论,来说两句吧...