温馨提示:这篇文章已超过405天没有更新,请注意相关的内容是否还可用!

摘要:,,NVIDIA CUDA Python编程框架——Warp开发文档第一章介绍了该框架的基础概述和入门知识。该章节详细阐述了CUDA编程的基本概念,包括GPU计算、并行计算等,并提供了Python编程语言的集成环境。通过本章的学习,读者可以掌握Warp开发框架的基本使用方法,为后续深入学习CUDA编程打下基础。

本章介绍了CUDA编程的基础知识,详细阐述了CUDA架构和Python语言的结合方式,内容包括CUDA编程模型的各个方面,如并行计算、内存管理、线程管理等,也介绍了Python在CUDA编程中的应用,包括Python与CUDA的集成方式、Python CUDA编程环境的搭建等,对于初学者来说,这是一份不错的CUDA编程入门指南。

文章目录

1、NVIDIA CUDA Python编程框架--Warp开发文档:Basics

初始化

* 在使用Warp之前,需要使用wp.init()方法进行初始化,启动CUDA环境并配置相关参数,初始化过程中,Warp将打印启动信息,包括可用的计算设备、驱动程序版本以及任何生成的内核代码的位置。

内核

* 在Warp中,计算内核被定义为Python函数,并使用@wp.kernel装饰器进行注释,内核函数是运行在GPU上的主要计算逻辑,可执行并行计算任务。

* 内核函数与CUDA内核具有1:1的对应关系,可以通过wp.launch()启动内核,并指定线程数量、输入参数和设备等信息。

示例:更改内核缓存目录

* Warp使用缓存机制存储编译后的内核代码,以提高性能,可以在调用wp.init()之前和之后更改生成和编译的内核代码的位置。

数组

* 内存分配通过wp.array类型公开,数组可以包装在主机(CPU)或设备(GPU)内存中的底层内存分配,数组是强类型的,存储内置值的线性序列。

* 数组的分配方式与PyTorch类似,可以使用wp.empty()、wp.zeros()等函数分配数组,Warp还支持从NumPy数组初始化数组,并将数据自动传输到指定设备。

用户函数

* 用户可以使用@wp.func装饰器编写自己的函数,这些函数可以在同一模块内的内核中自由调用并接受数组作为输入。

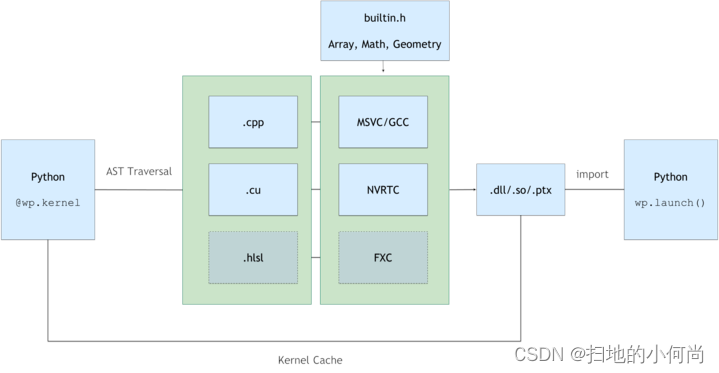

编译模型

* Warp使用Python->C++/CUDA编译模型,从Python函数定义生成内核代码,所有属于同一模块的内核将在运行时编译为动态库和PTX,然后在应用程序重新启动之间缓存结果,以实现快速启动。

语言详情

* 为了支持GPU计算和可微分性,Warp存在一些与CPython运行时之间的差异。

内置类型

* Warp支持许多类似于高级着色语言的内置数学类型,如vec2、vec3、vec4、mat22、mat33、mat44、quat等,所有内置类型都具有值语义。

强类型特点

* 与Python不同,在Warp中,数据类型更加严格,这一点在并行计算和GPU编程中尤为重要,因为它确保了数据的一致性和可预测性。

对于初学者来说,理解CUDA编程的基础知识和Python与CUDA的集成方式至关重要,建议在介绍内核部分时增加一些关于并行计算策略和线程管理的实例,以帮助读者更好地理解其在实际应用中的作用,对于内存管理和数据类型部分,可以进一步解释如何在Warp中有效地管理内存和确保数据的安全传输,对于用户函数和编译模型部分,可以给出一些实际的应用场景和示例代码,以帮助读者更好地掌握这些概念,对于语言详情和内置类型部分,可以进一步解释与CPython的差异以及为什么这些内置类型在GPU编程中是有用的。

还没有评论,来说两句吧...