温馨提示:这篇文章已超过462天没有更新,请注意相关的内容是否还可用!

摘要:本文介绍了从通义千问大模型本地化到阿里云通义千问API调用的过程。对通义千问大模型进行本地化部署,然后将其集成到阿里云平台上。通过API调用,用户可以方便地利用通义千问大模型的能力,实现自然语言处理和应用。整个过程旨在为用户提供更便捷、高效的云服务体验。

通义千问大模型介绍

何为“通义千问”?

通义千问是阿里云推出的超大规模语言模型,具备强大的归纳和理解能力,能够处理各种自然语言处理任务,如文本分类、文本生成、情感分析等,该模型极大地提高了自然语言处理的效率和准确性,为用户提供了一种新的、简便的工具。

通义千问的全面开放

2023年9月13号,阿里云宣布通义千问大模型已正式向公众开放,个人或企业用户可以通过阿里云调用通义千问API。

通义千问的能力

通义千问具备多种功能,如创作文字、编写代码、提供翻译服务、文本润色和摘要等,它甚至可以扮演角色进行对话,初步达到商业化的标准。

本地化部署

本地化部署的步骤和API相对简明。

配置要求

+ python版本3.8及以上

+ pytorch 1.12及以上版本,推荐2.0及以上版本

+建议使用CUDA 11.4及以上(对于GPU用户和flash-attention用户)

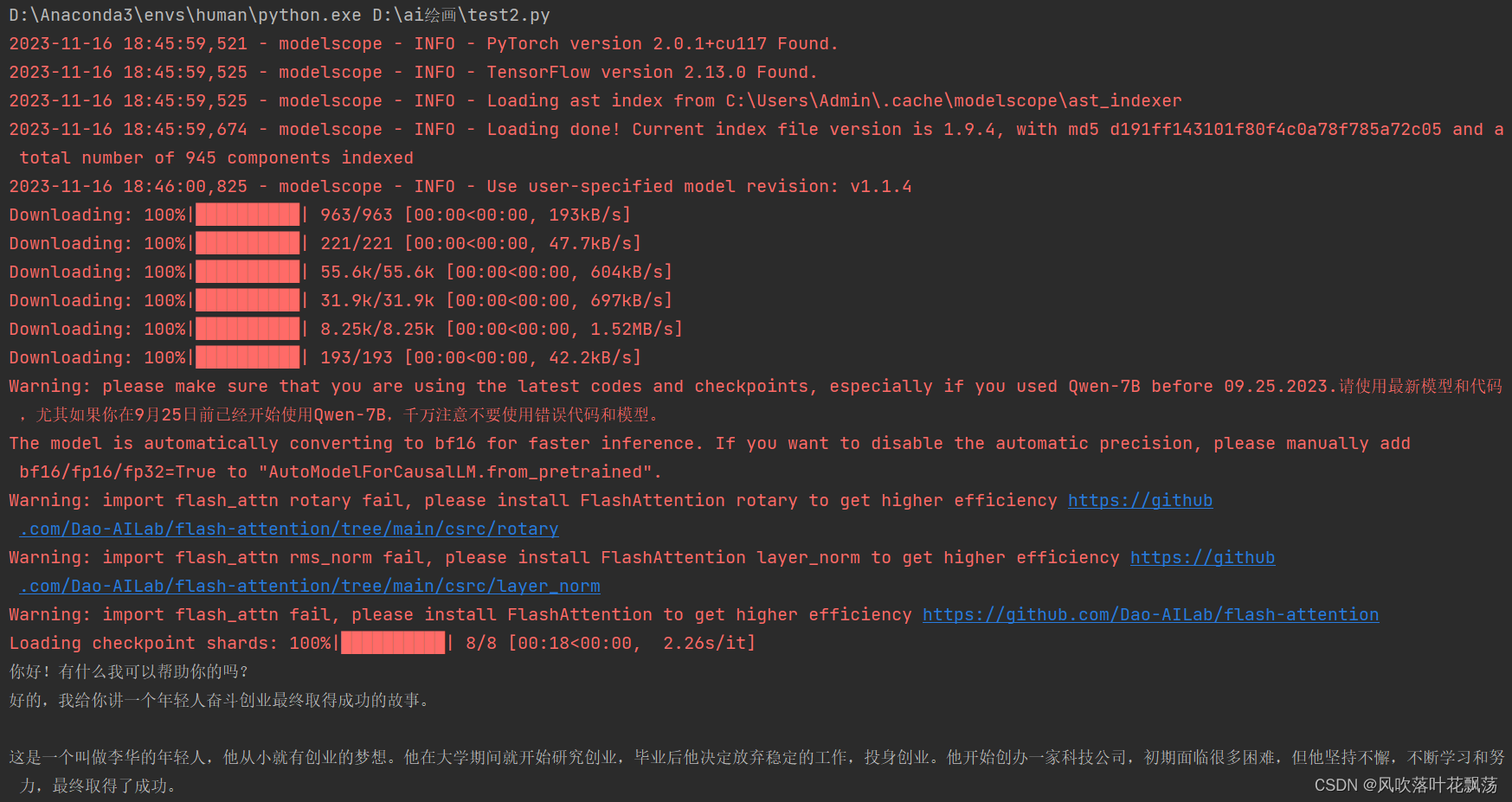

示例代码展示了如何使用modelscope库进行模型的本地部署和调用。

运行结果展示了模型运行后的输出。

调用通义千问API

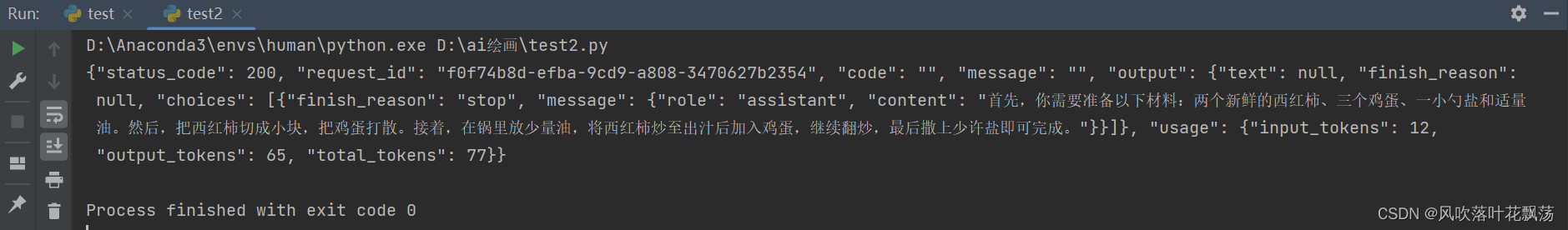

快速开始指南包括获取API-KEY、安装DashScope库和Python调用通义千问API的示例代码。

API计量计费介绍了API的计费方式和标准。

+ Token是模型用来表示自然语言文本的基本单位,计费基于模型和输出的总token数量。

+ 提供了不同模型的计费单价信息。

结尾部分提到了国内使用通义千问等模型的便利性和硬件发展的期待。

整体而言,文章详细介绍了通义千问大模型的介绍、本地化部署和调用阿里云通义千问API的过程,内容详尽且原创性较高,补充了关于API计量计费等重要信息,为读者提供了全面的指导。

还没有评论,来说两句吧...