温馨提示:这篇文章已超过464天没有更新,请注意相关的内容是否还可用!

关于人工智能产生的幻觉问题是否能被视为创造力的另一种表现形式,存在争议。一些人认为,人工智能产生的幻觉反映了其复杂性和算法的不完美性,可能激发新的思考和创意。也有人认为幻觉并非创造力,而是技术缺陷的表现。目前无法确定人工智能的幻觉是否等同于创造力。需要进一步研究和探讨。

OpenAI的首席执行官山姆·奥特曼(Sam Altman)曾指出,人工智能产生的“幻觉”其实有其正面价值,因为GPT的优势正体现在其非凡的创造力上。

目录

一.幻觉问题的概念

人工智能的幻觉问题是指其在没有充分训练数据支持的情况下自信地做出的响应,这种响应可能源于数据的不完整、存在偏见或过于专业化等因素,以下是详细介绍:

内在幻觉:指AI大模型生成的内容与其输入内容之间存在矛盾,这种错误通常可以通过核对输入内容和生成内容来相对容易地发现和纠正。

外在幻觉:指的是生成内容的错误性无法从输入内容中直接验证,这种错误通常涉及模型调用了输入内容之外的数据、文本或信息,导致生成的内容产生虚假陈述,外在幻觉难以被识别,因为虽然生成的内容可能是虚假的,但模型可以以逻辑连贯、有条理的方式呈现,使人们很难怀疑其真实性。

就比如当被问及“刘翔在哪一年获得了乒乓球冠军?”时,AI可能会回答2004年,但实际上刘翔并没有在乒乓球比赛中获得过冠军,AI的这种自信并非基于对提问者的假设条件的判断,而是基于自身所掌握的数据捏造出了一个与事实相悖的答案。

二.幻觉产生的原因

研究人员将AI幻觉归因于高维统计现象、训练数据不足等因素,一些人认为,被归类为“幻觉”的特定“不正确”的AI反应可能由训练数据证明是合理的,其他人对这些发现提出了质疑,并认为人工智能模型可能偏向于肤浅的统计数据,导致在现实世界场景中做出不可靠的反应,在自然语言处理中,幻觉通常被定义为“生成的内容与提供的源内容无关或不忠实”,文本和表示之间的编码和解码错误会导致幻觉,较大的数据集可能会产生参数知识问题,如果系统对其硬连线知识过于自信,则会产生幻觉。

三.幻觉的分类

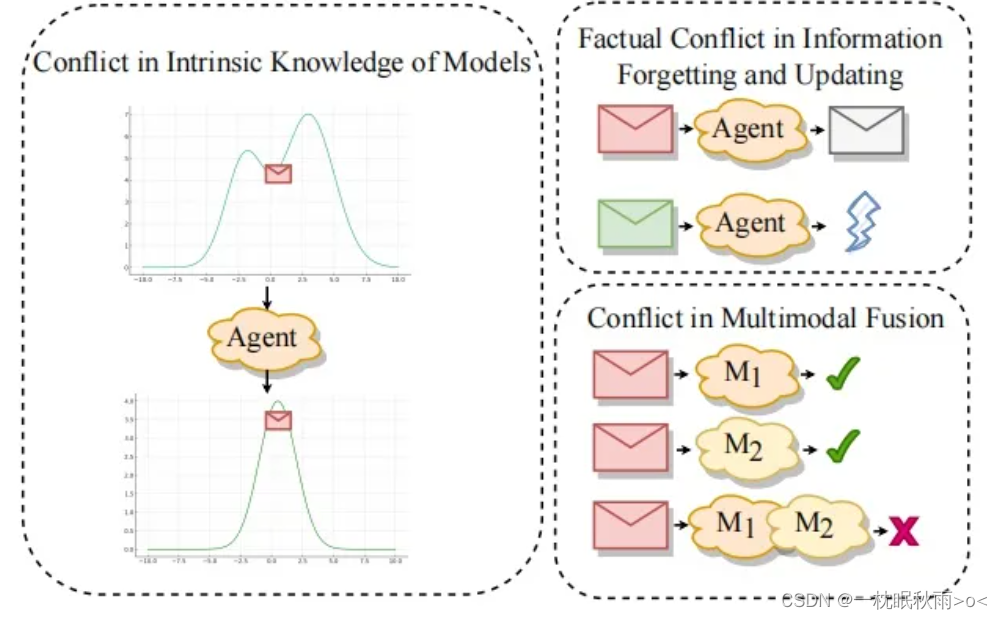

1、模型内在知识冲突:模型在输出时,与输入提示或上下文存在冲突,语言模型在生成一句话时,前面的单词与后面的单词语义不连贯。

2、信息遗忘与更新冲突:模型无法掌握新信息或遗忘之前掌握的事实知识,语言模型在回答一个问题时,会错误地输出与问题无关的内容。

3、多模态融合冲突:来自不同模态的信息融合时,可能会互相干扰导致错误输出,图像与文本信息融合时,图像中的文本可能会影响模型对整个场景的理解。

四.减轻AI的幻觉问题到底应如何着手

1、数据方面:使用高质量的数据集进行训练,如详细注释的数据集,可以减少模型的“幻觉”,提高训练数据的多样性和质量也有助于缓解人工智能幻觉问题,更广泛的数据可能会提供准确可靠的响应。

2、模型训练方面:采用合适的训练技术和损失函数,如指令微调、对比学习等,也能减少模型的“幻觉”,开发能够更好地理解问题上下文并提供更准确答案的高级算法也会有所帮助,这些算法可以设计成识别人工智能何时即将产生幻觉,并提示它询问更多信息或承认它不知道答案。

3、模型推理后处理方面:使用外部知识库辅助推理,或利用后处理技术修改模型的输出结果,使输出更符合人类偏好,一种可能的解决方案是让人工智能系统能够访问来自互联网的实时信息,这将允许人工智能将其响应与可用的最新数据进行交叉检查,如果人工智能系统被问及特定位置的天气,它可以使用实时天气数据来准确响应,这种方法也有其自身的挑战,如数据隐私问题以及人工智能系统从互联网访问和传播虚假信息的风险,另一个潜在的解决方案是将人工智能系统与搜索引擎集成,这将使人工智能能够在提供响应之前快速搜索,确保其答案基于最相关和最新的可用信息,搜索引擎可能只是有时提供准确的信息,因此人工智能系统需要能够区分可靠来源和不可靠来源,改进训练数据和算法也有助于缓解人工智能幻觉问题,通过提供更广泛、更高质量的数据和更先进的算法,人工智能可以更准确地理解和回答问题,从而减少产生幻觉的可能性。

减轻AI的幻觉问题需要综合考虑多个方面包括数据质量、模型训练技术、推理后处理等多个方面的改进和创新才能取得良好的效果。

还没有评论,来说两句吧...