温馨提示:这篇文章已超过390天没有更新,请注意相关的内容是否还可用!

摘要:本文介绍了LLaMA-Factory的指令增量微调,这是一个从零开始的过程。通过不断调整和优化指令,LLaMA-Factory能够逐步改进其性能并提升生成内容的准确性。这种增量微调的方法有助于提高人工智能模型的适应性和灵活性,使其能够更好地应对各种应用场景和需求。

大模型相关目录概览

一、大模型应用开发路径及思考

大模型应用包括但不限于部署微调、prompt/Agent应用开发、知识库增强、数据库增强、知识图谱增强、自然语言处理和多模态等大模型应用开发内容,初学者可以从零开始,逐步探索大模型的奥秘和应用开发之路。

二、大模型应用实用开发目录

1、大模型应用向开发路径及一点个人思考

2、大模型应用开发实用开源项目汇总

3、大模型问答项目问答性能评估方法

4、大模型数据侧总结

5、大模型token等基本概念及参数和内存的关系

6、大模型应用开发-华为大模型生态规划

7、从零开始的LLaMA-Factory的指令增量微调

一、LLaMA-Factory简介

LLaMA-Factory是一个开源的大模型微调框架,提供完备的接口,涵盖指令与界面两种使用形式,它在模型微调方式、参数配置、数据集设置、模型保存、模型合并、模型测试以及模型试用等方面,表现出强大的功能。

二、使用准备

1、拉取项目并部署相应环境(例如微调chatGLM3 6B需要流畅的环境,微调Qwen系列可能需要根据错误提示补充环境包),激活环境,如使用conda activate zwllama_factory命令。

2、下载模型到本地。

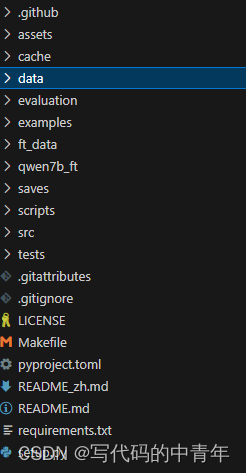

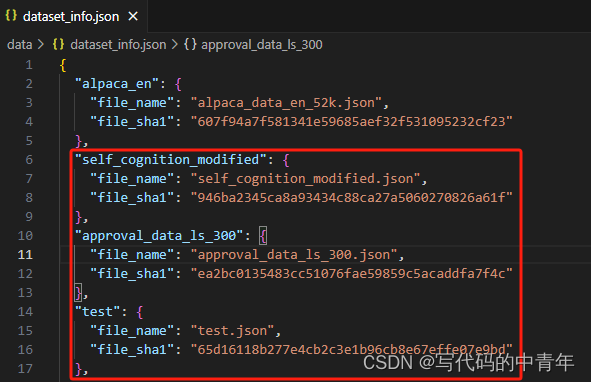

3、准备数据集,包括自我认知数据集、通用数据集和特定领域数据集,数据格式应遵循特定的指令微调格式,如alpaca格式,准备的数据集应上传到项目路径下的data文件夹,并在dataset_info.json下进行登记注册。

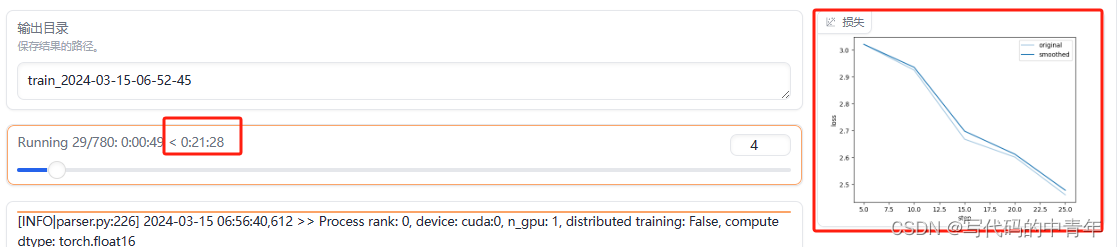

三、单卡微调

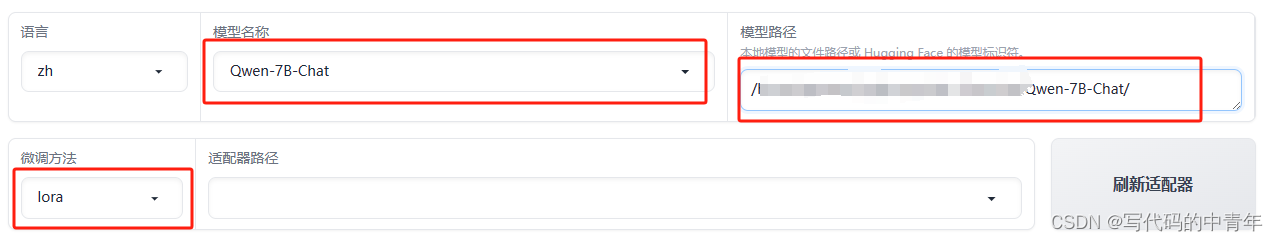

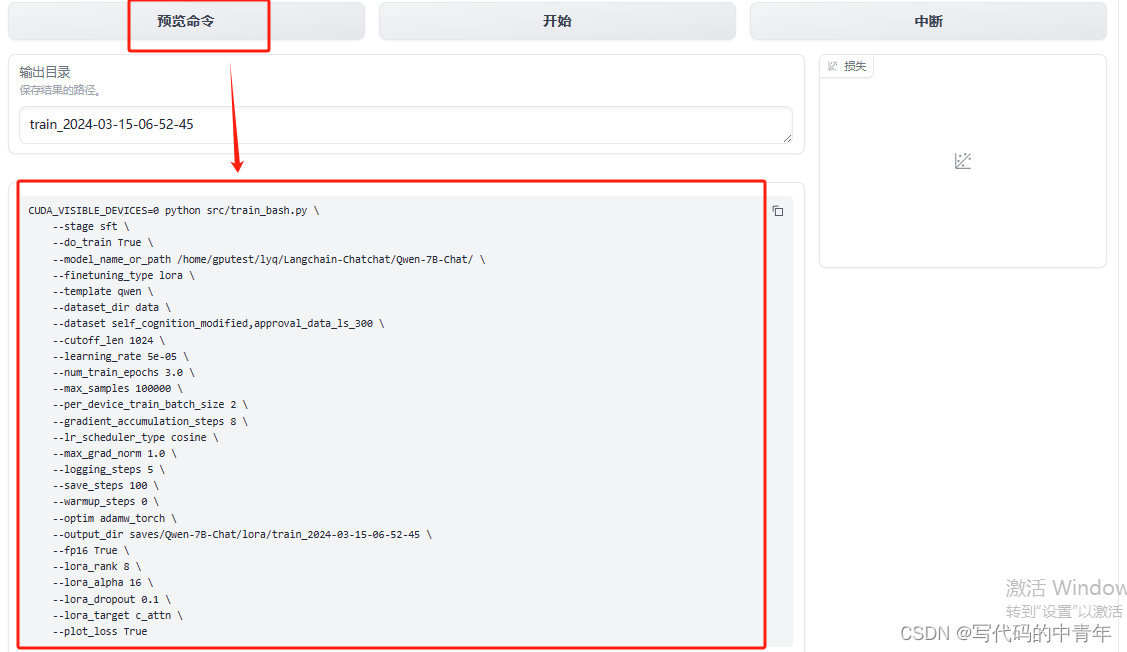

针对规模不大的大模型,如6B、7B等,界面化操作可以满足需求,通过配置页面信息来启动界面微调,随时可中断训练,包括测试集对微调模型性能评估、微调模型问答使用以及微调模型增量模型导出等操作。

四、多卡微调

对于多卡微调,需要新增config.yaml文件并配置相应的参数,运行特定的命令即可开始微调。

五、其他

更多详细信息可以通过访问开源项目进行了解。

希望这个修改后的版本更加清晰和完整,能够帮助您更好地组织和展示您的内容。

还没有评论,来说两句吧...