温馨提示:这篇文章已超过376天没有更新,请注意相关的内容是否还可用!

摘要:本文深入探讨了AI大模型的核心机制——注意力机制。文章不仅介绍了注意力机制的基本原理,还详细阐述了其在AI大模型中的应用。通过本文,读者可以了解如何在实际操作中运用注意力机制来提升AI大模型的性能。文章简洁明了,易于理解,是探索AI大模型的必读之作。

<h2>前言</h2>

在人工智能的辉煌剧场中,AI大模型扮演着主角的角色,而注意力机制(Attention Mechanism)则犹如主角的明亮双眸,为其赋予了前所未有的洞察力,特别是在自然语言理解(NLU)的领域,注意力机制已经成为推动技术革命的重要引擎,本文旨在深入浅出地探讨注意力机制的核心原理、不同变体,以及它在提升AI大模型自然语言理解能力中的至关重要性。

<h2>一、注意力机制简介</h2>

想象一下,当您沉浸在一本引人入胜的小说中时,您的眼球会自然而然地聚焦在关键的情节上,而忽略掉其他无关紧要的文字,这正是注意力机制在AI大模型中的运作方式:它允许模型在处理信息洪流时,智能地筛选并专注于那些对当前任务最为关键的部分,这种仿生学的设计使得模型在处理长距离依赖和复杂上下文关系时显得游刃有余。

<h2>二、注意力机制的工作原理</h2>

注意力机制通过为输入数据的每一个组成部分打分,来决定哪些信息值得“关注”,哪些应该“忽略”,这一过程包括以下几个步骤:

1、计算注意力分数:模型通过评分函数评估输入序列中每个元素的重要性。

2、软选择:使用softmax函数对这些分数进行归一化处理,得到每个元素的注意力权重。

3、加权求和:根据这些权重,模型对输入数据进行加权求和,从而生成一个富含关键信息的输出表示。

<h2>三、注意力机制的变体</h2>

随着深度学习技术的不断进步,注意力机制也演化出了多种形态,以适应不同的应用场景和需求,以下是一些常见的注意力机制变体。

1、自注意力(Self-Attention):这种机制让输入序列自己决定哪些部分值得关注,不依赖于任何外部信息,它通过计算输入序列中各个元素之间的相似性,为每个元素分配一个权重,在自然语言处理和图像识别等领域,自注意力机制取得了显著的成功。

2、双向注意力(Bidirectional Attention):这种机制结合了正向和反向的上下文信息,以捕获更全面的语义依赖关系,与单向注意力机制相比,双向注意力能够更好地捕捉长距离依赖关系,从而提高模型的性能,它在自然语言处理、语音识别等领域得到了广泛的应用。

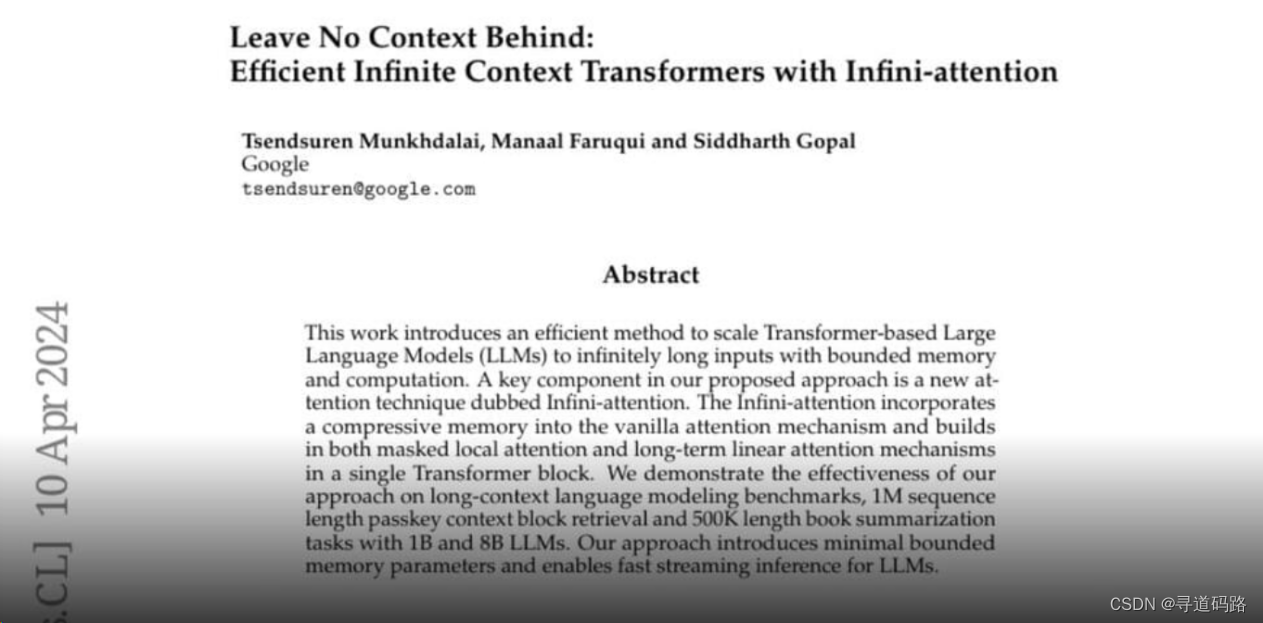

3、多头注意力(Multi-Head Attention):类似于多镜头拍摄,多头注意力机制通过并行处理不同的信息片段,然后将这些多角度的视野汇聚成一个全面的理解,它将输入序列分成多个子空间,然后在每个子空间中独立地进行自注意力计算,将所有子空间的注意力输出进行拼接或加权求和,得到最终的注意力表示,这种机制可以提高模型的表达能力,使其能够捕捉到不同层次的信息,谷歌最近提出了一种名为“无限注意力”(Infini-attention)的新机制,这个机制使得基于Transformer架构的大型模型能够在有限的计算资源下处理非常长的输入序列,它通过一种高效的方式扩展了模型处理上下文的长度,并在某些任务中取得了显著的成功,无限注意力机制的一个重要特点是其在内存使用上的高效性,这对于处理长文本数据的应用场景具有重要意义,这一创新为自然语言处理领域带来了新的可能性,特别是在处理长序列数据时,随着技术的不断进步和创新思维的涌现,我们期待着注意力机制能够在未来为AI大模型的发展带来更多的惊喜和突破,尽管注意力机制已经在自然语言理解等领域取得了显著的成就,但它的发展之路仍远未结束,未来的研究将继续探索如何更有效地整合注意力机制与其他先进技术以及如何优化其结构以处理更大规模的数据等议题,我们有理由相信,随着更多的研究和创新努力,注意力机制将继续引领人工智能领域的发展,开启一个更加智能的时代,本文旨在为读者提供一个关于注意力机制的全面概述和深入理解,若读者在阅读过程中有任何疑问或建议,欢迎随时提出,希望本文能为您带来启发和帮助!

还没有评论,来说两句吧...