摘要:本指南旨在为Mac用户提供一个从零开始的Ollama搭建教程。从基础配置到完成,详细指导用户如何在本地环境中轻松搭建Ollama。无论您是初学者还是专业人士,都可以按照本指南的步骤轻松完成配置,从零起步,成功搭建Ollama环境。

本指南旨在帮助读者在Mac本地成功搭建Ollama环境,从零开始配置Ollama,通过遵循本指南的步骤,读者可以轻松地了解如何在Mac上安装和配置Ollama,包括环境准备、安装步骤以及可能遇到的问题,本指南为开发者提供了一个简单易懂的教程,帮助他们充分利用Ollama提供的各项功能。

内容正文:

ollama-webUI简介

ollama-webUI是一个能够简化安装部署过程并能直接管理各种大型语言模型(LLM)的开源项目,本文将引导您在Mac OS上完成Ollama服务的安装,并通过webUI调用API完成聊天功能。

环境要求与目标

1、环境要求:使用Mac OS系统,并需要安装nodejs版本大于或等于18。

2、目标:成功运行ollama,启用webUI和API服务,以及启用RAG功能。

安装ollama

1、访问ollama官网进行下载。

2、选择Mac版本,点击download for mac进行下载。

3、解压下载得到的压缩包,并按照提示进行安装。

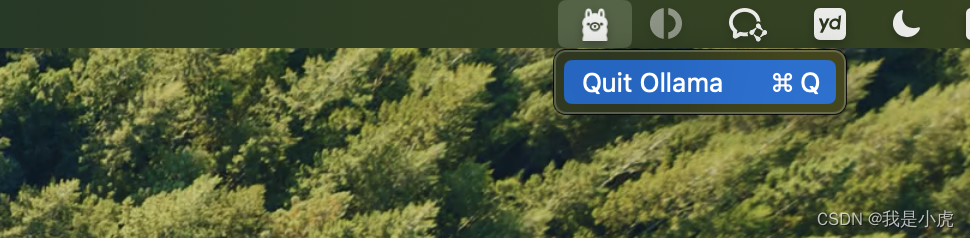

4、安装完成后,系统默认会启动ollama,您可以在电脑的右上角看到相关标记。

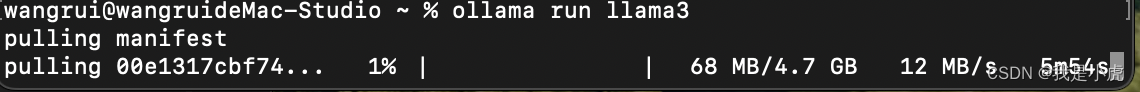

在命令行使用ollama

1、打开终端,输入“ollama -h”查看所有命令。

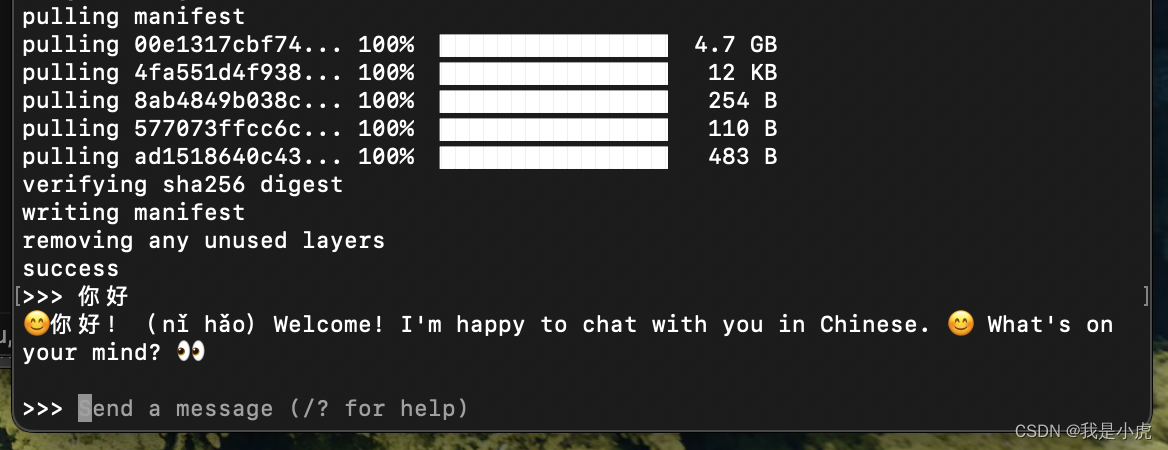

2、搜索并启动所需的模型,例如使用“ollama run llama3”。

3、下载完成后,即可与模型进行聊天,使用“control + D”退出聊天。

调用ollama的API

1、ollama提供API调用形式,可直接查看官网文档。

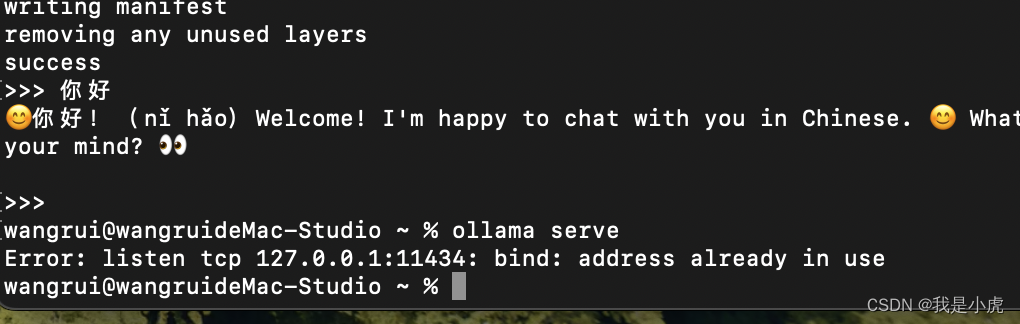

2、运行ollama serve启动服务,如遇端口被占用问题,请先退出ollama再运行。

3、ollama服务默认访问地址为http://127.0.0.1:11434,如在macOS上遇到IP和端口修改无效的问题,建议等待官方解决。

4、调用API时可能遇到跨域问题,建议搭建服务端解决此问题。

安装ollama-webUI和serve

详细描述了如何使用git clone命令克隆ollama-webUI项目、安装依赖、修改.env文件、运行webUI和服务端的步骤。

使用RAG功能

1、安装chroma数据库,参考官网文档获取安装指南。

2、运行chroma数据库服务。

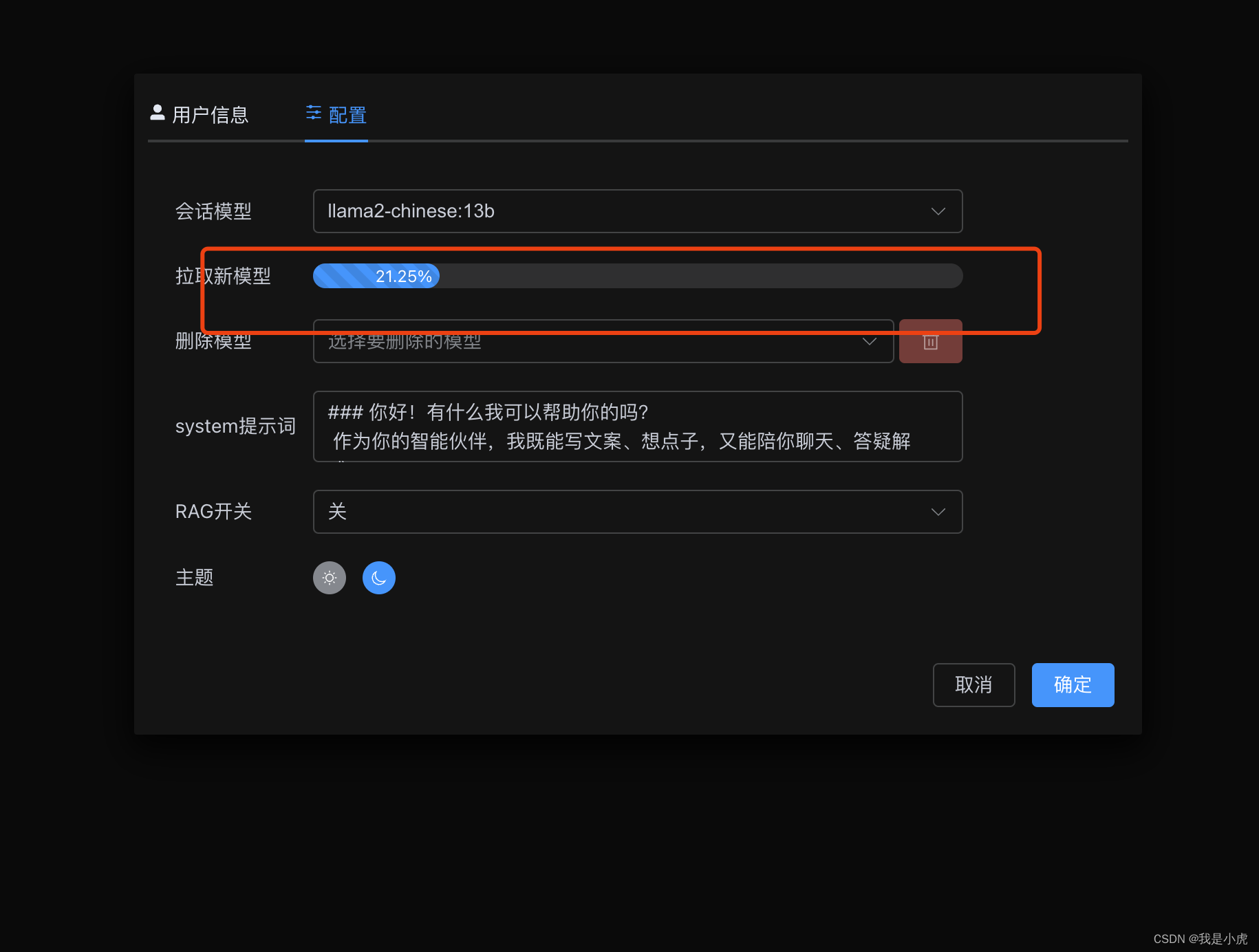

3、拉取ollama的嵌入式模型mxbai-embed-large。

4、调用serve/app/router里的接口,添加数据。

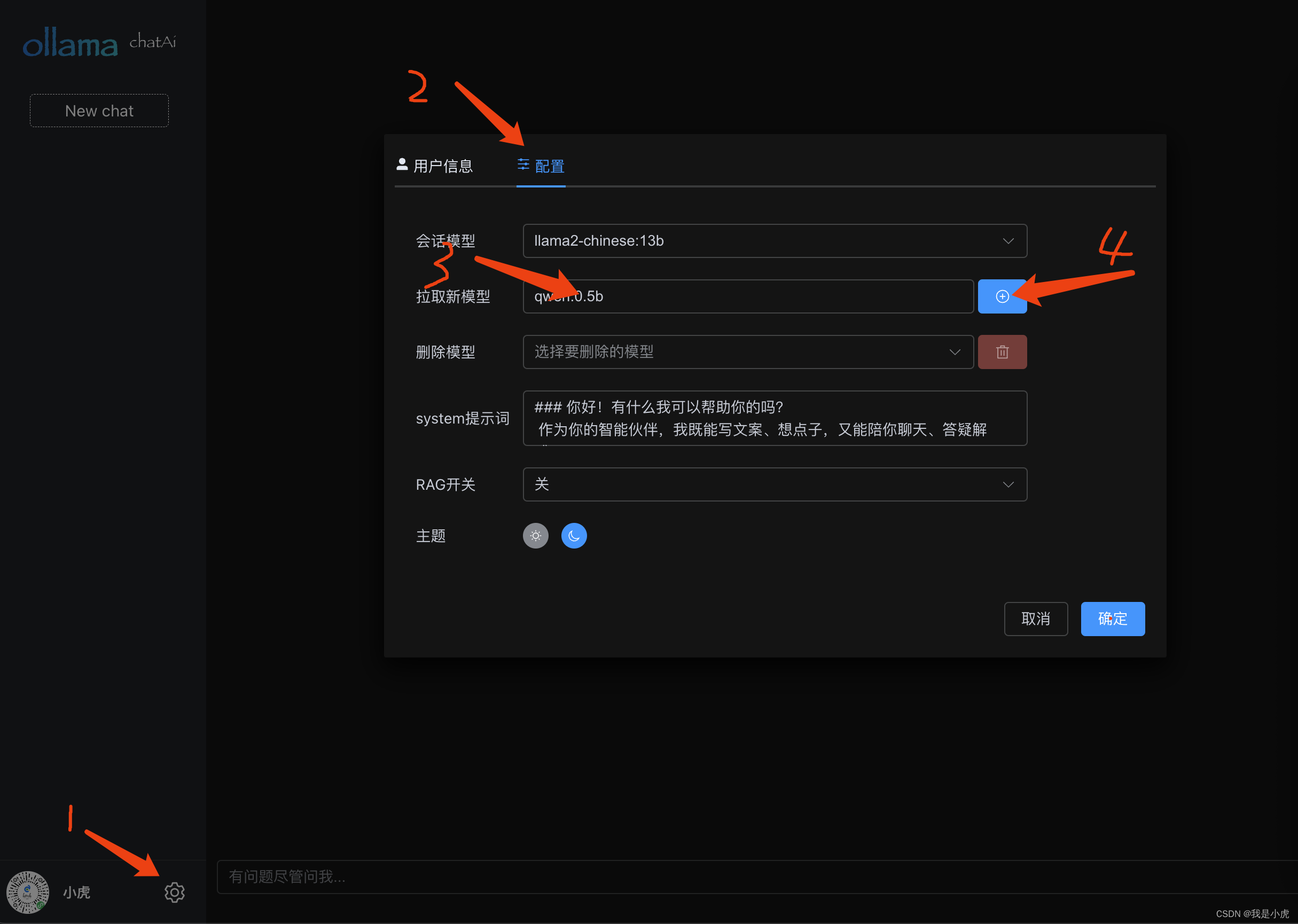

5、在webUI的设置对话框里,开启RAG开关,即可使用RAG功能进行聊天。

模型推理内存损耗

以llama2为例,详细介绍了如何监控模型推理过程中的内存损耗,为了更深入地了解相关信息,建议访问相关论坛、观看视频演示或咨询专业技术人员,提供了相关视频文件的插入方式建议。

注:为了方便读者更直观地了解每一步的操作过程和细节,建议在撰写指南时插入更多的截图或视频链接,以便读者更清晰地理解每一步的操作步骤。

还没有评论,来说两句吧...