摘要:本文介绍了使用PyTorch框架复现经典网络的过程,主要聚焦于LeNet5和AlexNet两个网络。通过详细解析网络结构、参数设置和训练过程,展示了如何利用PyTorch实现经典网络的复现,并深入探讨了这两个网络的特性和优劣。对于深度学习爱好者或研究人员来说,本文提供了有价值的参考和实践指导。

相关概念

对于数据表示(10,3,227,227),这表示有10张3通道的图像,每张图像的大小(特征数)为227x227。

通道数:卷积和输出通道数的数量。

特征数:特征图的大小。

步长(stride)和填充(padding):用于线性减小特征图的尺寸。

池化(pooling):非线性且高效地减小特征图的尺寸。

计算公式:hout = (hin + 2p - k) / s + 1,这是卷积神经网络中计算输出特征图尺寸的经典公式。

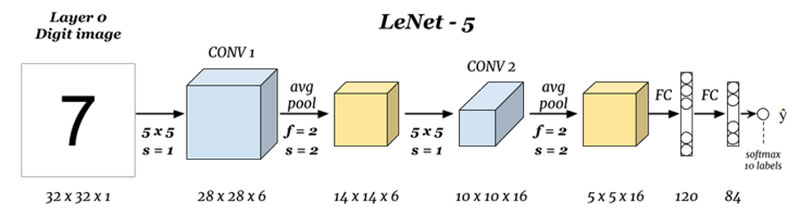

LeNet5:现代CNN的奠基者

LeNet的核心思想为“卷积+池化+线性”,在PyTorch中实现其架构的代码如下:(此处插入代码)

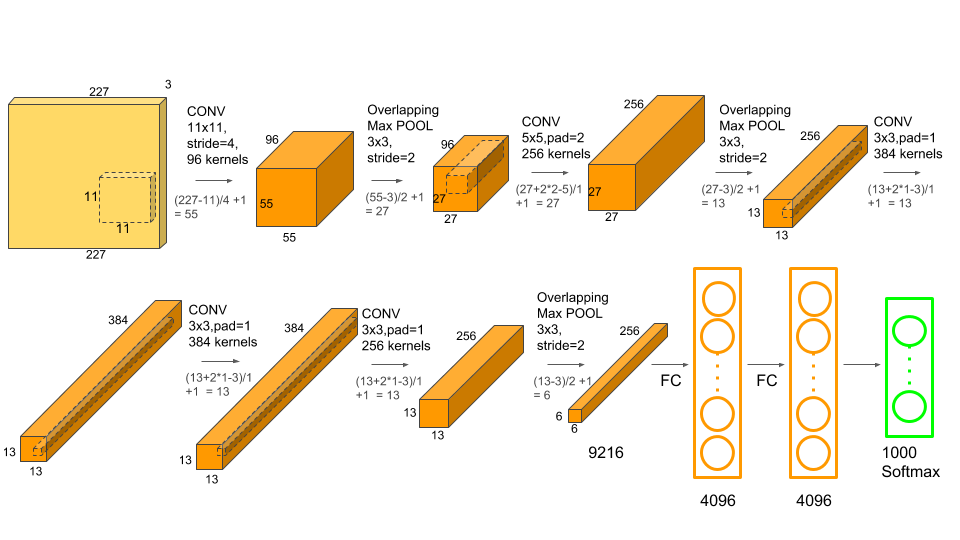

AlexNet:从浅层到深度

AlexNet的架构可以用文字描述为:输入→(卷积+池化)组合多次→(线性多次)→输出,与只有6层(包括池化层)的LeNet5相比,AlexNet主要做出了以下改变:

1、卷积核更小、网络更深、通道数更多,人们已经认识到图像数据天生适合多次提取特征,“深度”才是卷积网络的未来,AlexNet最大的卷积核只有11x11,且在第二个卷积层就改用5x5,剩下的层中都使用3x3的卷积核,小卷积核、多通道、更深的网络,这些都成为了卷积神经网络后续发展的指导方向。

2、使用了ReLU激活函数,摆脱Sigmoid与Tanh的各种问题。

3、使用了Dropout层来控制模型复杂度,控制过拟合。

4、引入了大量传统或新兴的图像增强技术来扩大数据集,进一步缓解过拟合。

5、使用GPU对网络进行训练,使得“适当的训练”成为可能。

接下来是AlexNet架构的复现,在PyTorch中的代码实现如下:(此处插入代码)

运行结果会显示网络各层的输出形状、参数数量等信息。

还没有评论,来说两句吧...