摘要:本文简要介绍了随机梯度下降算法(SGD)在机器学习领域的应用。SGD是一种优化算法,用于在训练模型时调整参数以最小化损失函数。它通过计算部分数据集的梯度来更新模型参数,从而加快训练速度。本文还讨论了SGD的优势和局限性,包括其在处理大规模数据集和高维参数空间时的效率和稳定性问题。理解SGD对于掌握现代机器学习技术至关重要。

随机梯度下降(Stochastic Gradient Descent)的Python代码示例

梯度下降概述

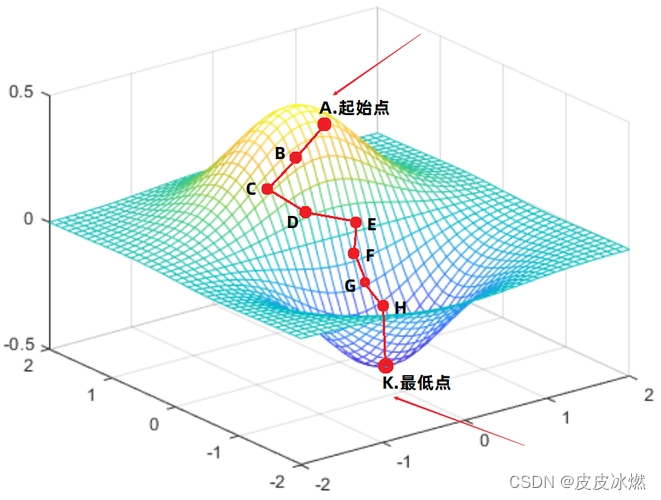

在机器学习领域,梯度下降扮演着至关重要的角色,它是一种优化算法,通过沿着由梯度定义的最陡下降方向进行迭代,以最小化函数,我们可以将其比喻为站在山巅,希望找到通往山谷最低点的最佳路径,梯度下降就如同引导我们寻找下山的最优路线一样。

梯度下降算法的原理简洁而优雅,从函数上的一个随机点开始,比如山巅的随机起点,计算该点处函数的梯度(即斜率),类似于在山上寻找最陡的坡度,我们沿着这个坡度方向迈进一步,再重新计算坡度,这个过程会反复进行,直到到达底部。

每一步的大小由学习率来决定,学习率太小可能会导致下降速度过慢,而学习率过大则可能使我们在最低点附近震荡,甚至跳过最低点,找到合适的学习率是算法成功的关键。

梯度下降的另一个优点是它的通用性,无论是简单的线性回归还是复杂的深度学习模型,几乎都可以应用梯度下降来进行优化,这使得它在解决各类机器学习问题时具有广泛的应用价值。

随机梯度下降(SGD)

随机梯度下降是梯度下降的一种变体,它在每次迭代时只使用一个样本进行计算,而不是使用整个数据集,这种方法的优点是计算效率更高,特别是在处理大规模数据集时,SGD对于在线学习和增量学习场景特别有用。

下面是一个简单的Python代码示例,展示如何使用sklearn库的SGDClassifier来实现随机梯度下降:

(此处插入Python代码示例)

通过这个示例,您可以更直观地了解随机梯度下降的实现方式,并能够在实践中应用它来解决机器学习问题。

梯度下降是机器学习中一种重要的优化算法,随机梯度下降作为其变体,在处理大规模数据时具有显著的优势,通过理解梯度下降的原理和参数调整技巧,以及掌握随机梯度下降的实践应用,将有助于您在机器学习的道路上取得更好的成果。

还没有评论,来说两句吧...