摘要:本篇文章介绍了Scrapy爬虫在爬取多个页面时的详细步骤,包括注释和教程。通过Scrapy框架,可以轻松实现网页数据的抓取和解析。文章详细解释了如何设置爬虫、处理翻页逻辑以及提取所需数据等内容。对于希望深入学习Scrapy爬虫并应用于实际项目中的读者,本文提供了有价值的指导和参考。

本文介绍了如何使用Scrapy爬虫框架进行多页面爬取,通过详细的步骤注释,阐述了如何设置Scrapy项目、定义Spider、处理URL和解析页面内容等关键步骤,该爬虫能够高效地从不同页面中提取所需数据,适用于数据抓取、分析和挖掘等场景。

分析网页并尝试获取多个页面的URL

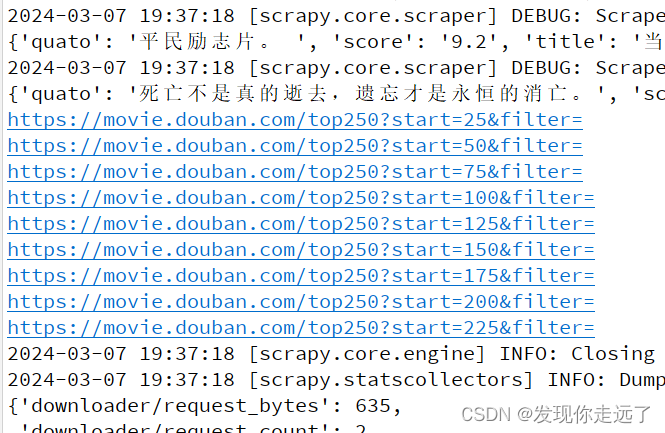

1、使用Scrapy框架进行网页爬取。

2、通过分析网页结构,尝试获取电影相关信息的选择器。

3、遍历页面,获取多个页面的URL,为了实现这一步骤,可以使用Scrapy的翻页逻辑或者通过解析页面内容找到更多的URL链接。

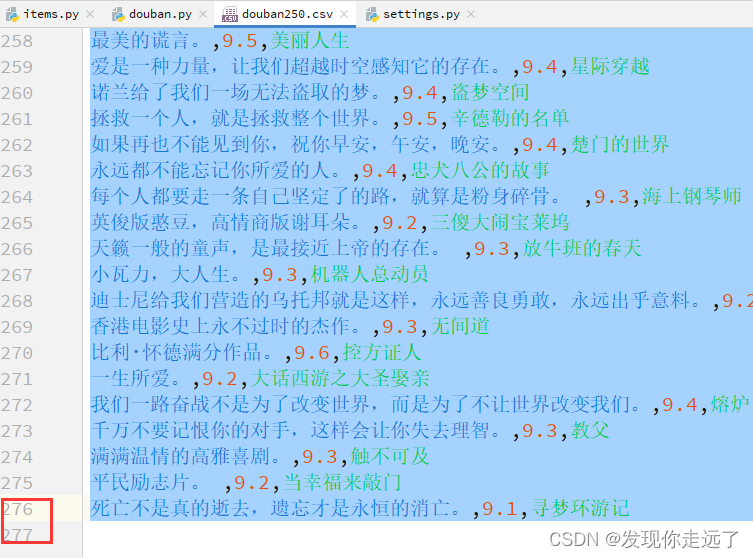

抓取250个电影的信息

1、定义MovieItem类,用于存储电影信息。

2、使用选择器提取电影标题、评分和影评等信息,根据网页的结构,可能需要使用CSS选择器或XPath选择器来定位这些信息。

3、将抓取到的电影信息通过yield语句交给管道处理,确保管道配置正确,以便存储或处理抓取到的数据。

三、使用start_requests进行初始请求

1、在Spider中定义start_requests方法,设置初始请求的URL。

2、使用yield语句发送请求,Scrapy会自动将响应内容交给parse方法进行解析,确保parse方法能够正确处理响应并提取所需的数据。

代码规范与优化

1、在导入模块时,尽量精简导入语句,避免导入不必要的模块。

2、在重写Spider的parse方法时,注意处理不同页面的逻辑,避免代码冗余,根据网页的结构和逻辑,可能需要为不同的页面编写不同的处理逻辑。

3、提供修正后的代码示例,展示如何应用上述知识和技巧,在代码中,注意处理可能出现的异常情况,如网络请求失败、数据格式错误等,遵守网站的使用协议和法律法规,避免非法爬取和滥用数据等行为。

以下是修正后的代码示例:

import scrapy

from scrapy import Selector

from your_project.items import MovieItem # 导入自定义的MovieItem类

class DoubanSpider(scrapy.Spider):

name = 'douban' # 爬虫名称

start_urls = ['https://www.example.com'] # 设置初始请求的URL,根据实际情况修改

allowed_domains = ['example.com'] # 设置允许的域名,根据实际情况修改

custom_settings = {} # 自定义设置,例如设置并发数等

headers = {} # 设置请求头信息,根据实际情况添加必要的请求头信息,如User-Agent等

base_url = 'https://www.example.com' # 基础URL,方便构建相对路径的URL

movie_list_selector = '.movie-list' # 电影列表的选择器,根据实际情况修改选择器路径

def start_requests(self): # 重写start_requests方法

for url in self.start_urls: # 遍历初始URL列表

yield scrapy.Request(url=url, headers=self.headers) # 发送带有自定义请求头的请求

def parse(self, response): # 重写parse方法以处理响应内容

movie_list_items = response.css(self.movie_list_selector).getall() # 使用选择器获取电影列表元素

# 接下来可以根据电影列表元素的属性进一步提取电影信息,如标题、评分等

for movie_item in movie_list_items:

# 提取电影信息并创建MovieItem实例

movie = MovieItem()

# 使用选择器提取电影标题、评分等信息并填充到movie对象中

# ...

yield movie # 提交电影信息给管道处理上述代码仅为示例,实际开发中需要根据目标网站的结构进行相应的调整和优化,遵守相关法律法规和道德准则,合法合规地进行网页爬取和数据获取。

还没有评论,来说两句吧...