摘要:本文介绍了AI分布式训练中的DDP(数据并行)技术,详细解释了其原理和应用。通过实战案例,展示了DDP技术在提高AI模型训练效率和性能方面的优势。文章涵盖了从理论到实践的全面内容,帮助读者更好地理解和应用DDP技术。关键词:AI分布式训练、DDP技术、数据并行、实战应用。

本文将详细介绍AI分布式训练中的DDP(数据并行)技术,通过原理讲解和实战演示,展示DDP技术如何加速模型训练和提高训练效果,本文还将探讨DDP的扩展性和优化策略,分析其面临的挑战和限制,为分布式训练领域的研究人员和工程师提供有价值的参考和指导。

DDP技术扩展性

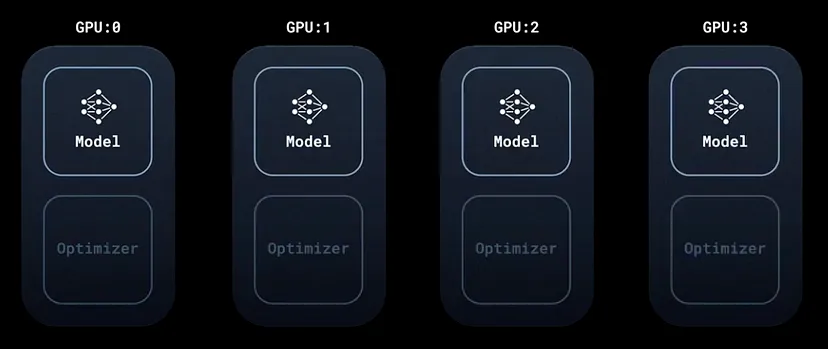

DDP技术以其出色的扩展性著称,可以轻松扩展到多节点环境,在初始化进程组时,只需指定所有节点的IP地址和端口,并确保每个节点上的GPU数量正确配置,DDP即可自动平衡负载,确保每个GPU都有相同数量的数据批次进行处理,这一特性使得DDP在大型模型和数据集的训练中表现出色。

DDP优化策略

为了进一步提高DDP的性能,可以采取以下优化策略:

1、梯度累积:当GPU内存不足以容纳整个batch的大模型时,可以使用梯度累积来模拟更大的batch size,在每个小batch上计算梯度并累加,而不是立即更新模型参数,以提高模型的收敛速度和性能。

2、混合精度训练:通过同时使用32位和16位浮点数进行训练,节省GPU内存,同时不会对模型的准确性产生重大影响,PyTorch提供了自动混合精度训练的API,可以与DDP结合使用,进一步提高训练速度。

3、优化通信效率:DDP使用NCCL或Gloo等库进行GPU之间的通信以同步梯度,通过优化通信策略,如使用压缩技术减少通信量,或采用异步通信策略减少通信延迟,可以有效提高训练速度。

DDP的挑战和限制

尽管DDP具有许多优点,但也面临一些挑战和限制:

1、内存消耗:DDP需要将整个模型和数据复制到每个GPU上,可能导致大量内存消耗,对于非常大的模型或数据集,可能需要使用梯度累积或减小batch size来适应内存限制。

2、跨节点通信:扩展到多节点环境时,跨节点通信可能受到网络延迟和带宽的影响,影响训练速度和稳定性,优化通信策略可以缓解这一问题。

3、模型同步开销:在DDP中,每个GPU都需要与其他GPU同步模型参数和梯度,同步操作可能成为训练的瓶颈,特别是在GPU数量较多或网络延迟较高的情况下,这一挑战更为突出。

案例分析与展望

本文详细介绍了DDP技术的原理、应用、扩展性、优化策略以及面临的挑战和限制,通过案例分析,展示了DDP在实际应用中的效果,展望未来,随着硬件和网络技术的进步,DDP技术有望变得更加高效和易于使用,随着AI领域的不断发展,DDP技术将在更多领域得到应用,为分布式训练领域的研究人员和工程师提供更多机会和挑战。

还没有评论,来说两句吧...