摘要:本文介绍了AI大模型的探索之路,重点阐述了语言模型预训练的基础认知。文章指出预训练是训练大型语言模型的关键步骤,通过在大规模语料库上进行训练,提高模型的泛化能力和鲁棒性。本文为读者提供了关于大语言模型预训练的基础知识和理解,为后续深入探索AI大模型领域提供了有价值的参考。

文章目录

在人工智能的宏伟蓝图中,大语言模型(LLM)的预训练是构筑智慧之塔的基石,预训练过程通过调整庞大参数空间以吸纳数据中蕴含的知识,赋予模型从语言理解到文本生成等多样化能力,本文将深入探讨预训练过程中的技术细节、所面临的挑战、通信机制、并行化策略以及如何通过融合这些技术提升预训练的效率和性能。

预训练流程分析

预训练大语言模型涉及对海量参数的优化,这个过程始于一个简单的前提:给定输入(X)和相应的输出(Y),模型通过不断迭代学习,不断更新修改参数,使生成的输出尽可能接近真实结果(Y)。

当模型输出与实际结果之间的差距,通常由损失函数量化,减小到一个可接受的阈值时,我们可以认为预训练过程达到预期效果,在这个过程中,模型参数经历从随机初始化到精细调整的转变,逐步捕捉并内化语言的复杂规律。

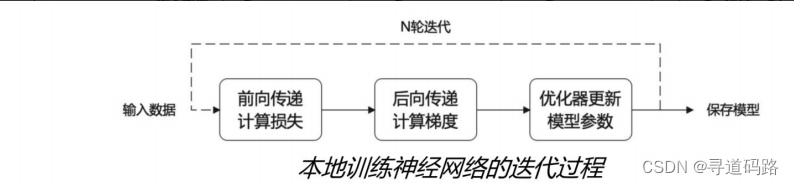

预训练流程的核心包括:输入Batch数据、前向传播计算损失、后向传播计算梯度、优化器更新大模型参数以及反复迭代循环。

预训练面临的两大挑战

随着模型规模向百亿甚至千亿参数迈进,预训练任务面临两大主要挑战:显存效率和计算效率。

1、显存效率:模型参数量的巨大使得即便是最先进的GPU也难以单独容纳所有参数,这直接导致了显存溢出的问题,一个具有1750亿参数的GPT-3模型,其参数本身就需要消耗约700GB的显存,加上Adam优化器的状态,总共需要超过2.8TB的显存。

2、计算效率:巨大的模型参数和海量的训练数据使得计算量激增,导致单机训练时间长达数年,这对于计算资源的有效利用提出了极大的挑战。

预训练网络通信

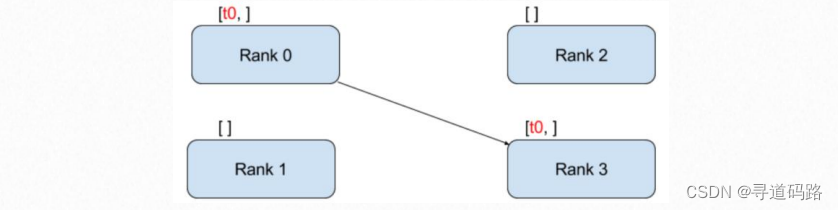

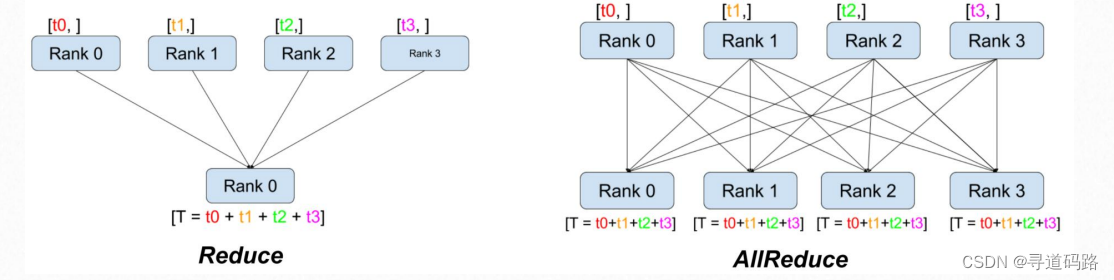

网络通信是多机多GPU预训练过程中不可或缺的环节,点对点通信方式虽然成本低,但传输速率较慢,成为速度瓶颈,相对而言,集体通信方式通过同时进行多个进程间的数据传输,大大提升了通信速度,但相应地增加了成本,选择合适的通信方式对于提高预训练效率至关重要。

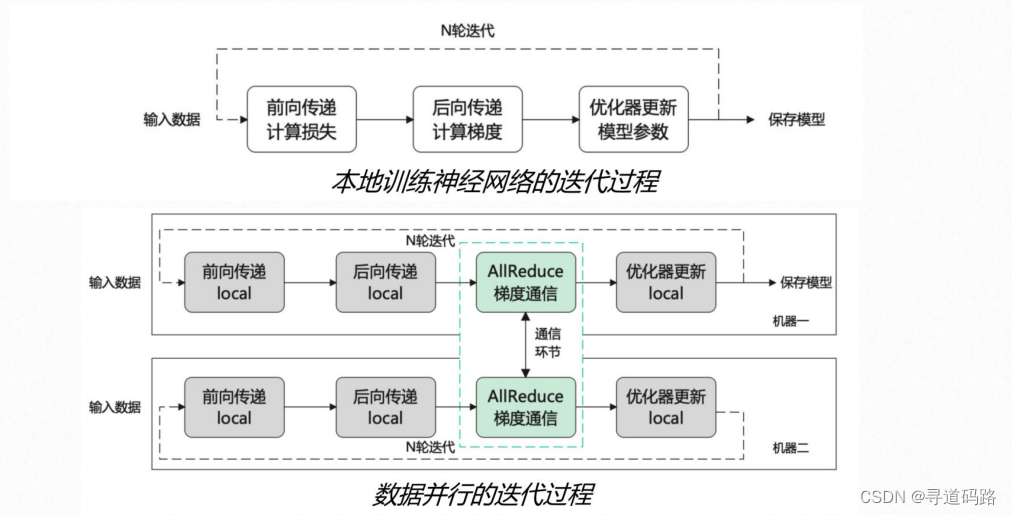

预训练数据并行

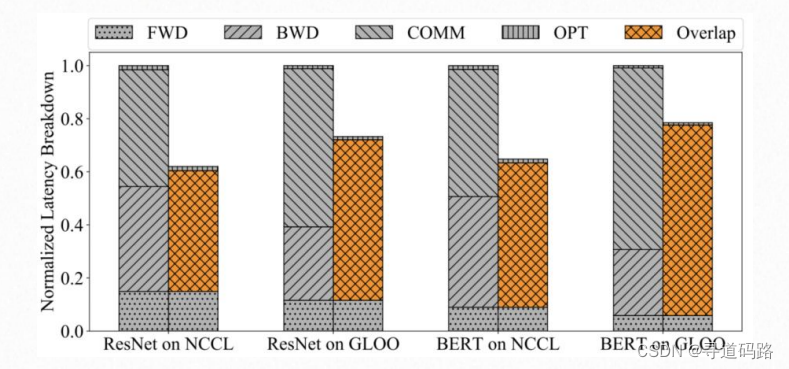

数据并行是处理大规模数据集的常用策略,它通过将整个数据集分割成多个子集,每张GPU分配一部分数据独立进行模型训练,数据并行三个提高效率的技巧包括梯度分桶、计算与通信重叠以及跳过梯度同步。

预训练模型并行

当单张GPU无法装载整个模型时,模型并行成为解决之道,流水线并行和张量并行是两种主要的模型并行方式,流水线并行是将不同的层划分到不同的GPU上,而张量并行则是将单个独立层划分到不同GPU上。

预训练3D并行

3D并行是一种综合性策略,结合了数据并行、张量并行和流水线并行的优势,在这种框架下,每种并行方法都扮演着不同的角色:数据并行提供高效的计算利用率,张量并行减少单个层的显存占用,流水线并行降低跨层通信的频率。

预训练代码示例

这里是一个简单的预训练代码示例,使用PyTorch和Transformers库:

(代码示例)

预训练大语言模型是一项充满挑战且极具价值的工作,随着模型规模的不断扩大和数据量的激增,如何高效地进行预训练已成为AI研究的核心议题,3D并行作为一种先进的预训练框架,不仅解决了单一GPU资源限制的问题,还通过合理的资源分配和优化手段显著提高了预训练的性能,未来的预训练技术将继续探索新的边界,并将机器学习模型推向前所未有的高度。

希望这篇文章对您有所帮助,若有任何建议或疑问,请随时与我联系,感谢您的关注和支持!

还没有评论,来说两句吧...